mdx利用手引き(利用者編)¶

お知らせ¶

メンテナンスの予定¶

未実装の機能について¶

2021年9月22日現在、未実装の機能は以下の機能です。

権限プロファイル(mdx管理者、機関管理者の権限を詳細に制御する機能のため、運用方針と密な関係にあるため運用方針を含め仕様策定中)

その他、UI/UX改善に向けた修正は随時行っております。

利用手引き¶

1. はじめに¶

1.1. プロジェクト申請ポータルとユーザポータルについて¶

mdxでは、 プロジェクト申請ポータル と、 ユーザポータル 2つのポータルを利用者に提供します。

1.1.1. プロジェクト申請ポータルの機能¶

プロジェクト申請ポータルでは、主にプロジェクト申請関連作業およびポイント購入申請関連作業を行います。 プロジェクト申請ポータルは、以下の機能を提供します。

プロジェクトの申請

プロジェクト申請状態の確認および修正

プロジェクト申請の取り消し

過去のプロジェクト申請を流用した再申請の実施

ポイント購入申請

ポイント購入履歴の確認および支払方法の編集

ポイント購入申請の取り消し

過去のポイント購入申請を流用した再申請の実施

ポイント購入を許可するユーザの追加

クレジットカードによるポイント購入決済

1.1.2. ユーザポータルの機能¶

ユーザポータルでは、主に仮想マシンの操作などを行います。 ユーザポータルは、以下の機能を提供します。

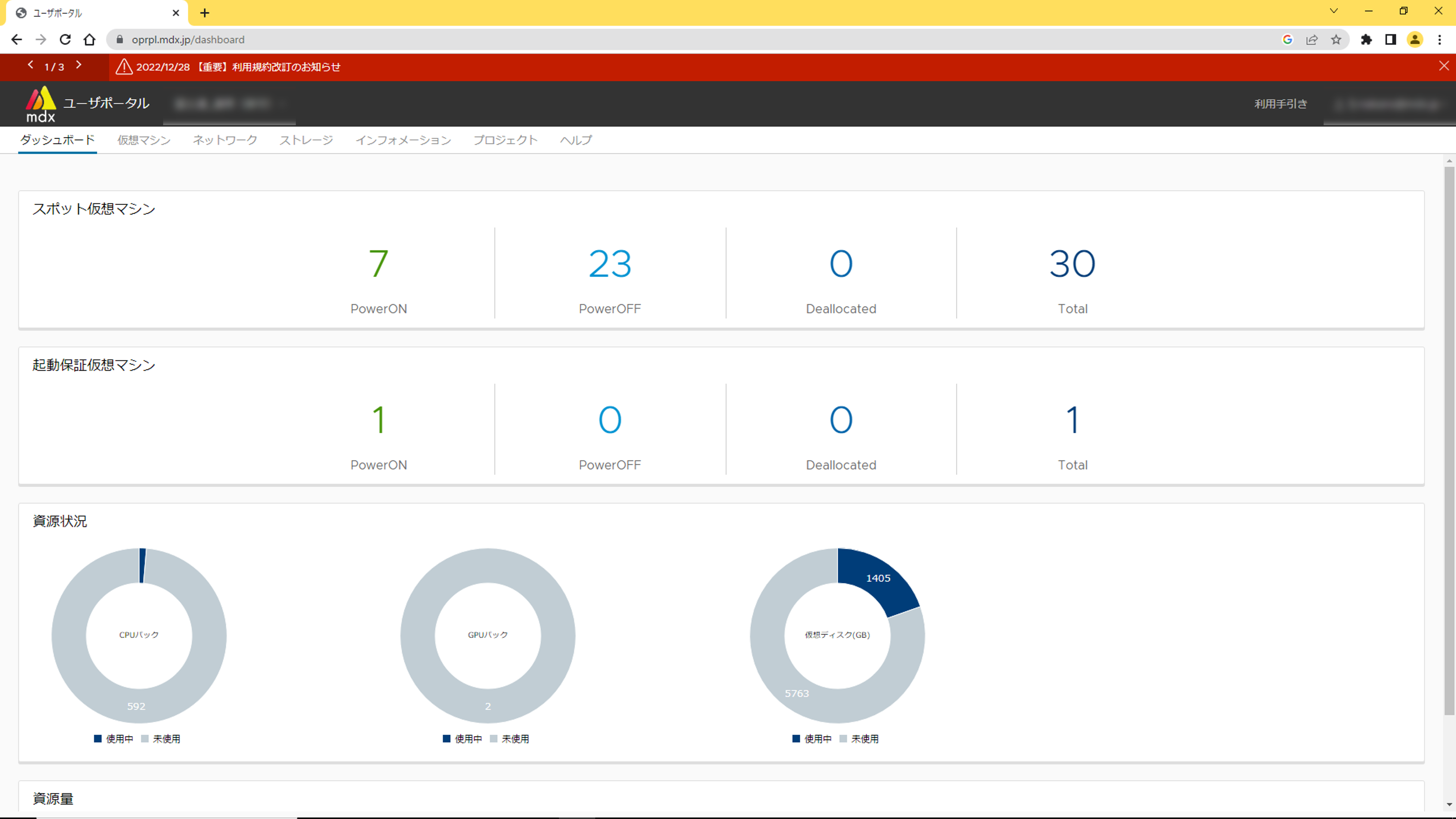

プロジェクトに割り当てられた資源の利用状況の確認(ダッシュボード)

仮想マシンの作成(デプロイ)・削除

仮想マシンの操作

ISOイメージ管理・アップロード

ネットワーク管理

ストレージ管理

お知らせ・操作履歴

プロジェクト管理(プロジェクト情報確認、プロジェクトユーザ追加・削除)

プロジェクト権限プロファイル

申請の状況確認

ポイント利用状況の確認

問い合わせ

1.2. ポータルで利用するアカウントについて¶

ポータルは以下のアカウントで利用することができます。

学認アカウント:全国の大学等とNIIが連携して構築する学術認証フェデレーション(https://www.gakunin.jp/)

mdxローカルアカウント:学認のアカウントが無い場合のmdx専用アカウント

1.3. ポータルの基本情報¶

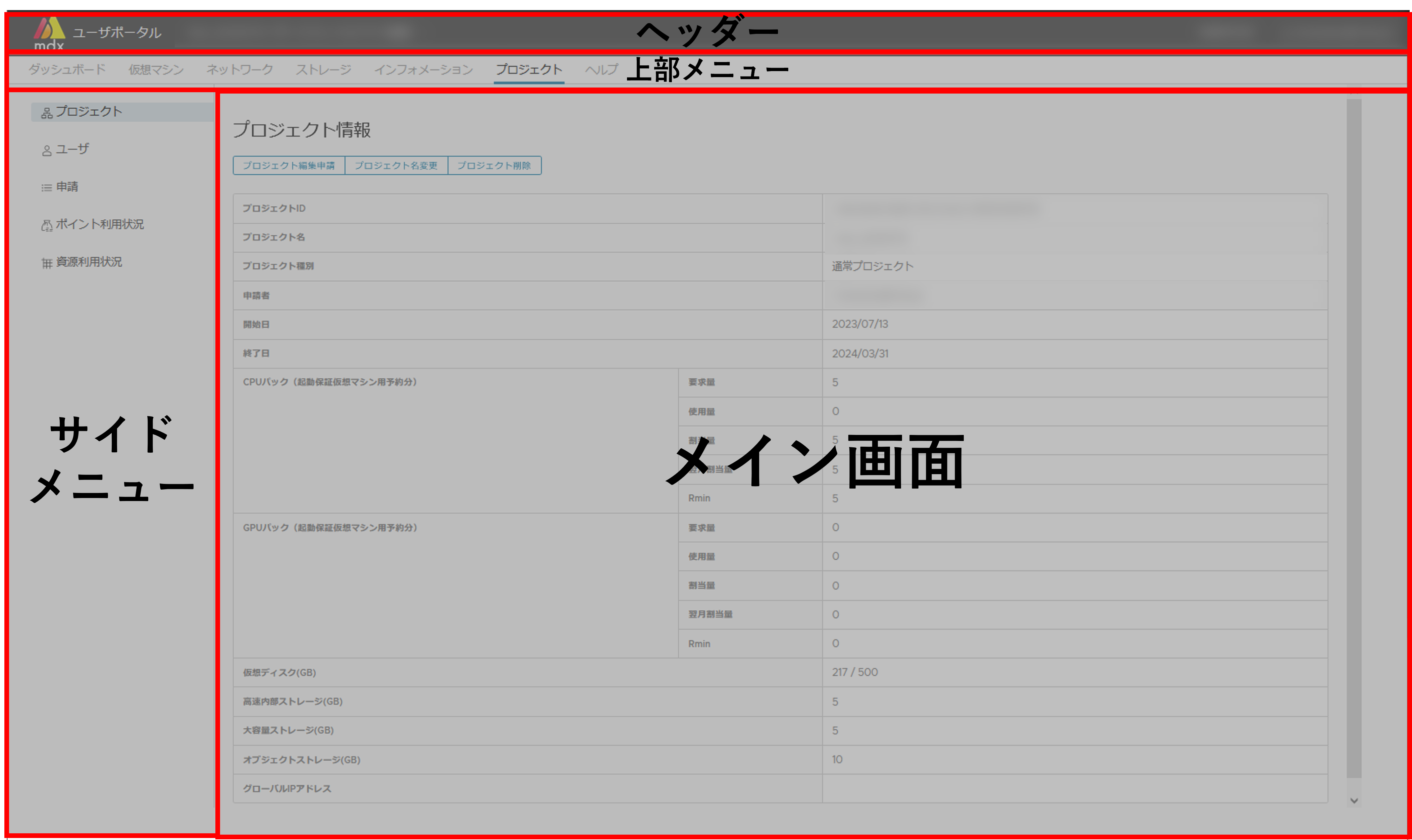

1.3.1. ユーザポータルの画面構成について¶

ユーザポータルは役割によっていくつかのパーツで画面が構成されており、 本ドキュメントではそれらのパーツを以下の図の呼称で定義します。

1.3.2. ポータルのタイムアウト時間¶

プロジェクト申請ポータル・ユーザポータル共に3時間以上無操作だった場合、ログインセッションを切断します。再度ログインしてください。

1.4. mdxにおける資源の単位について¶

1.4.1. データ単位¶

1.4.2. CPUパック・GPUパックについて¶

1CPUパックおよび1GPUパックで利用できる資源量は以下の通りです。

名称 |

仮想CPU数 |

仮想メモリ量 |

GPU数 |

|---|---|---|---|

CPUパック |

1 |

1548MB(約1.51GB) |

0 |

GPUパック |

18 |

約57.60GB |

1 |

1.5. mdxポイントの基本情報¶

1.5.1. mdxポイントについて¶

1.5.2. ポイントの消費について¶

起動保証仮想マシン用予約分の計算資源およびストレージ資源(定額制)

プロジェクトへの割り当て資源量に対して消費ポイントを算出する

- ポイントの消費タイミングで、資源種別ごとの単位時間内での割り当て資源量の最大値を用いて算出するなお、資源量の変動は プロジェクト編集 などにより発生する

- 例:24時に消費ポイントの算出がされるとして、仮想ディスクの割り当て資源量がその日の16時に100GBから200GBに変動した場合、24時時点での消費ポイントは200GBを割り当て資源量として算出する

起動保証/スポット仮想マシン起動分の計算資源(従量制)

起動している仮想マシンの使用資源量と起動時間に対して消費ポイントを算出する

起動時間が単位時間に満たない場合もその時間に応じてポイントが算出・消費される

プロジェクト例

割り当て量

CPUパック:10、GPUパック1、仮想ディスク:100G、高速:100G、大容量:100G

仮想マシン使用実績

仮想マシンA: 2CPUパック10時間

仮想マシンB: 1GPUパック5時間

一日の消費ポイント量合計:1510ポイント

注釈

資源に対する消費ポイントは年度毎に決められており、以下の計算は2023年度の値を元に計算

起動保証仮想マシン用予約分の計算資源およびストレージ資源:1256ポイント

CPUパック:10パック×0.2ポイント×24時間=48ポイント

GPUパック:1パック×50ポイント×24時間=1200ポイント

仮想ディスク:100G×0.03ポイント=3ポイント

高速ストレージ:100G×0.03ポイント=3ポイント

大容量ストレージ:100G×0.02ポイント=2ポイント

起動保証/スポット仮想マシン起動分の計算資源:254ポイント

CPUパック:2パック×0.2ポイント×10時間=4ポイント

GPUパック:1パック×50ポイント×5時間=250ポイント

2. 利用の流れ (quick start)¶

2.1. プロジェクトの申請をする¶

mdxの利用を開始するためには、利用する目的や利用期間、各担当者の情報を入力・申請(プロジェクト申請)する必要があります。

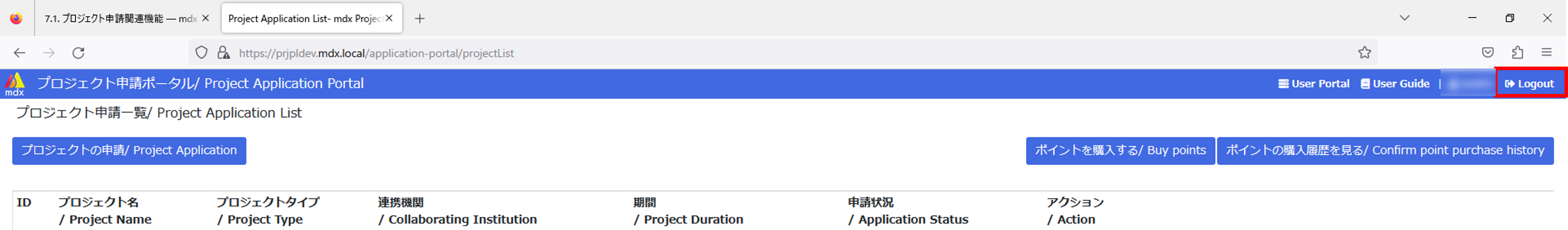

プロジェクト申請は プロジェクト申請ポータル にログインして実施します。

プロジェクト申請ポータルへのログイン方法は こちら をご確認ください。

[プロジェクトの申請/ Project Application]から必要事項を記入し申請してください。

申請した機関の機関管理者が承認するのを待ちます。

申請状態は、プロジェクト申請ポータルで確認することができます。

手順の詳細は、 こちら をご確認ください。

2.2. プロジェクト利用のためのポイント購入を申請する¶

mdxの資源を利用するために、 プロジェクト申請ポータル でポイントの購入申請を行います。購入申請はプロジェクトが承認後に利用可能となります。

[ポイントを購入する/ Buy Points]から資源を利用するプロジェクトの[購入する/ Purchase]を選択して、必要事項を記入し申請してください。

mdx管理者が承認するのを待ちます。

申請状態は、プロジェクト申請ポータルで確認することができます。

手順の詳細は、 こちら をご確認ください。

2.3. プロジェクトで利用する資源を申請する¶

2.4. 仮想マシンを作成・起動する¶

仮想マシンの操作はすべてユーザポータルで行います。

仮想マシンは、仮想マシンテンプレート、もしくはisoイメージから作成できます。仮想マシンテンプレートを利用することでシステム共通の設定を省略することができます。

仮想マシンテンプレートを使用した場合、リモートからアクセスするための公開鍵が必要になります。ご自身で準備してください。

仮想マシン作成後、作成した仮想マシンを起動します。

仮想マシンの状態等は、ユーザポータルで確認することができます。

手順の詳細は、 こちら をご確認ください。

2.5. ネットワークの設定をする¶

2.6. 仮想マシンを利用する¶

ご自身の端末から、設定したグローバルIPアドレスに、登録したキーペアの秘密鍵を使ってアクセスして、仮想マシンを利用します。

3. ポータルへのログイン方法について¶

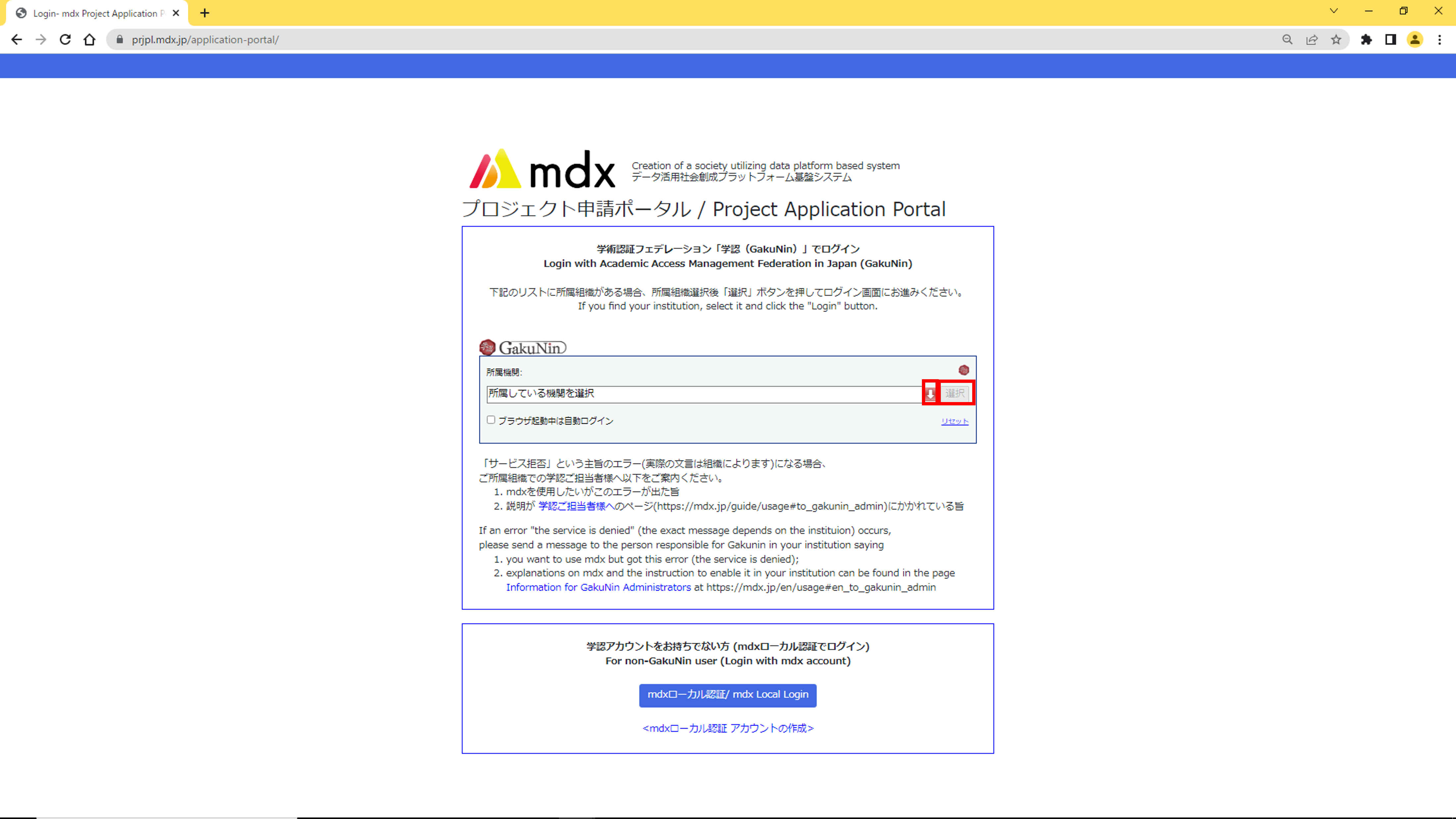

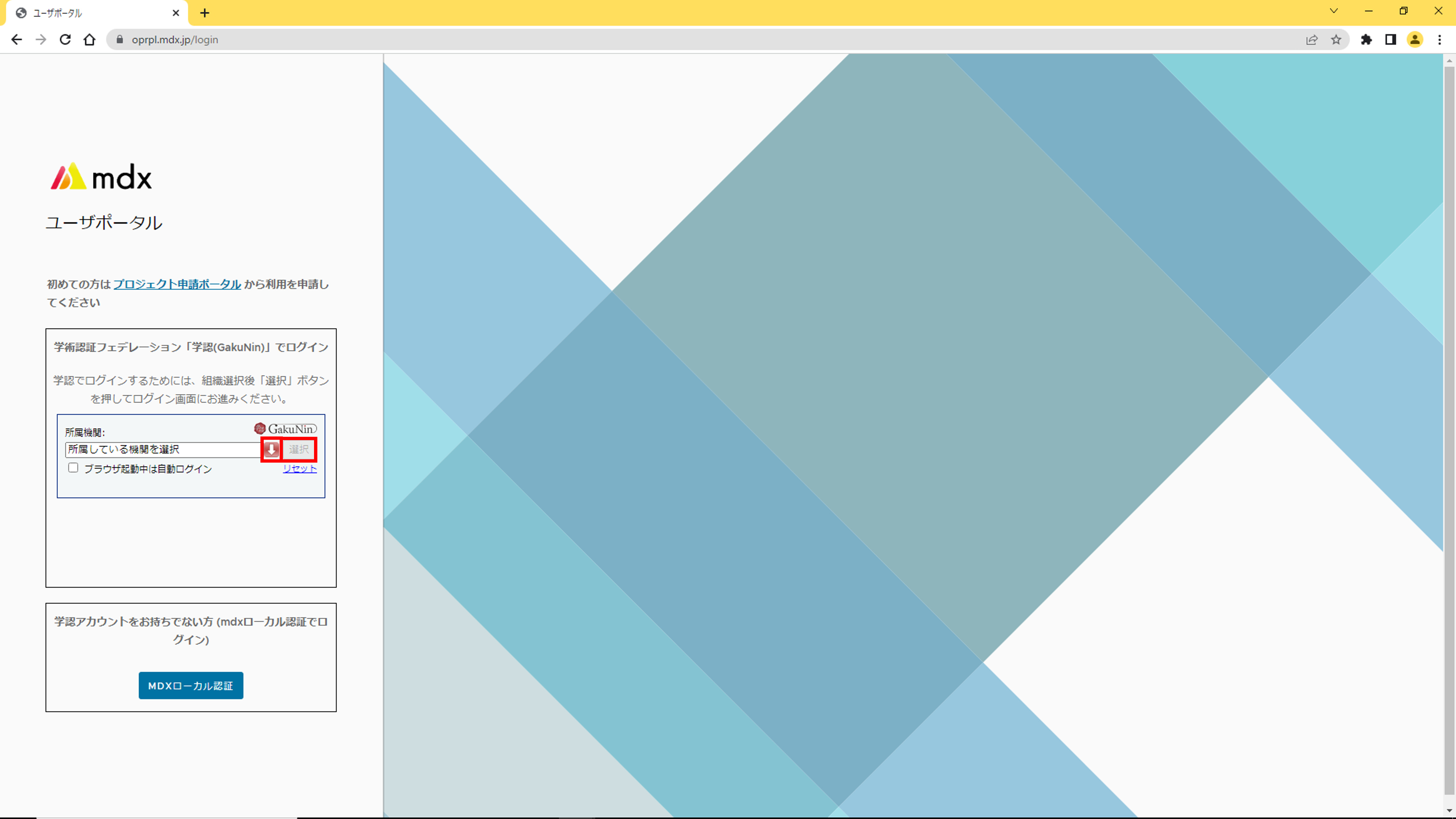

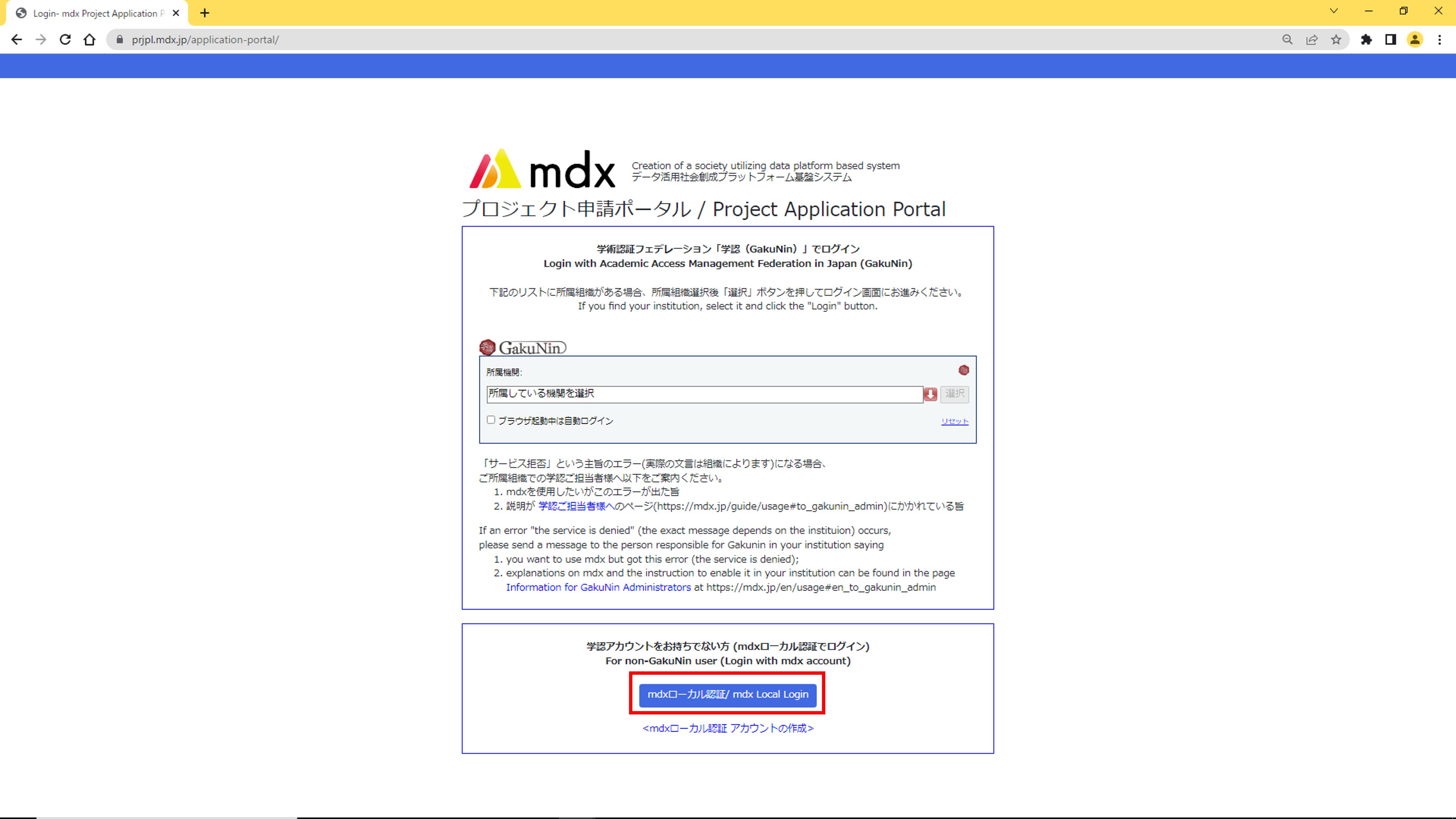

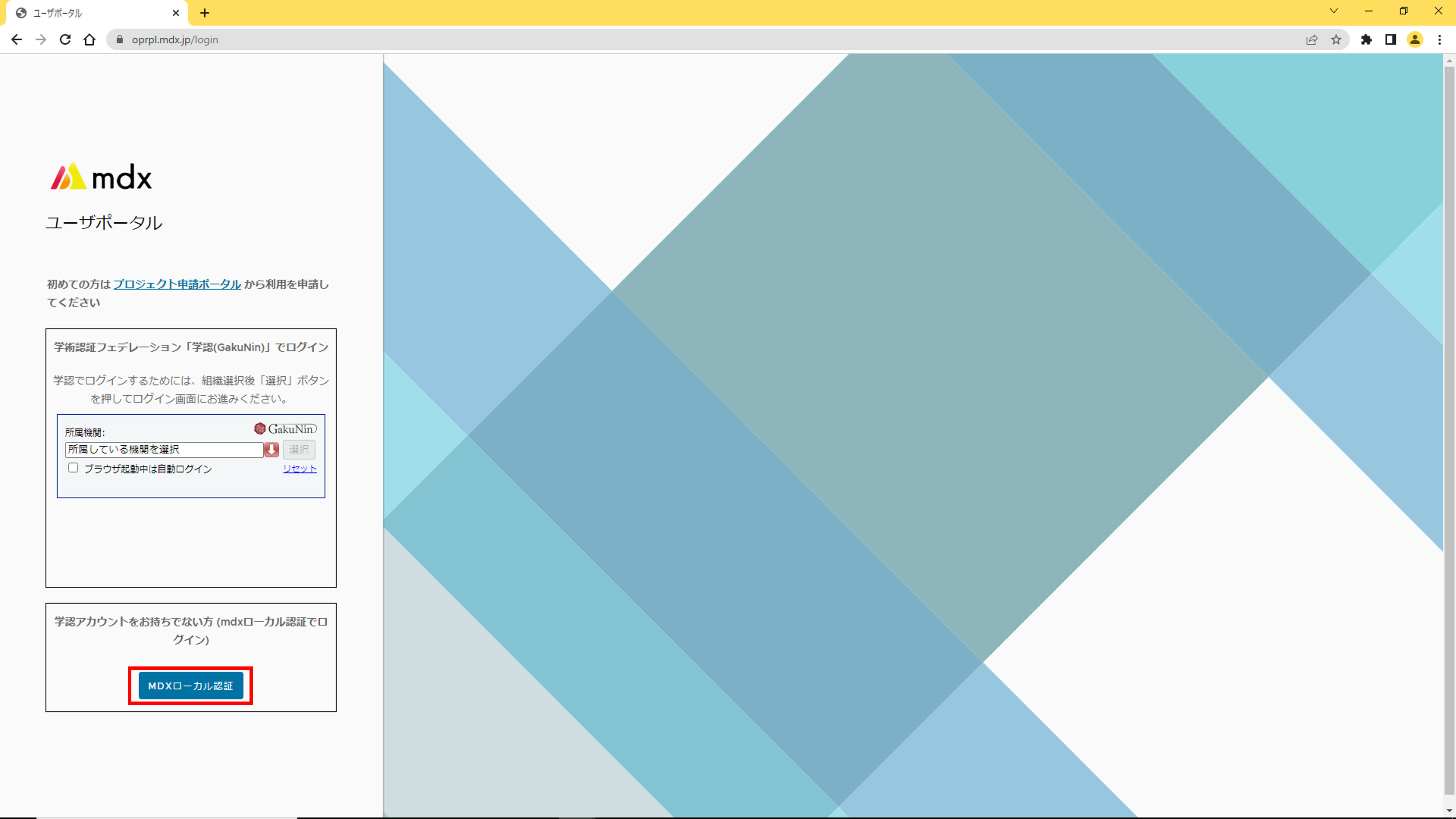

このページでは、各ポータルでの学認およびmdxローカルアカウントを利用したログイン方法について説明します。

3.1. 学認アカウントを利用したログイン方法¶

- 各ポータルログインページの[学術認証フェデレーション「学認(GakuNin)」でログイン]のメニューにあるプルダウン(下向き矢印のアイコン)から所属する機関を選択した状態で[選択]をクリックします。

所属する機関ごとに用意された所定の認証処理を実施します。

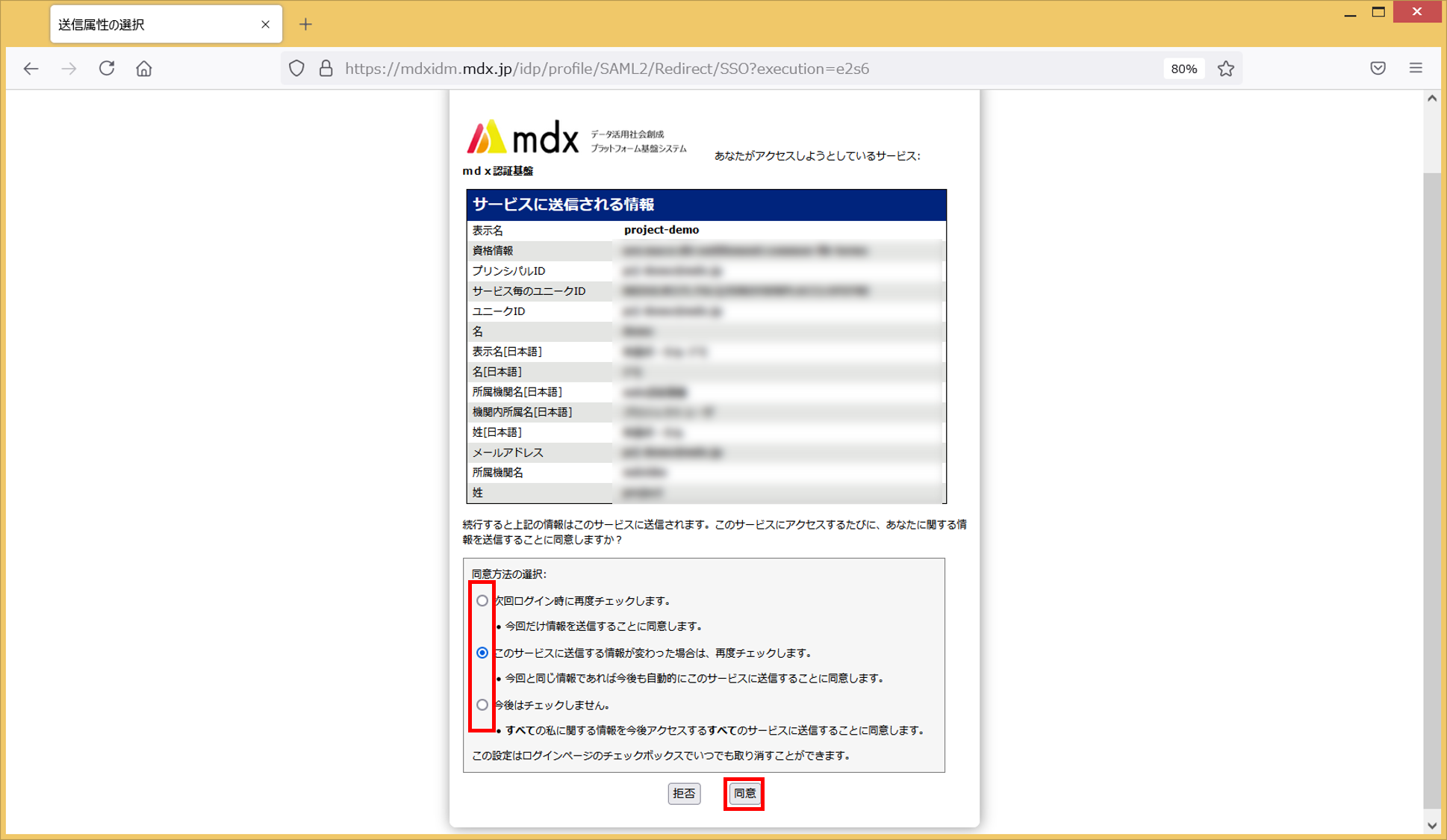

- 本サービスにユーザ情報を送信することを同意するか確認するための画面が表示されます。内容を確認のうえ同意方法を選択して[同意]をクリックします。

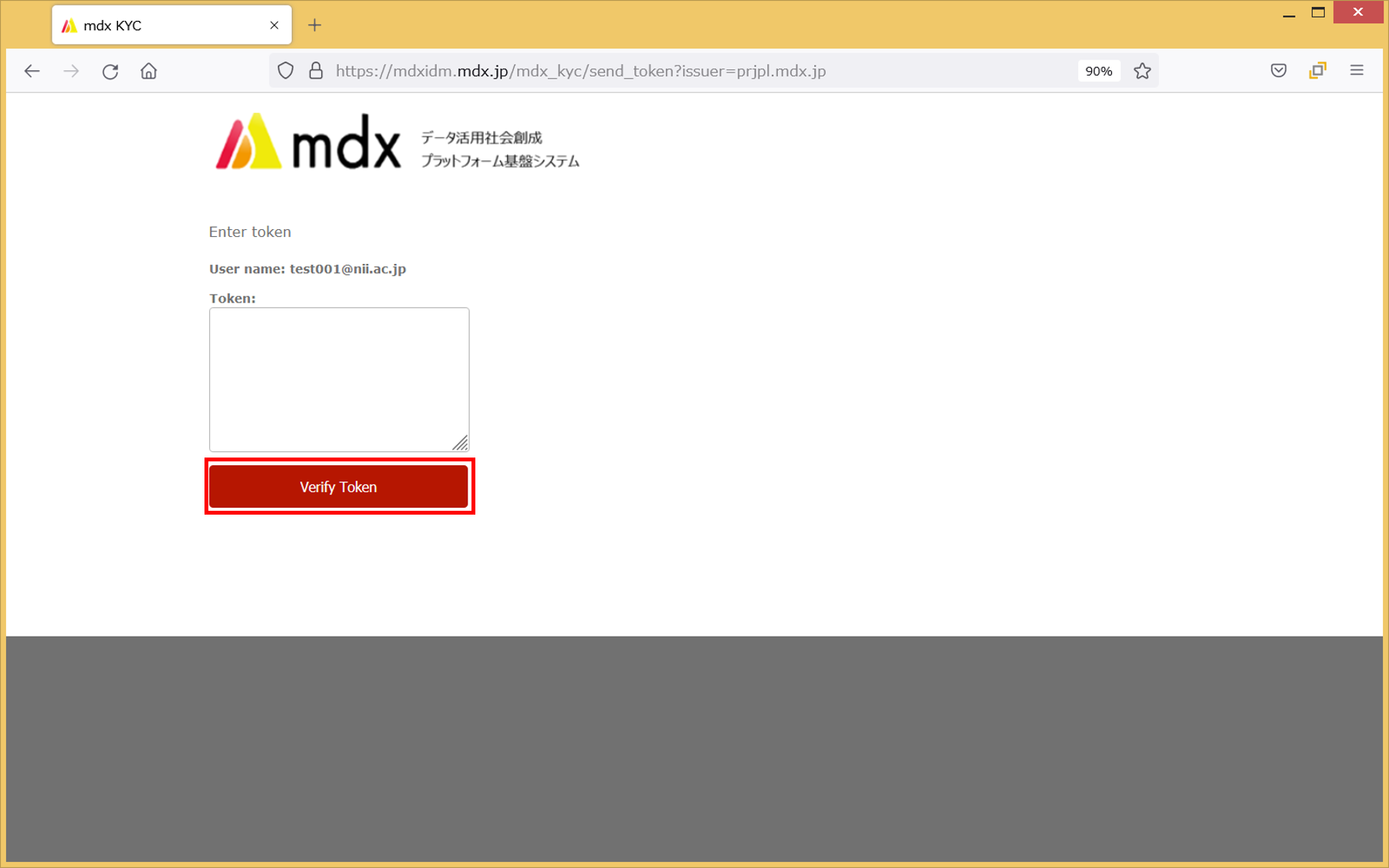

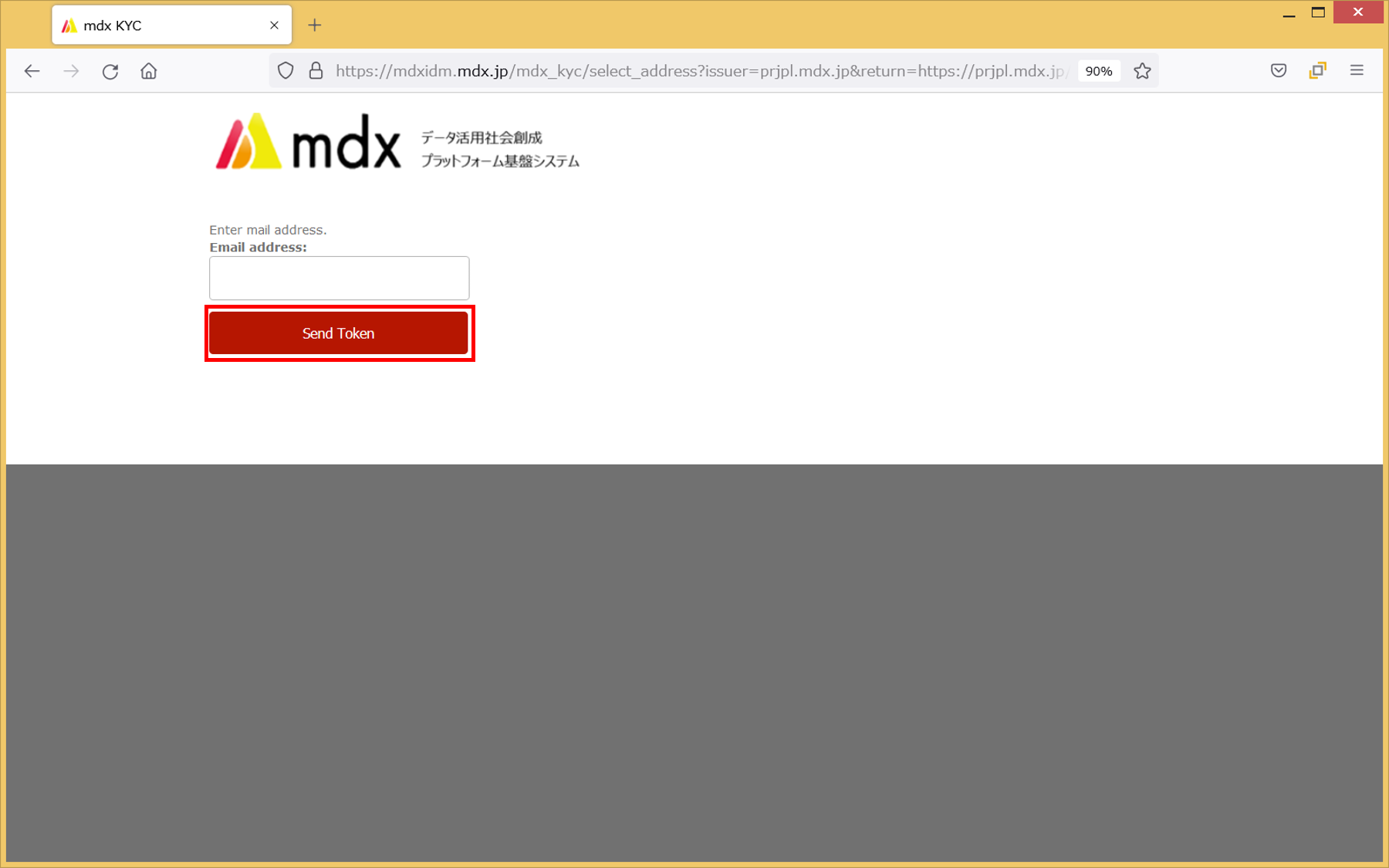

メールによる本人確認を行います。メールアドレスのドメインの末尾が「*.ac.jp」, 「*.go.jp」のいずれかであり、かつ自身が受け取り可能なメールアドレスを入力して[Send Token]をクリックします。

メールによる本人確認の結果は実施から30日間保持されます。30日間を過ぎますと、再度本人確認が必要となります。

所属機関によっては手順3のあとに本画面が表示されず、手順6のポータルTOP画面が表示される場合があります。その場合は手順4, 5をスキップしてください。

入力したメールアドレスに対して認証用メールが送信されますので以下のいずれかの対応を行います。

認証が完了し以下のポータルのTOP画面が表示されれば、ログイン完了となります。

3.2. mdxローカルアカウントを利用したログイン方法¶

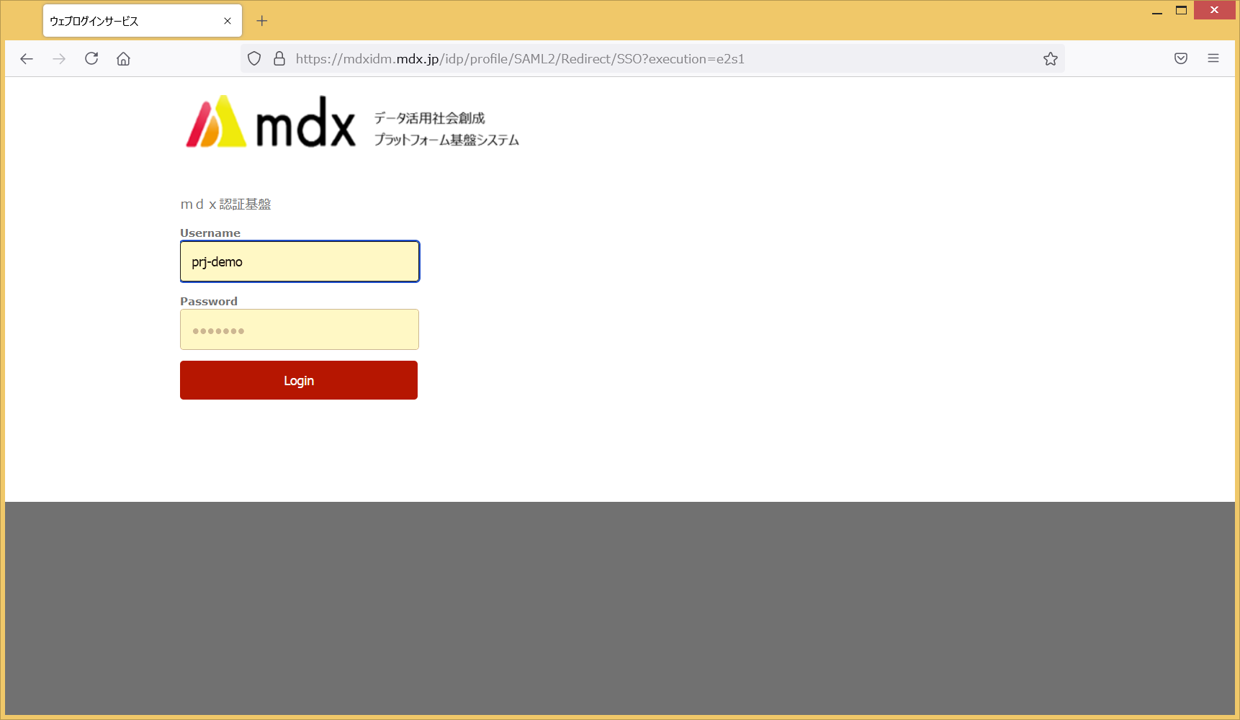

各ポータルログインページの[学認アカウントをお持ちでない方 (mdxローカル認証でログイン)]のメニューにあるmdx認証用ログインボタンをクリックします。

mdxローカルアカウントのユーザ名とパスワードを入力して、[Login]をクリックします。

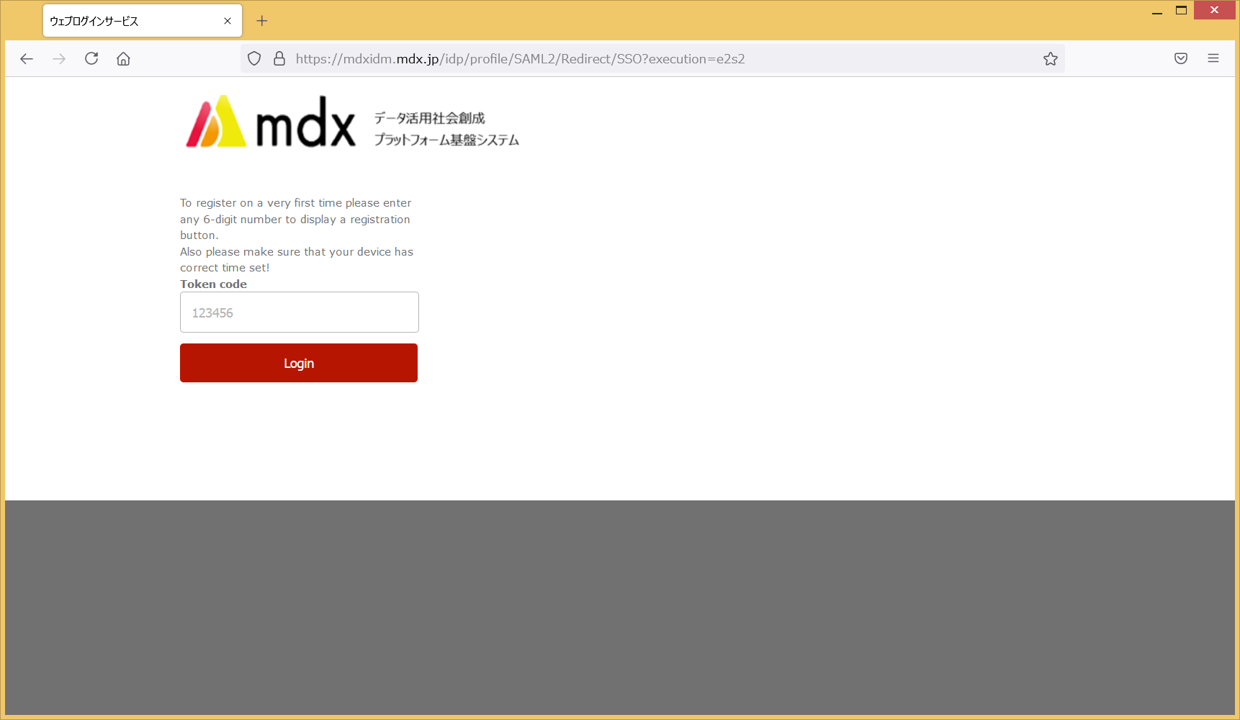

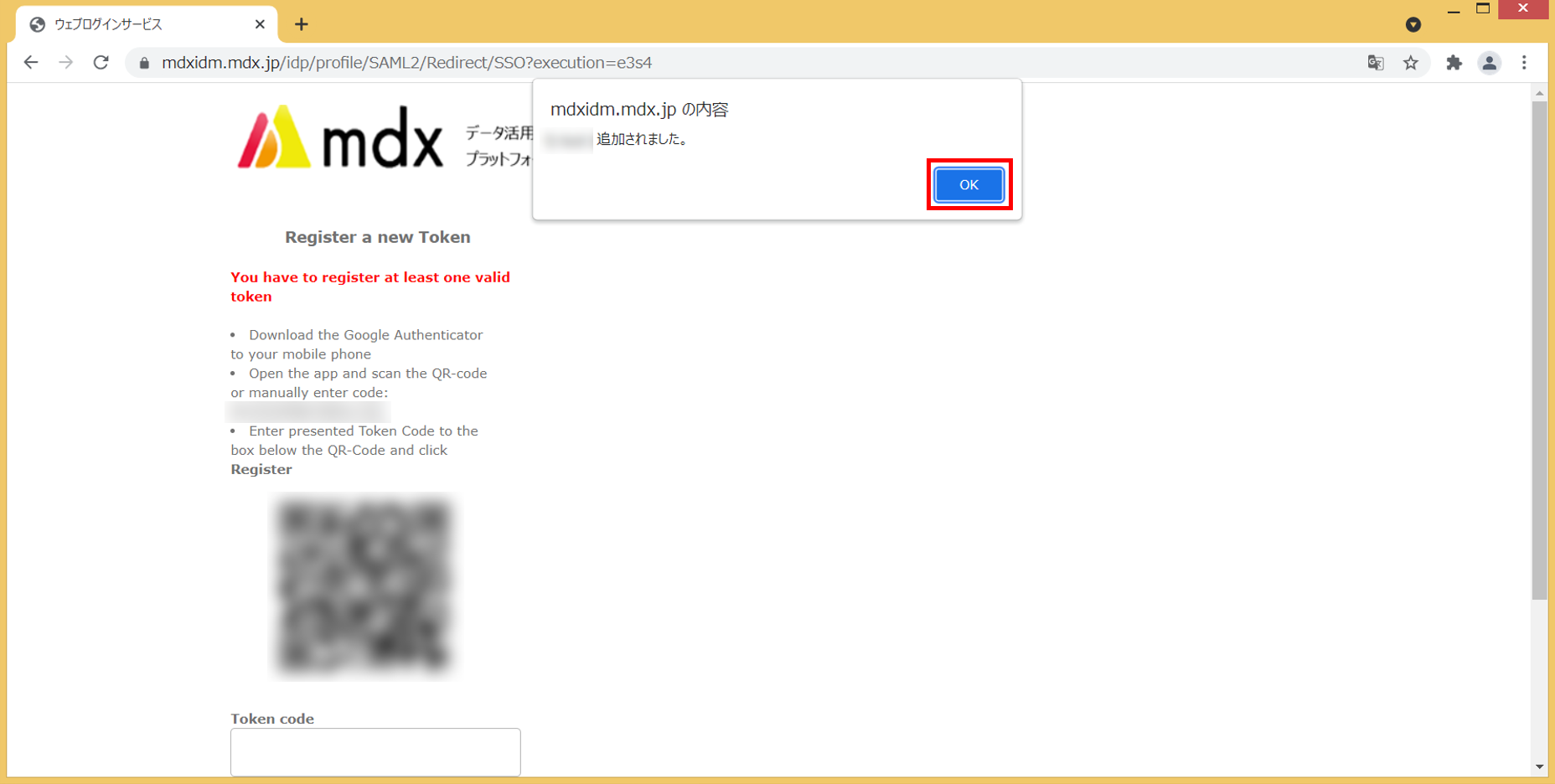

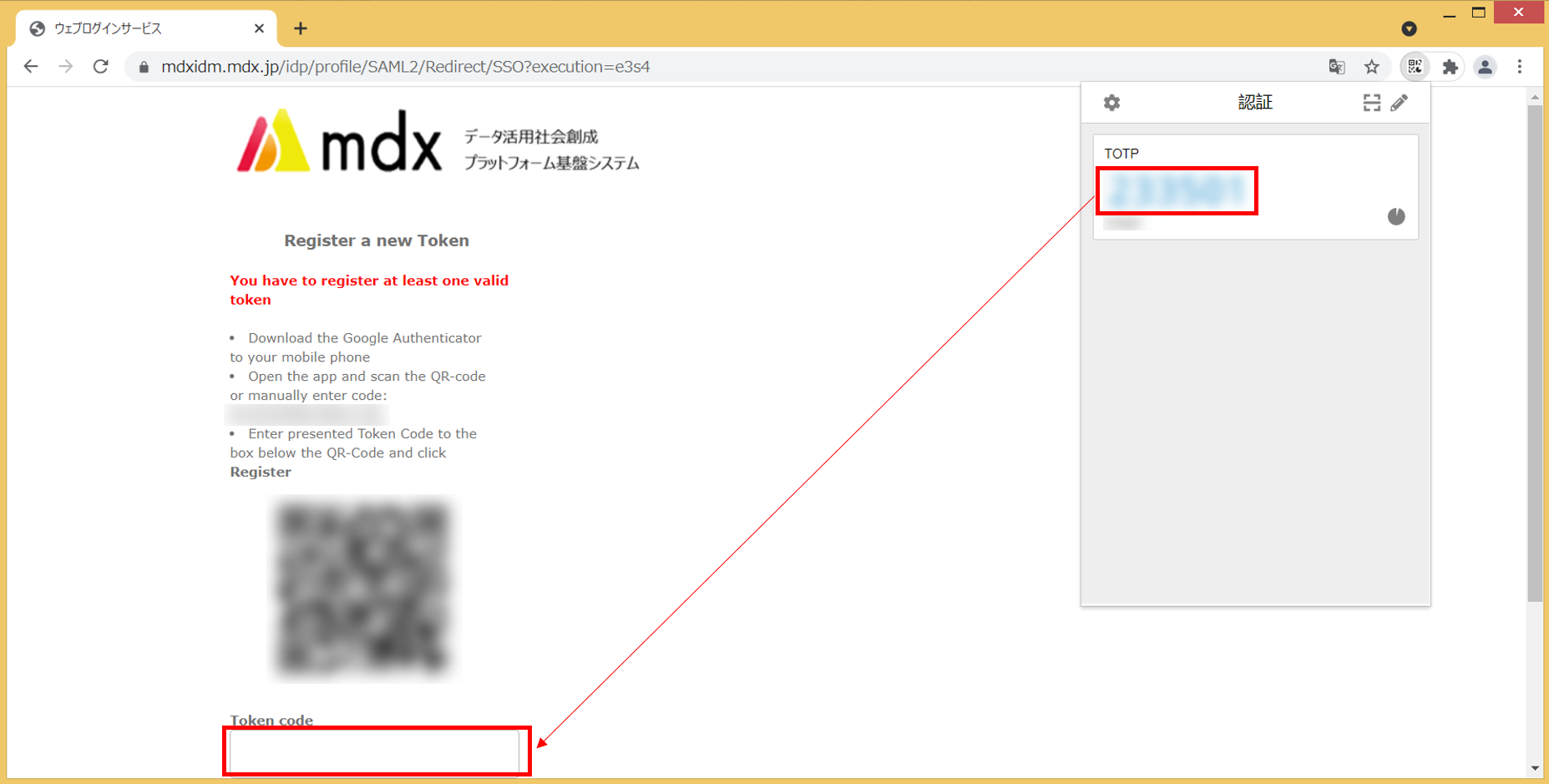

続いて二要素認証のサービスを利用して認証を行います。

初めて認証を行う場合には[Token code]欄に任意の6桁の数字を入力して[Login]をクリックし、次の手順に進みます。

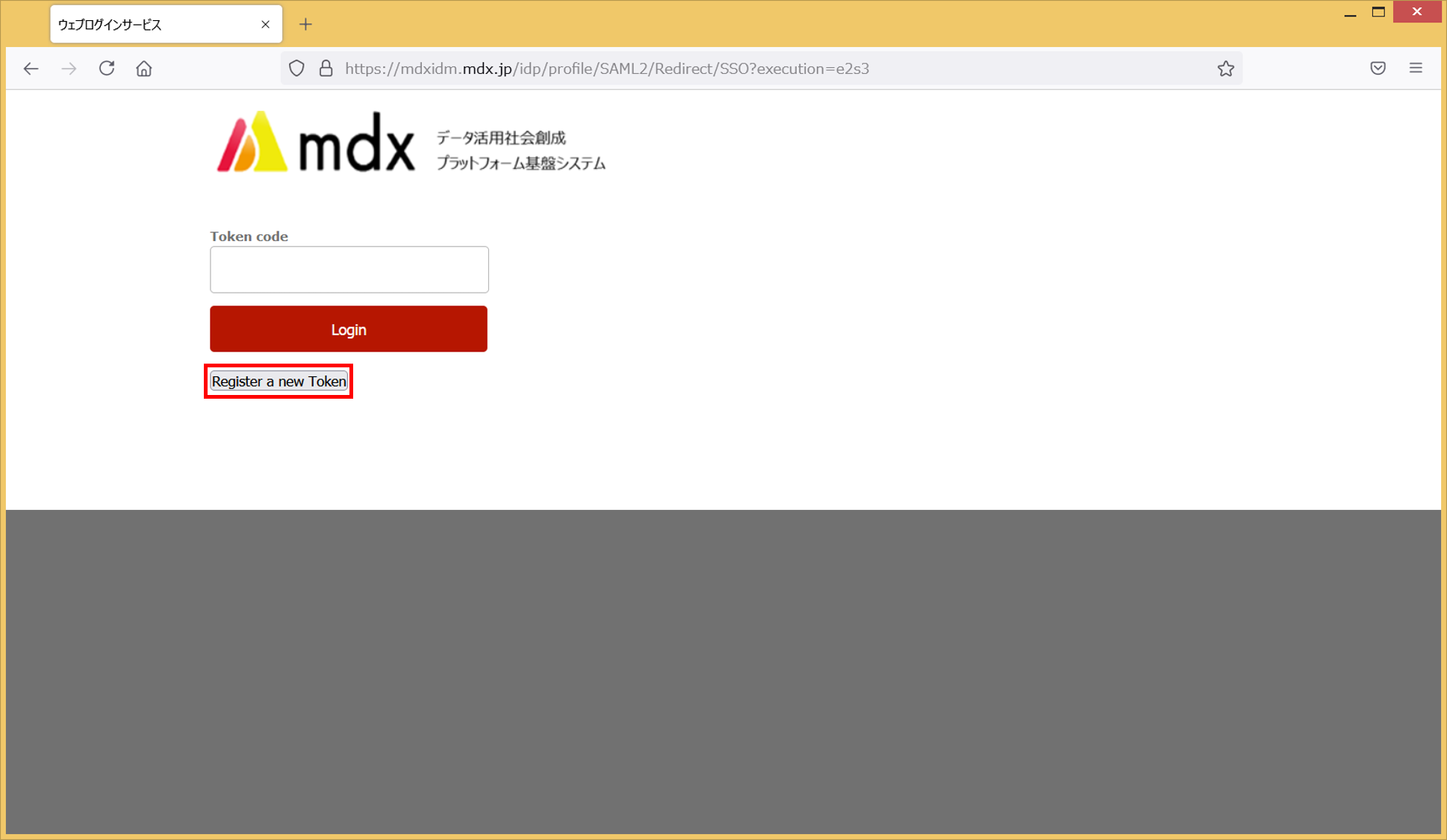

2回目以降の認証の場合には二要素認証のサービス上でmdxのアカウントに表示される6桁の数字を[Token code]欄に入力して[Login]をクリックして、手順8に進みます。

[Register a new Token]をクリックします。

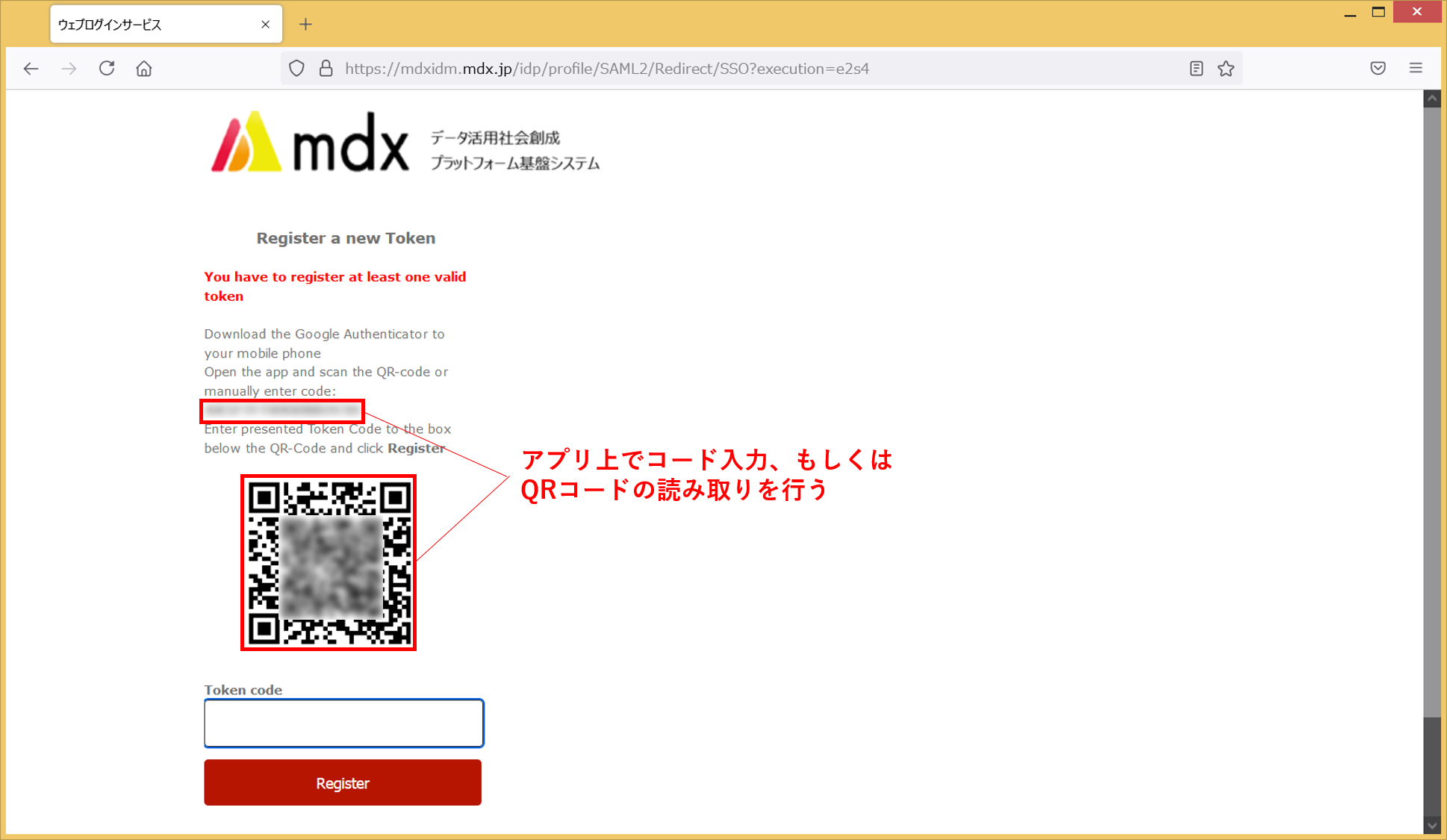

- 表示されたQRコードを二要素認証サービスから読み取るか、[manually enter code]部に表示される16桁のコードを二要素認証サービス上で入力します。二要素認証サービスにmdxのアカウントが登録され、それに紐づく6桁の数字が表示されるので、その数字を[Token code]に入力して[Register]をクリックします。

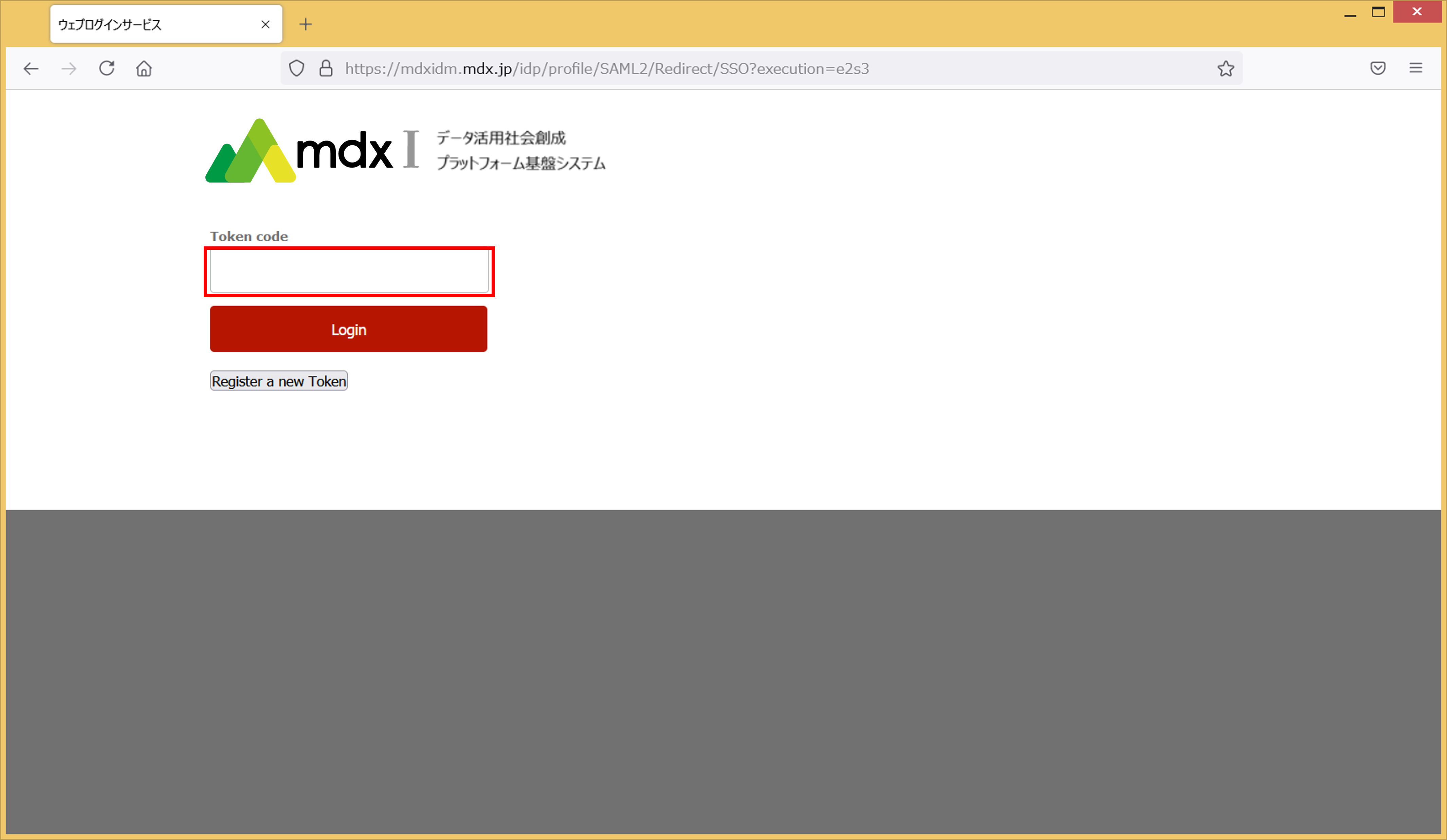

再度トークンを入力する画面が表示されますので、二要素認証サービスで生成された6桁の数字を[Token code]に入力して[Login]をクリックします。

mdxのサービスにユーザ情報を送信することを同意するか確認するための画面が表示されます。内容を確認のうえ同意方法を選択して[同意]をクリックします。

ポータルのTOPページが表示されれば認証は完了です。

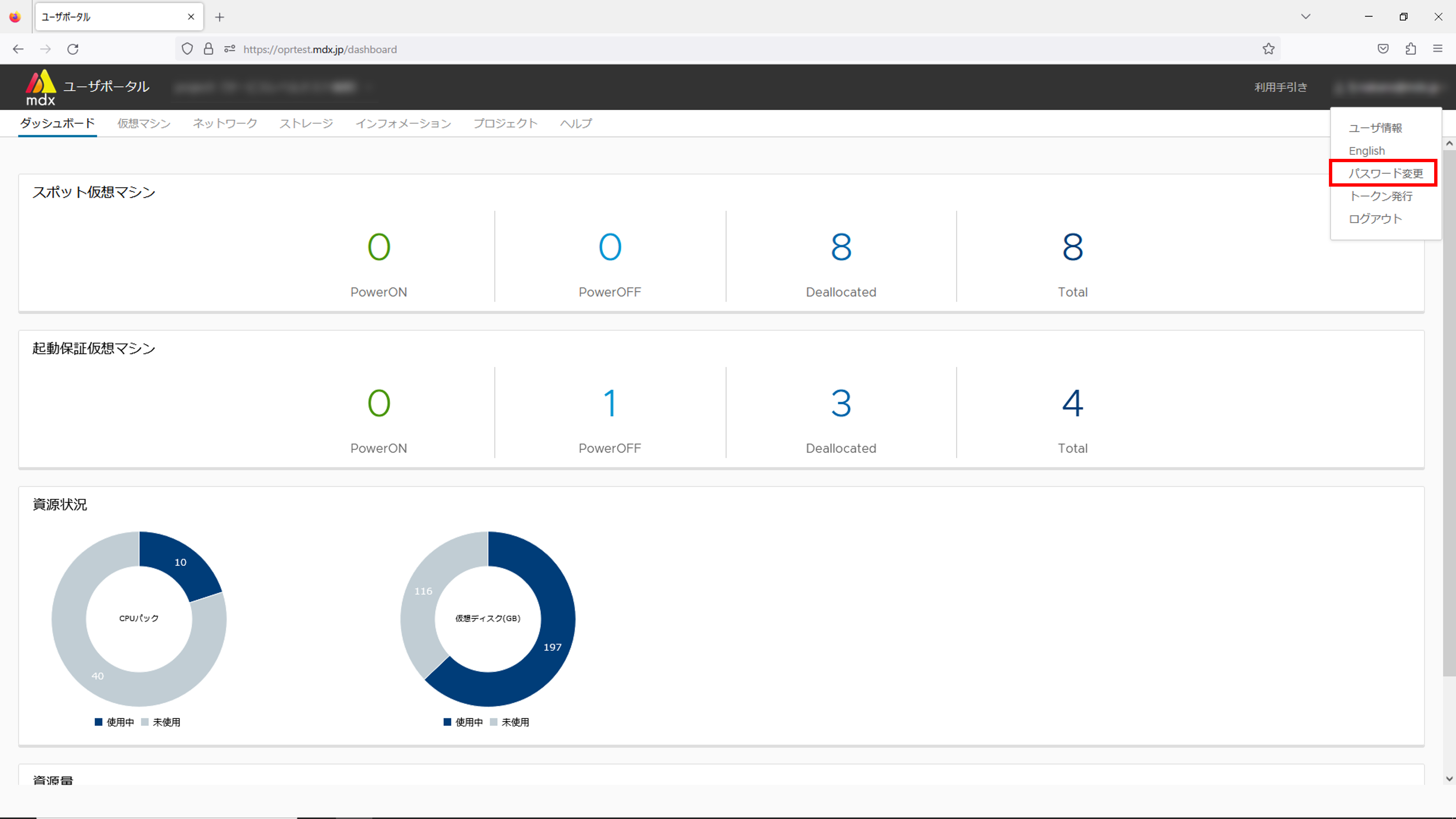

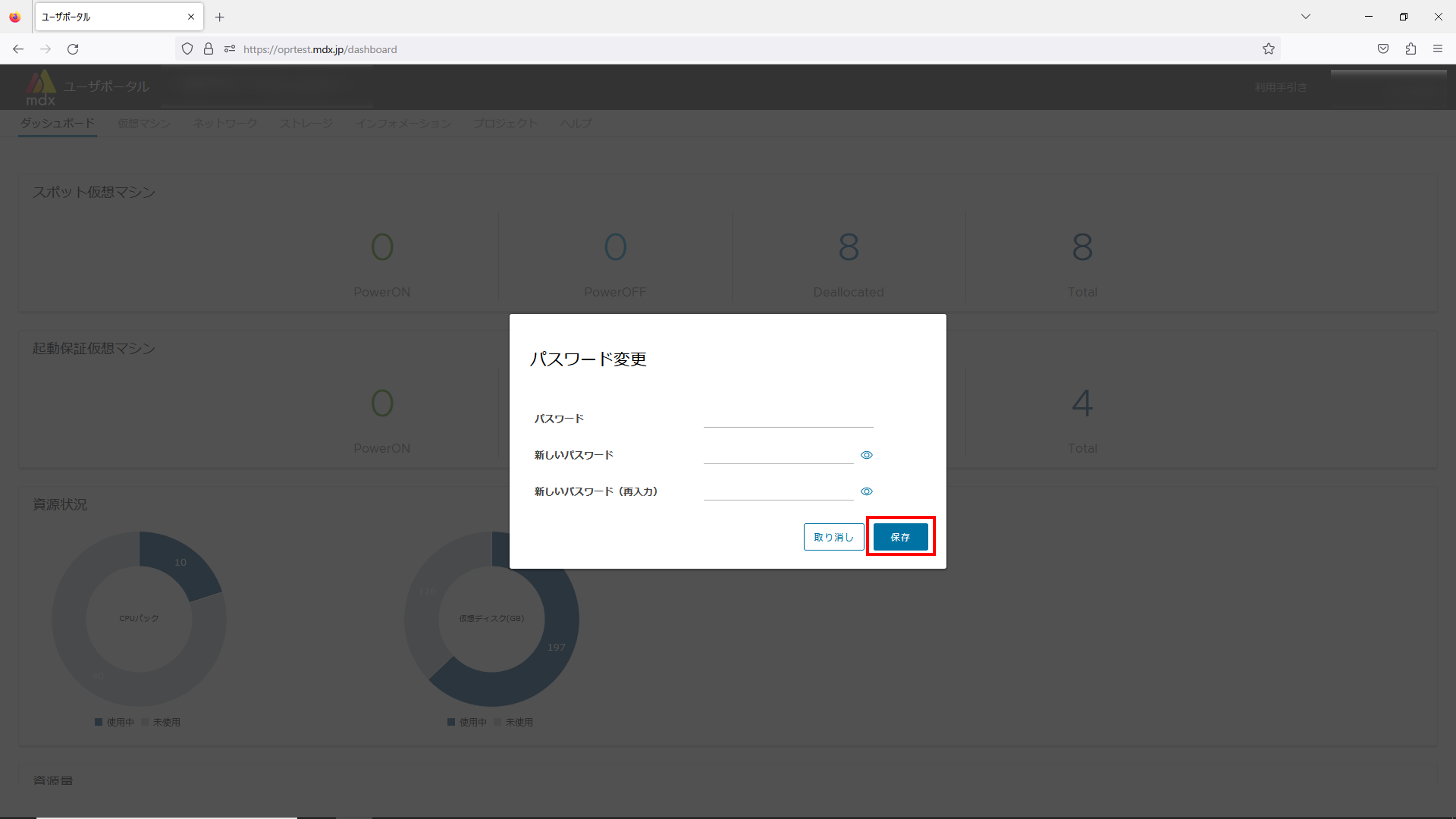

3.2.1. mdxローカルアカウントのパスワード変更方法¶

mdxローカルアカウントを利用している場合はユーザポータルからログイン時のパスワードを変更することができます。

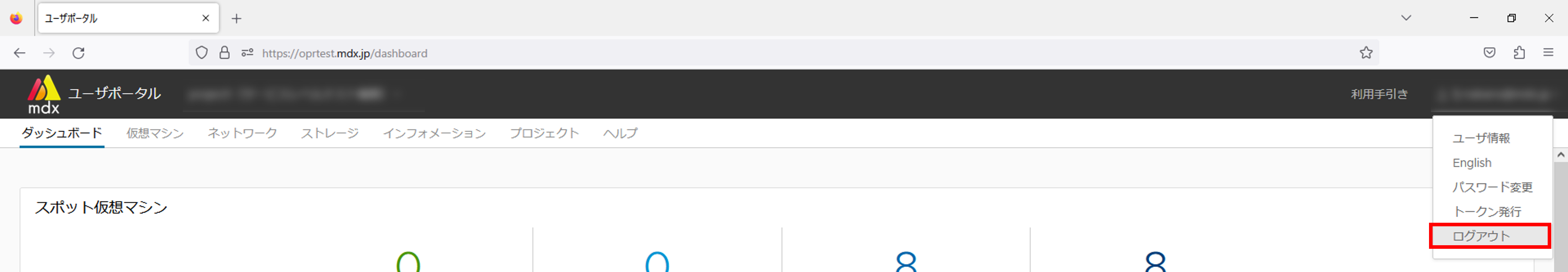

3.3. ポータルからのログアウト方法¶

各ポータルからログアウトする方法は以下の通りです。

3.4. 二要素認証について¶

3.4.1. スマートフォンの場合¶

3.4.2. PCの場合¶

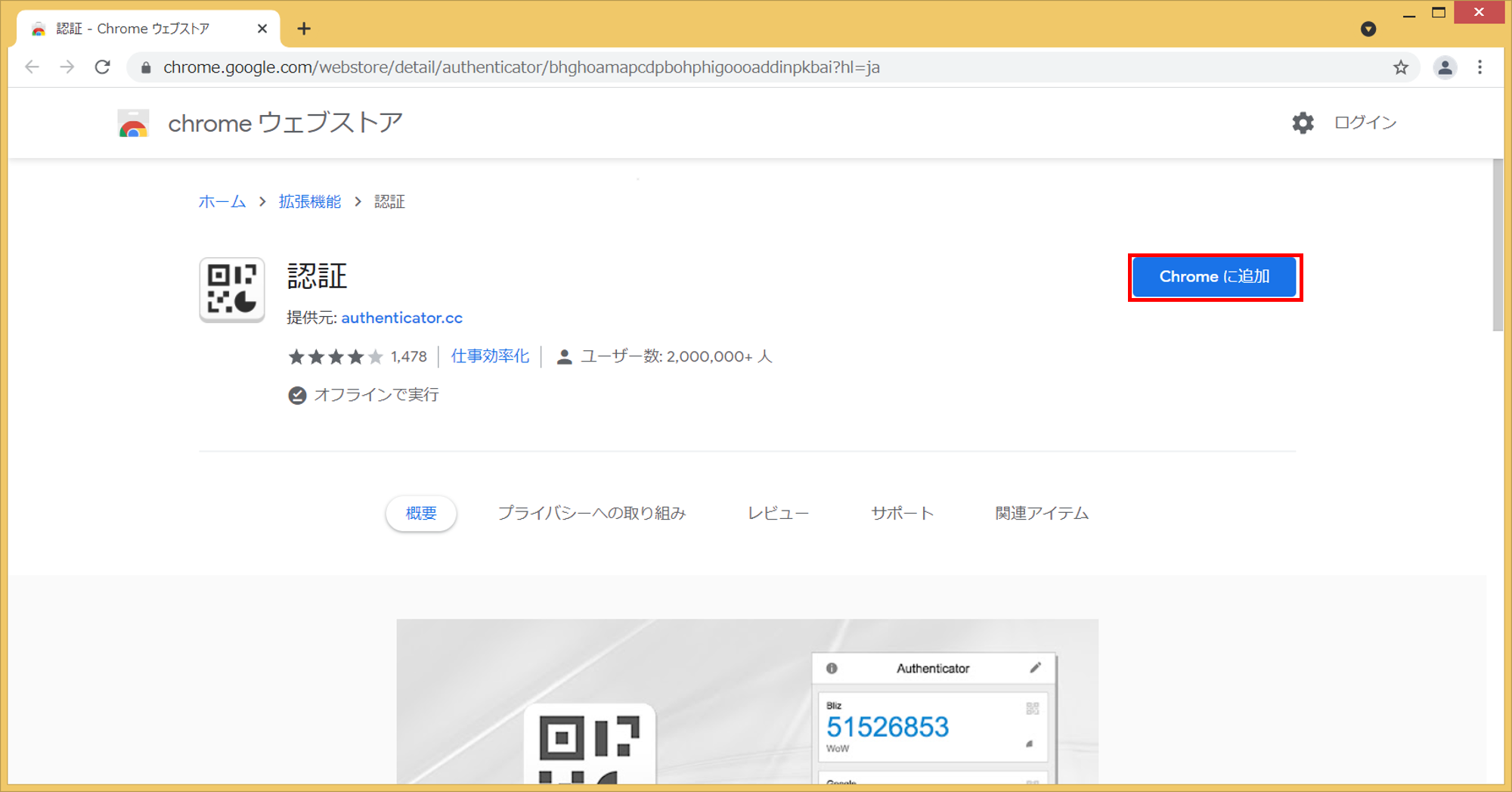

Google Chromeブラウザから こちら のURLにアクセスします。

[Chromeに追加]をクリックします。

ポップアップウインドウが出たら[拡張機能を追加]をクリックするとプラグインの追加は完了です。

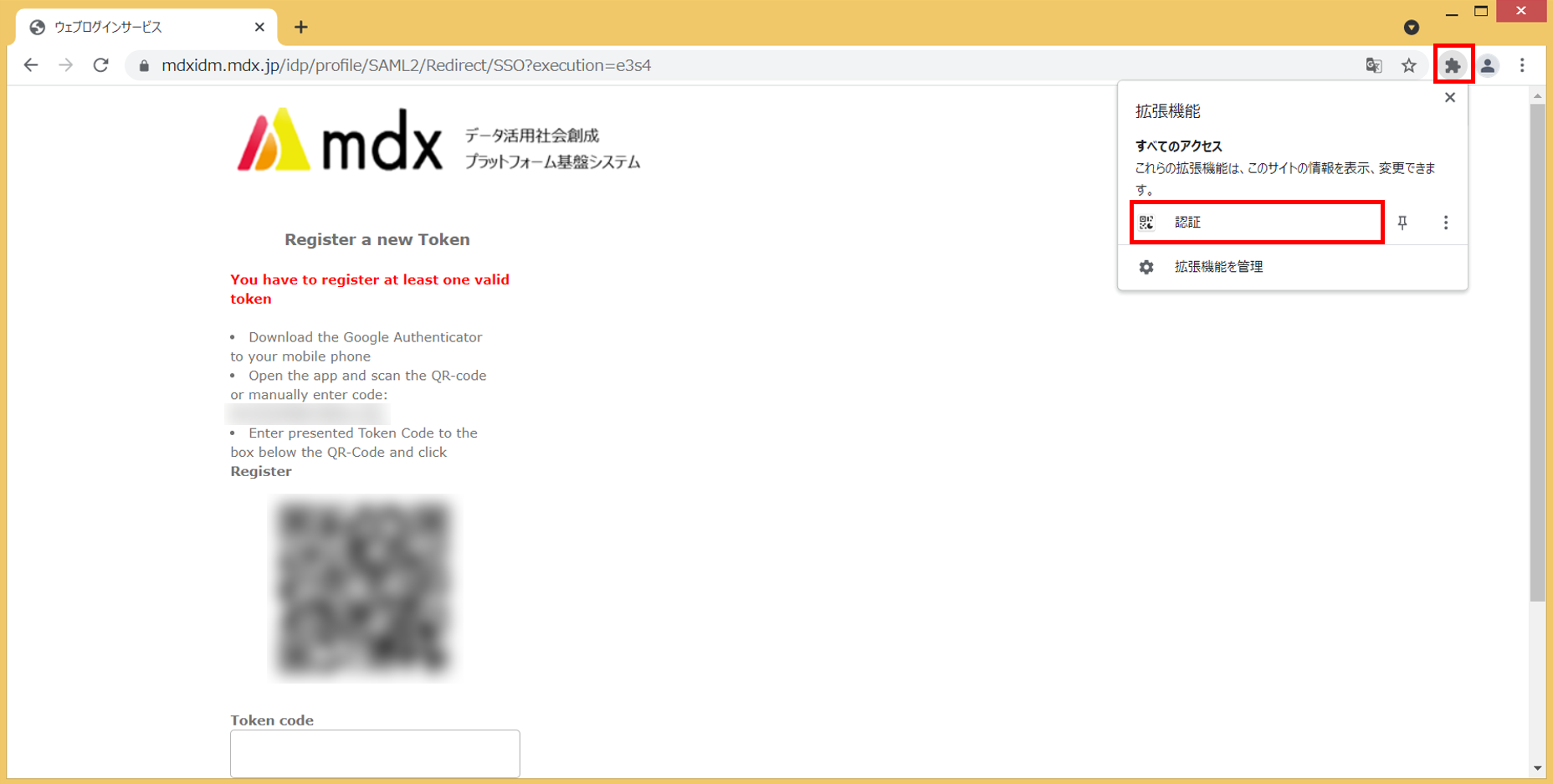

- 二要素認証を利用する場合は、二要素認証用のQRコードが表示されている画面でGoogle Chromeブラウザのメニューバーから拡張機能ボタン(パズルのピースのようなボタン)をクリックします。

表示されたプラグインから[認証]をクリックします。このとき利用許可を確認するポップアップが表示された場合は[許可]をクリックします。

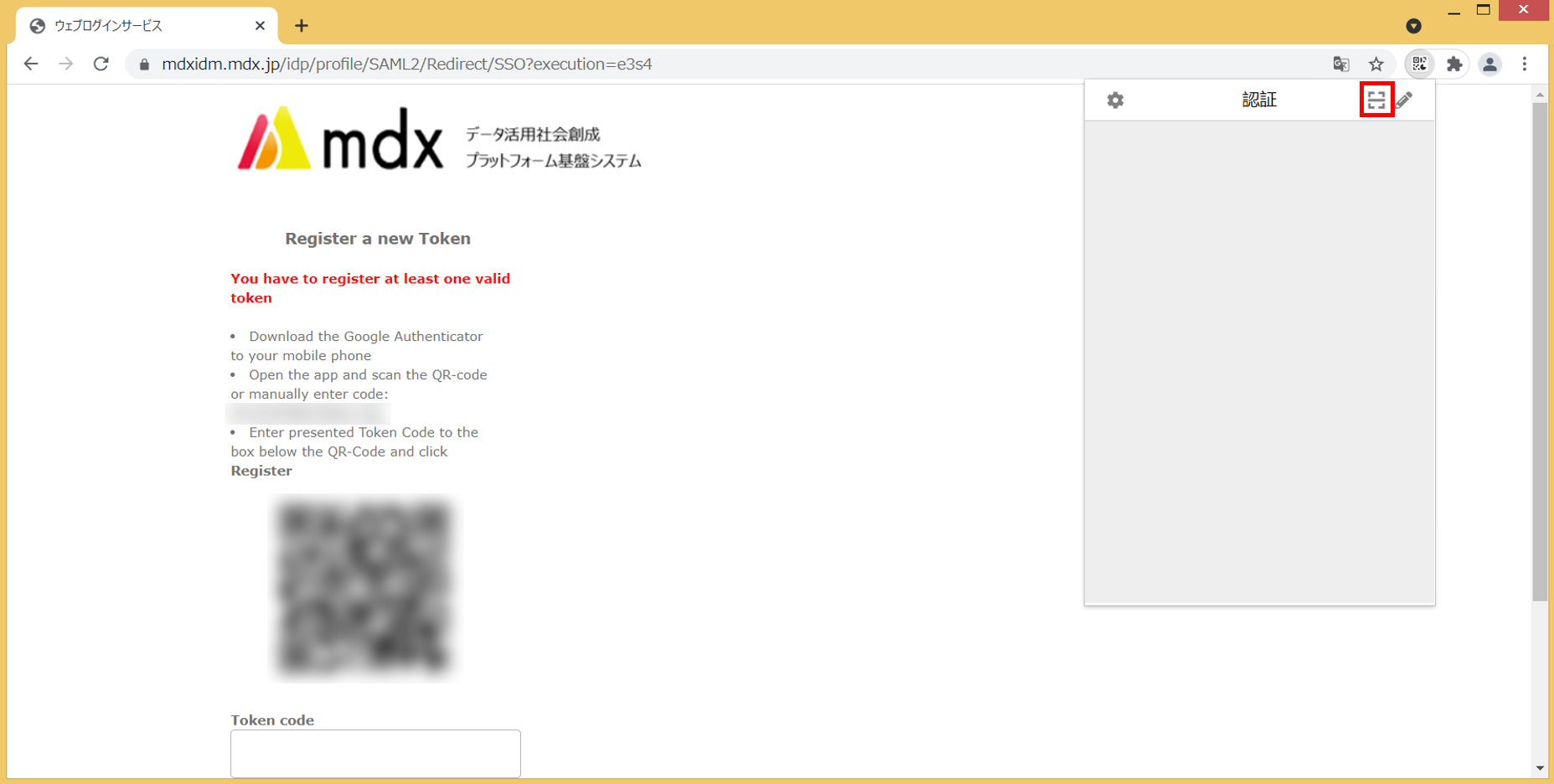

認証プラグインのウインドウが表示されますので、右上のスキャンボタンをクリックします。

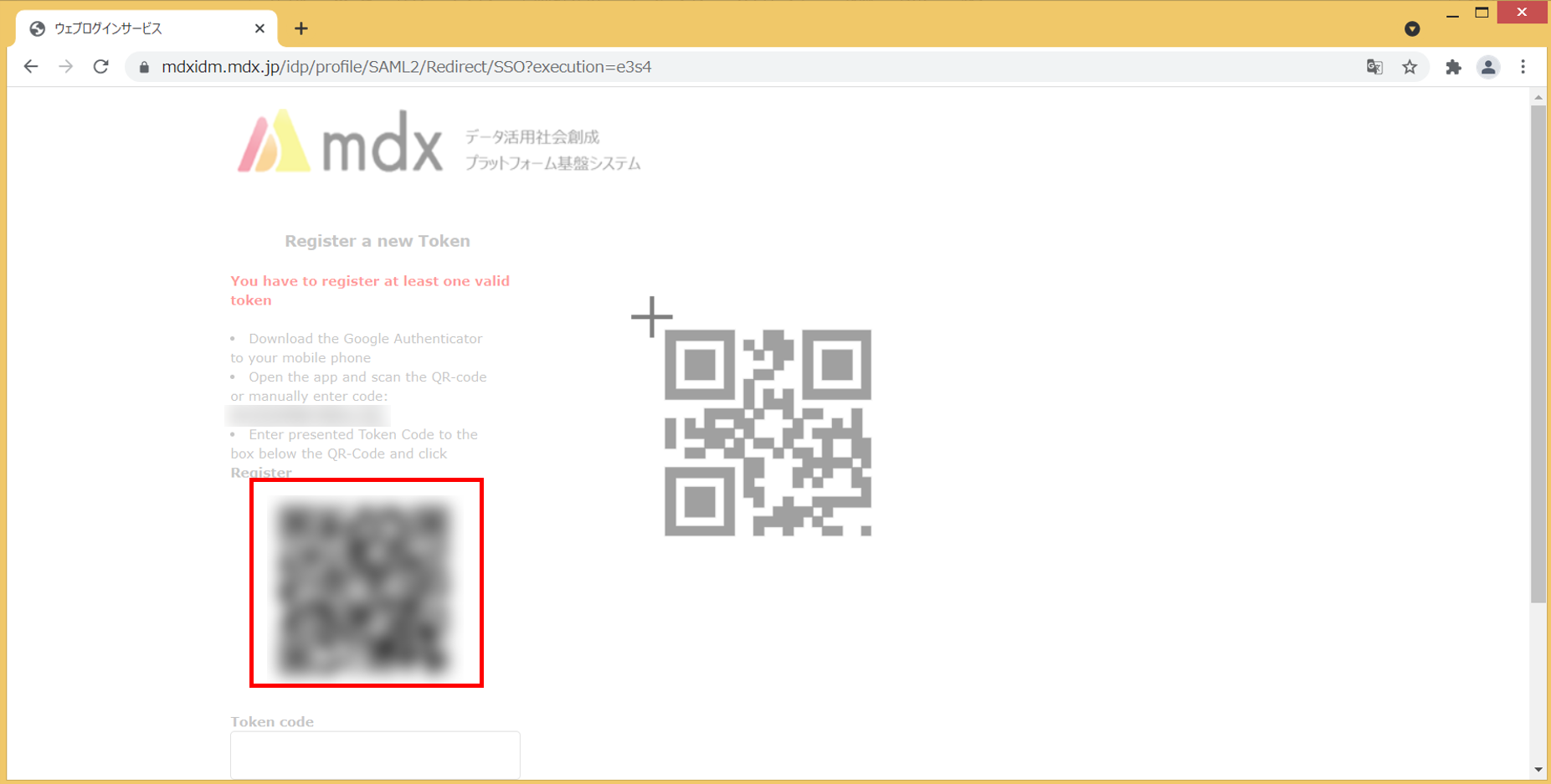

- 画面が白みがかってスキャン方法のチュートリアルが表示されます。表示内容にしたがって今回認証を行うページに表示されているQRコードをマウスカーソルでドラッグしながら囲みます。

QRコードが確認できたら画面上部にポップアップでアカウント追加されたことが通知されます。以上でアカウントの追加は完了です。

- 再度メニューバーのプラグインから認証のプラグインを起動すると、追加されたアカウント名とワンタイムパスワードが表示されます。表示されたワンタイムパスワードを認証を行うページの入力欄に入力すると認証処理を進めることができます。

4. プロジェクト申請の流れ¶

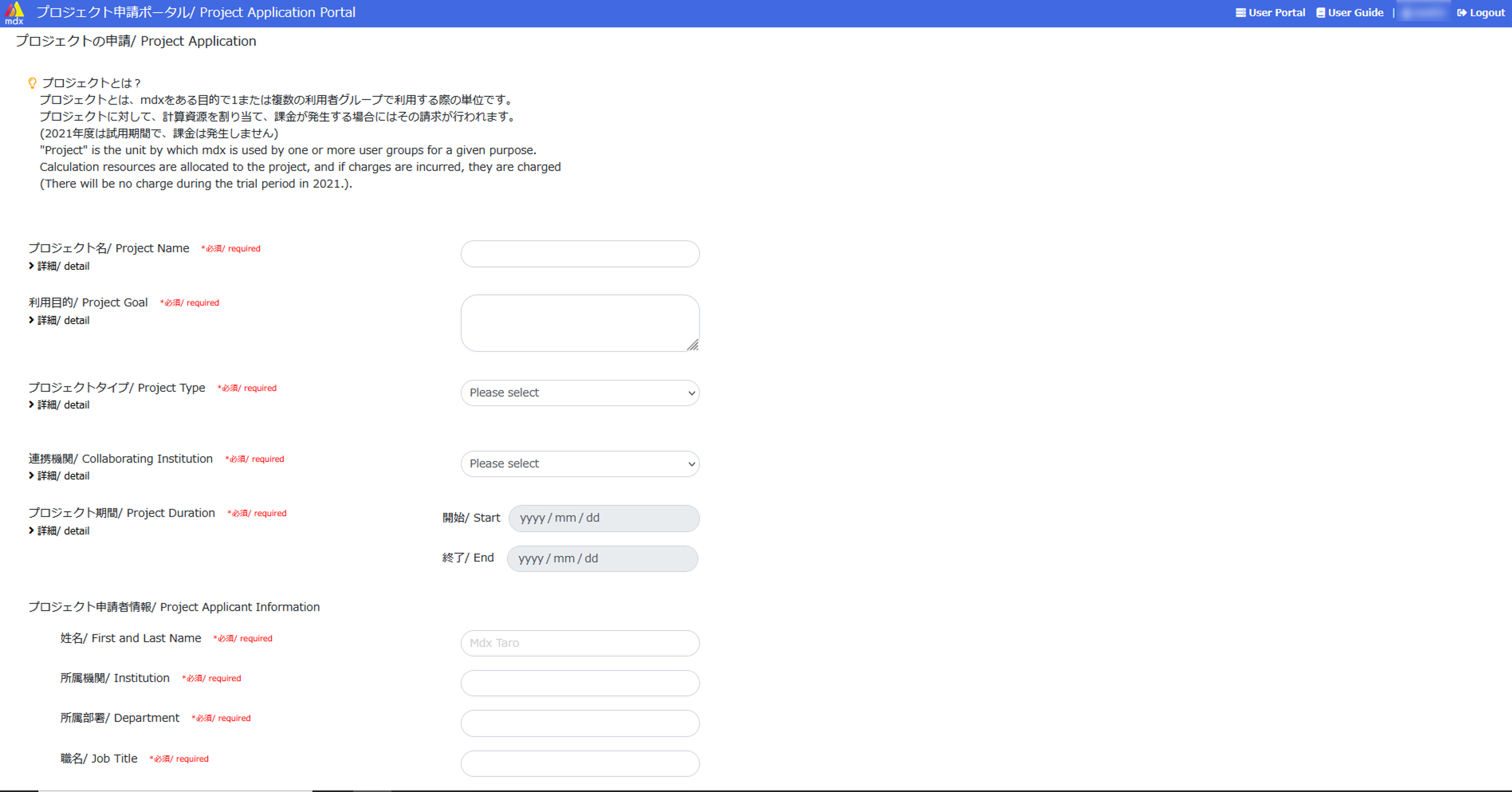

4.1. プロジェクトの申請を行う¶

プロジェクト申請ポータルにログインします。

画面左上にある[プロジェクトの申請/ Project Application]をクリックします。

プロジェクト申請に必要な項目を入力します。

[必須/ required]と記載のある項目は必ず入力してください。

[詳細/ detail]をクリックすると項目ごとの説明を参照できます。

入力項目の内容については プロジェクトの申請内容詳細 を参照してください。

入力が完了したら申請画面最下部の[申請/ Apply]をクリックします。

- もし入力内容に不備がある場合は申請ボタンの上にエラーメッセージが表示されます。また、不備がある項目名が赤色で表示されますので、修正のうえ再度[申請/ Apply]をクリックしてください。

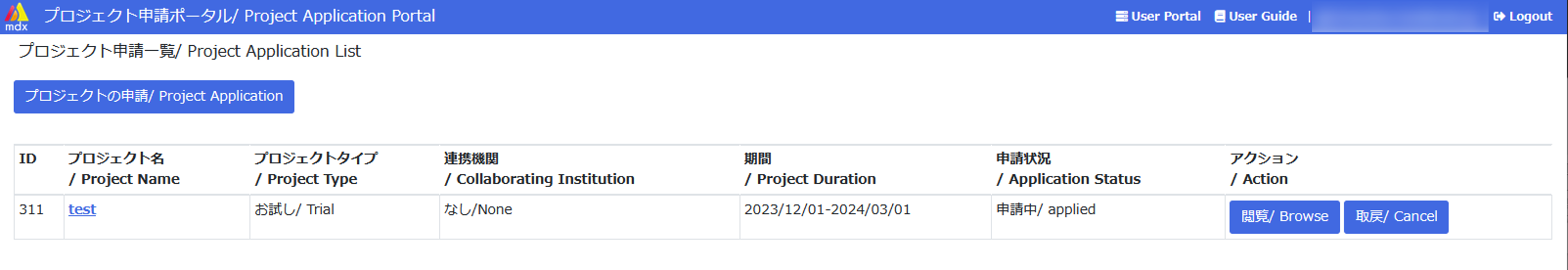

- プロジェクト申請一覧画面に戻ると、申請したプロジェクトのステータスが[申請中/ applied]で表示されます。以上でプロジェクト申請処理は完了です。

プロジェクトが承認されると、そのプロジェクトのユーザとしてユーザポータルへのログインが可能となります。 プロジェクトの申請は以下のような方法でも申請ができます。

4.2. プロジェクトにユーザを追加する¶

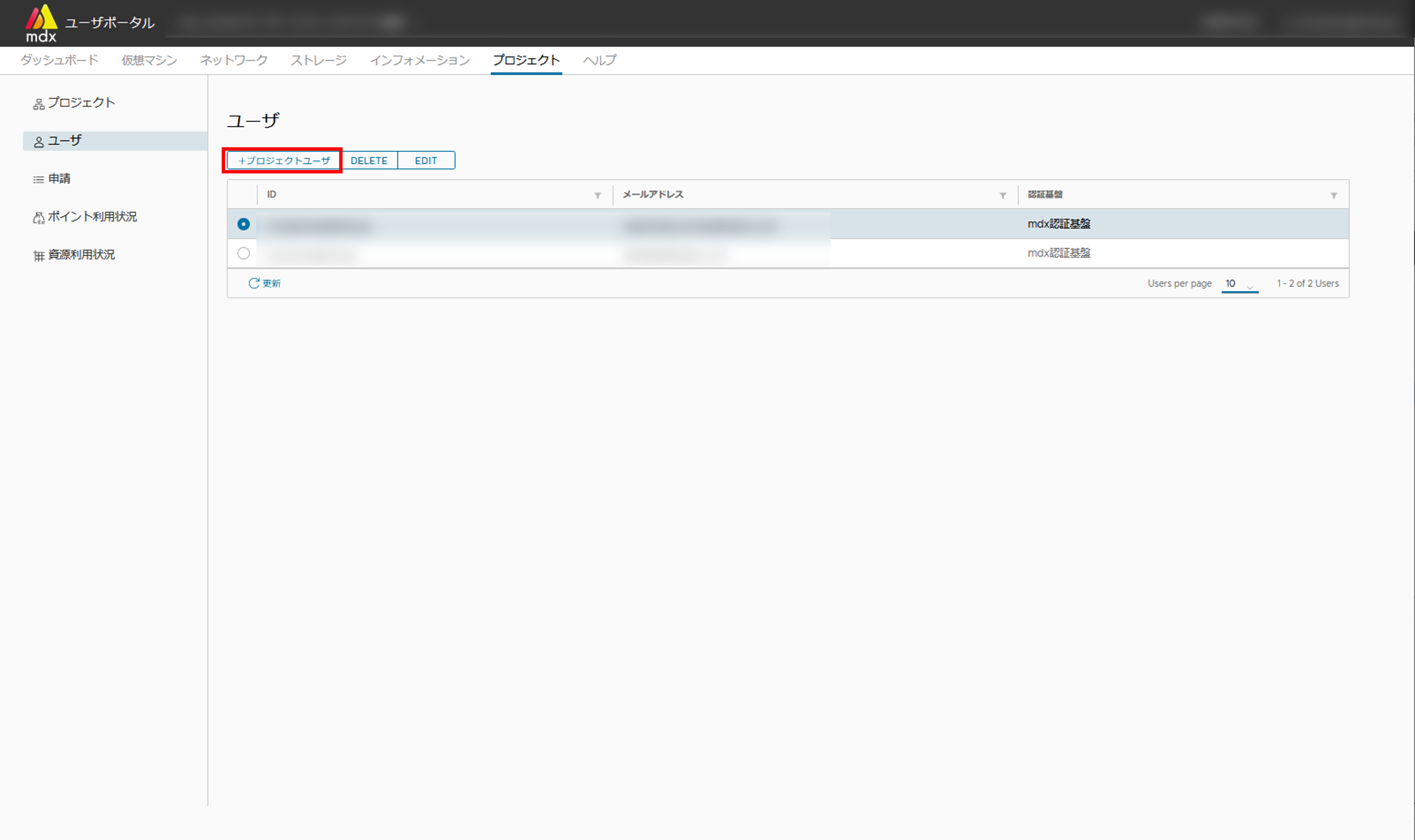

承認後のプロジェクトに共同でプロジェクトを運営するユーザを追加します。作業はユーザポータル上で行います。

ユーザポータルにログインします。

上部メニューから[プロジェクト]をクリックします。

サイドメニューから[ユーザ]をクリックします。

メイン画面リスト上部の[+プロジェクトユーザ]をクリックします。

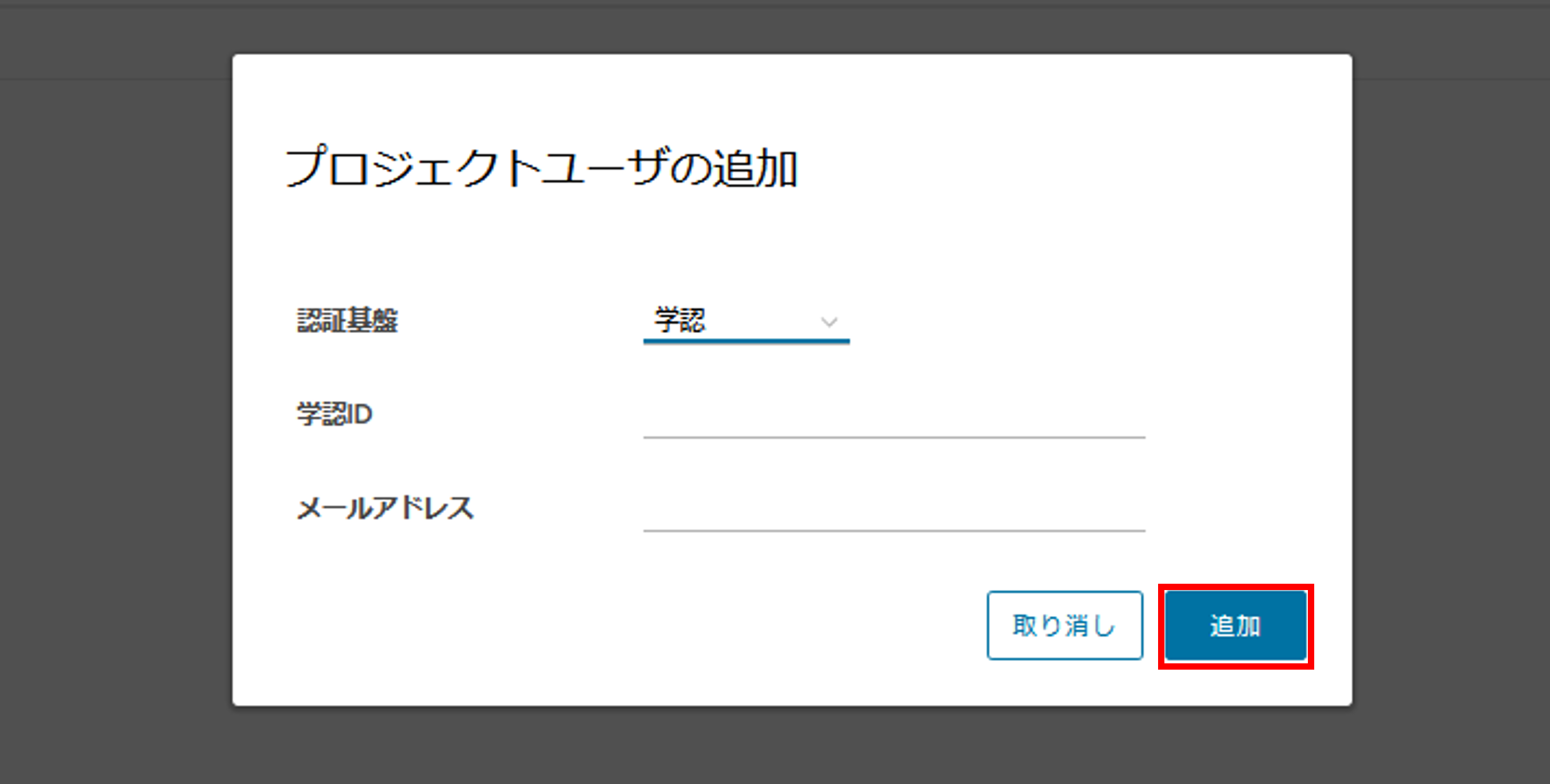

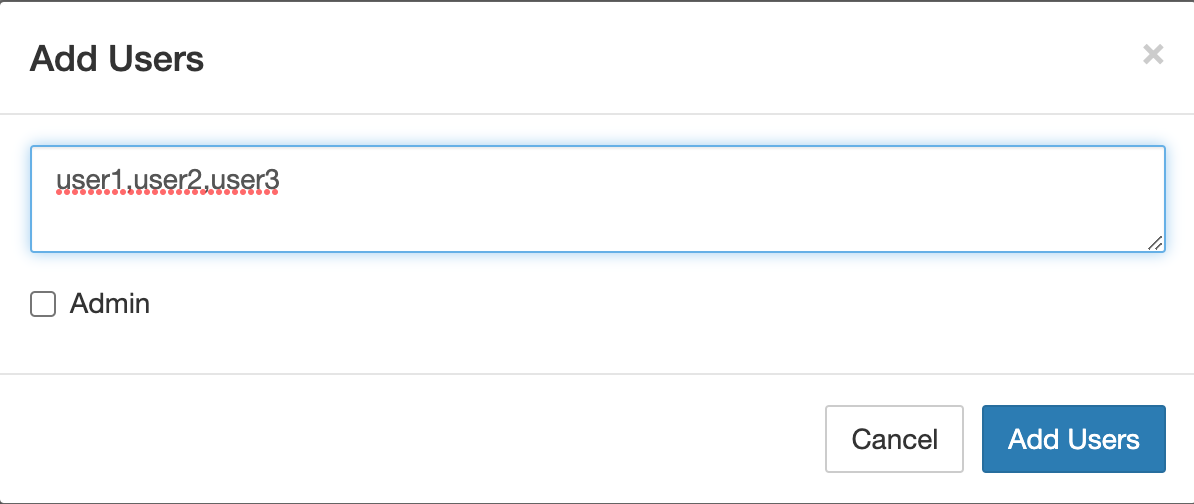

必要な情報を入力して、完了したら[追加]をクリックします。

認証基盤:ユーザが利用しているアカウントを学認、もしくはmdxローカルアカウント(mdx認証基盤)のいずれかで指定します。

- 学認IDもしくはmdx独自ID:追加するユーザのIDを入力してください。(mdxでは、各IdPが提供するeduPersonPrincipalNameをIDとしています)追加するユーザのIDは、追加するユーザご自身で調べていただく必要があります。追加するユーザご自身に、申請ポータルにログインいただき、右上に表示されるIDを確認するようお伝えください。追加するユーザがmdxローカルアカウント(mdx認証基盤)をご利用の場合は、@mdx.jpの@以前の文字列を入力してください。

メールアドレス:ユーザの連絡先メールアドレス

注:mdxローカルアカウントを利用する場合にはmdx管理者により同IDのアカウントが既にmdxのシステムに登録されている必要があります

5. ポイント購入申請の流れ¶

5.1. ポイント購入申請を行う¶

いずれかの操作によりポイントを購入するプロジェクトの一覧画面に移動します。

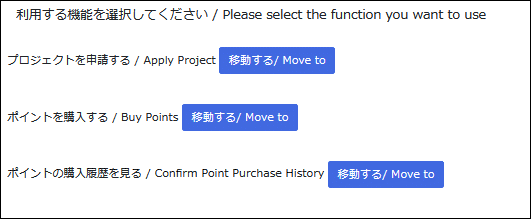

利用する機能を選択する画面で「ポイントを購入する / Buy Points」右の[移動する/ Move to]をクリックします。

「プロジェクト申請一覧/ Project Application List」の画面で[ポイントを購入する / Buy Points]をクリックします。

ポイントを購入するプロジェクトのアクションの[購入する/ Purchase]をクリックします。

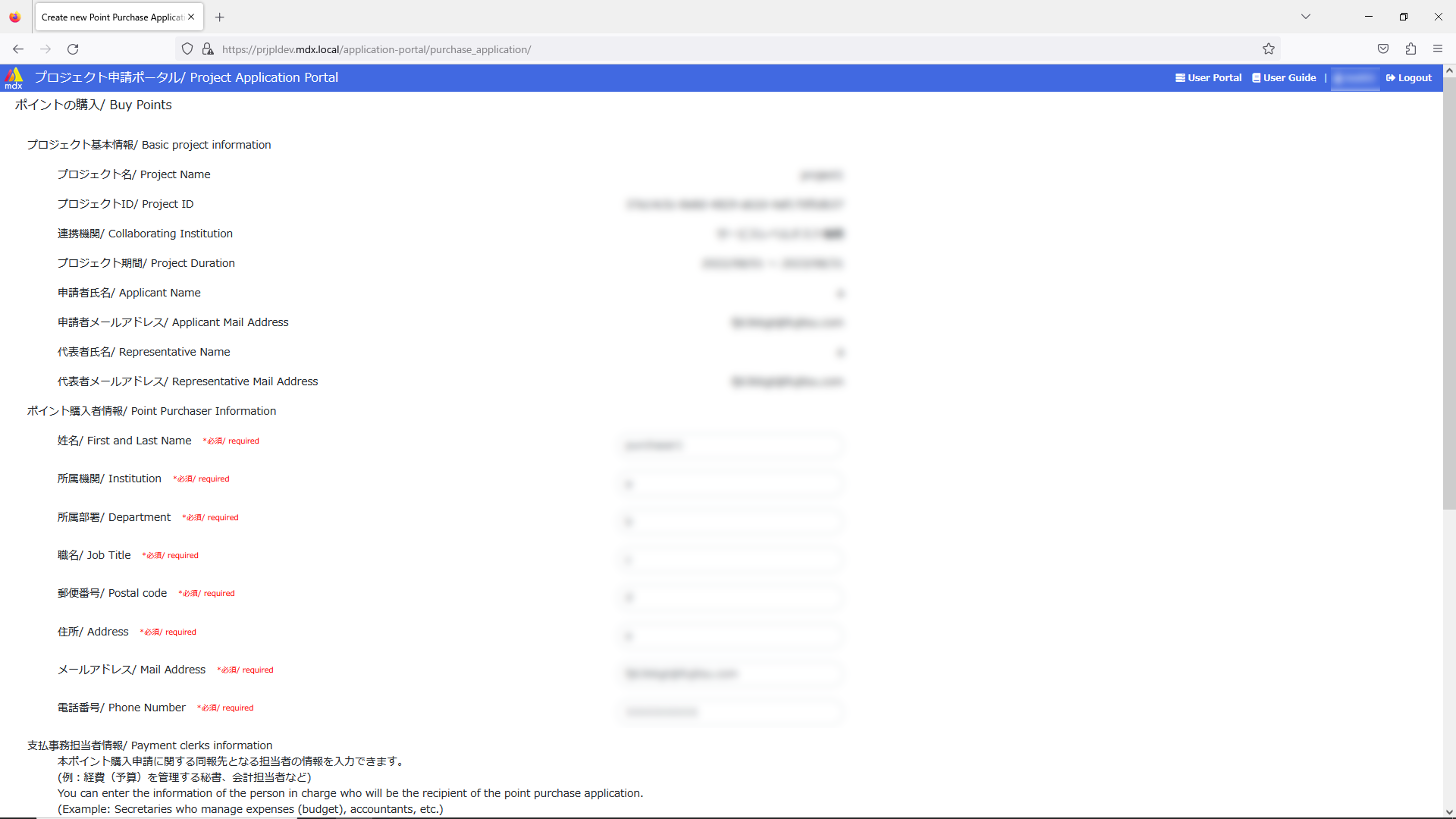

ポイント購入申請に必要な項目を入力します。

[必須/ required]と記載のある項目は必ず入力してください。

ポイント購入申請の入力項目の詳細は ポイント購入申請内容詳細 を参照してください。

入力が完了したら申請画面最下部の左にある[申請内容を確認する/ Confirm the application]をクリックします。

- もし、入力内容に不備がある場合は申請ボタンの上に申請ボタンの上にエラーメッセージが表示されます。また、不備がある項目名が赤色で表示されますので、修正のうえ再度[申請内容を確認する/ Confirm the application]をクリックしてください。

ポイント購入申請の内容を確認して、問題が無ければ[ポイントの購入を申請する/ Apply to purchase points]をクリックしてください。

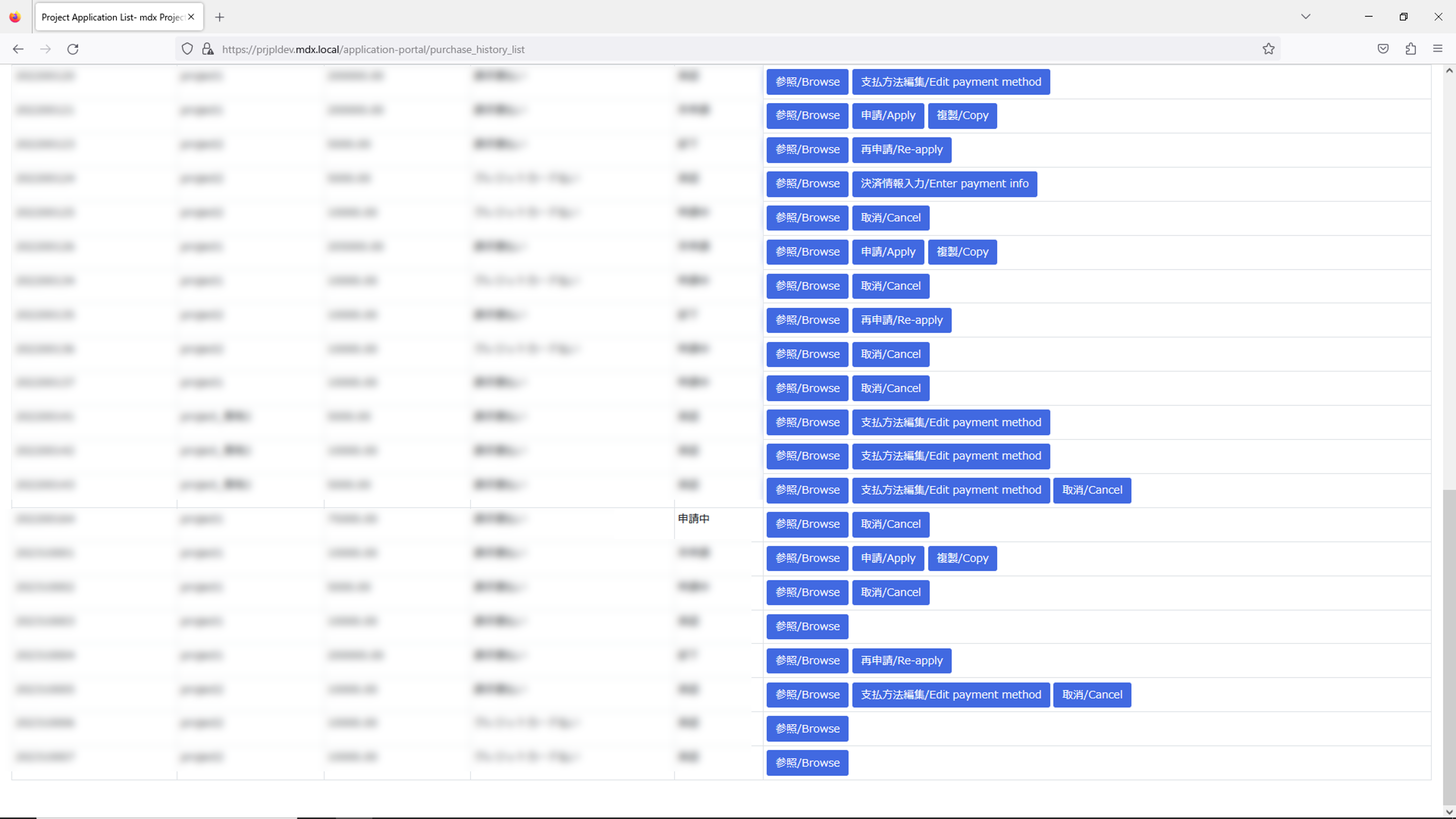

- ポイント購入履歴画面にて、申請したポイント購入申請のステータスが[申請中]で表示されます。以上でポイント購入申請処理は完了です。

ポイント購入申請は以下のような方法でもできます。

5.2. ポイント購入可能なユーザを追加する¶

5.3. 購入ポイントの決済処理を行う(クレジットカード決済のみ)¶

いずれかの操作によりポイント購入履歴の画面に移動します。

利用する機能を選択する画面で「ポイントの購入履歴を見る/ Confirm point purchase history」右の[移動する/ Move to]をクリックします。

「プロジェクト申請一覧/ Project Application List」の画面で[ポイントの購入履歴を見る/ Confirm point purchase history]をクリックします。

決済処理を行うポイント購入申請の行の[決済情報入力/ Enter payment info]をクリックします。

ポイント決済画面に遷移するため、ご利用内容を確認して、問題が無ければ、クレジットカード決済申し込みフォームに必要情報を入力します。

入力画面の下部の[お申し込み内容確認]をクリックします。

6. 資源の申請の流れ¶

6.1. 資源申請を行う¶

その他プロジェクト関連の確認・変更に関する機能は プロジェクトの確認と変更に関する機能 のページをご確認ください。

7. 仮想マシン利用の流れ¶

仮想マシンに関する操作はすべてユーザポータルから実施します。

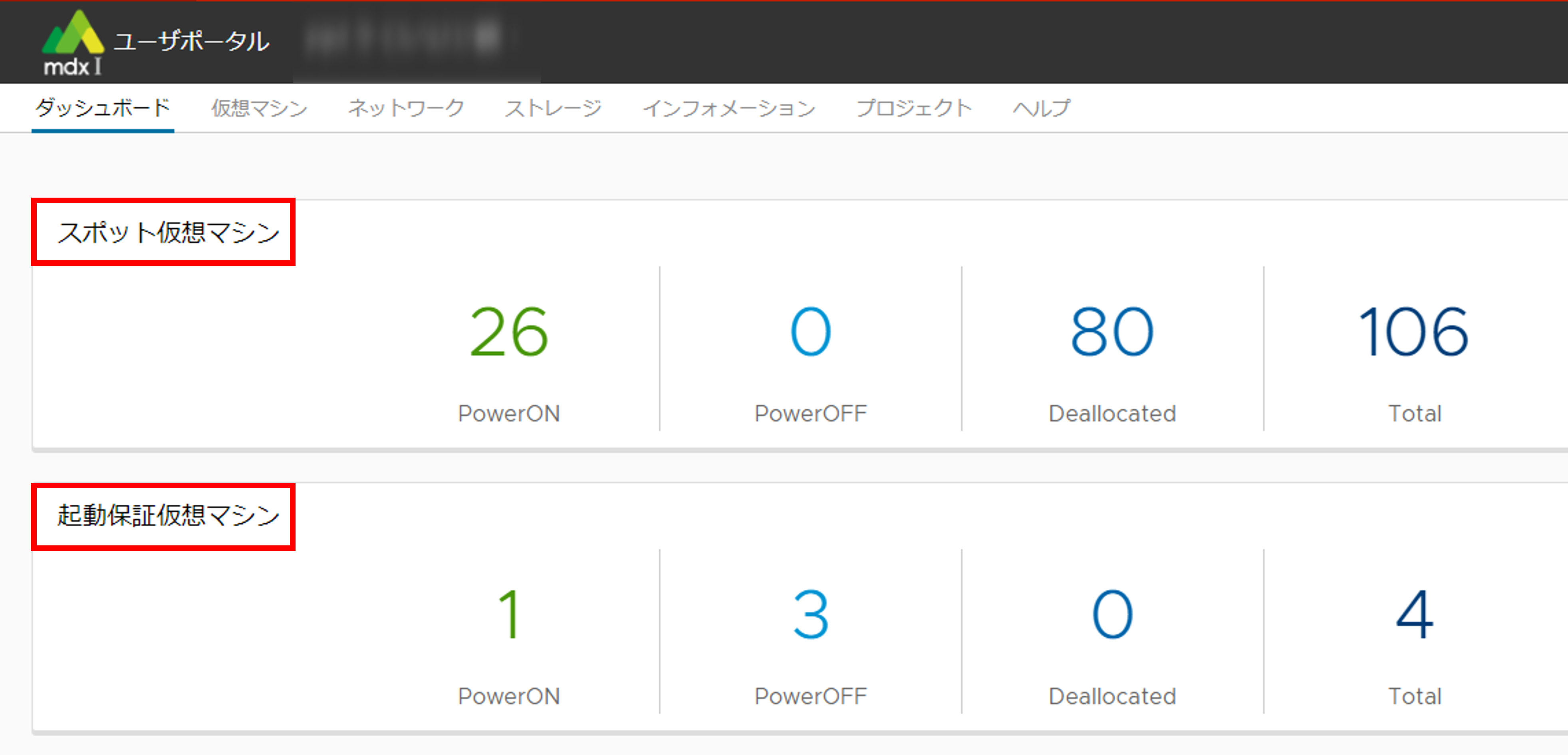

7.1. 資源量の確認¶

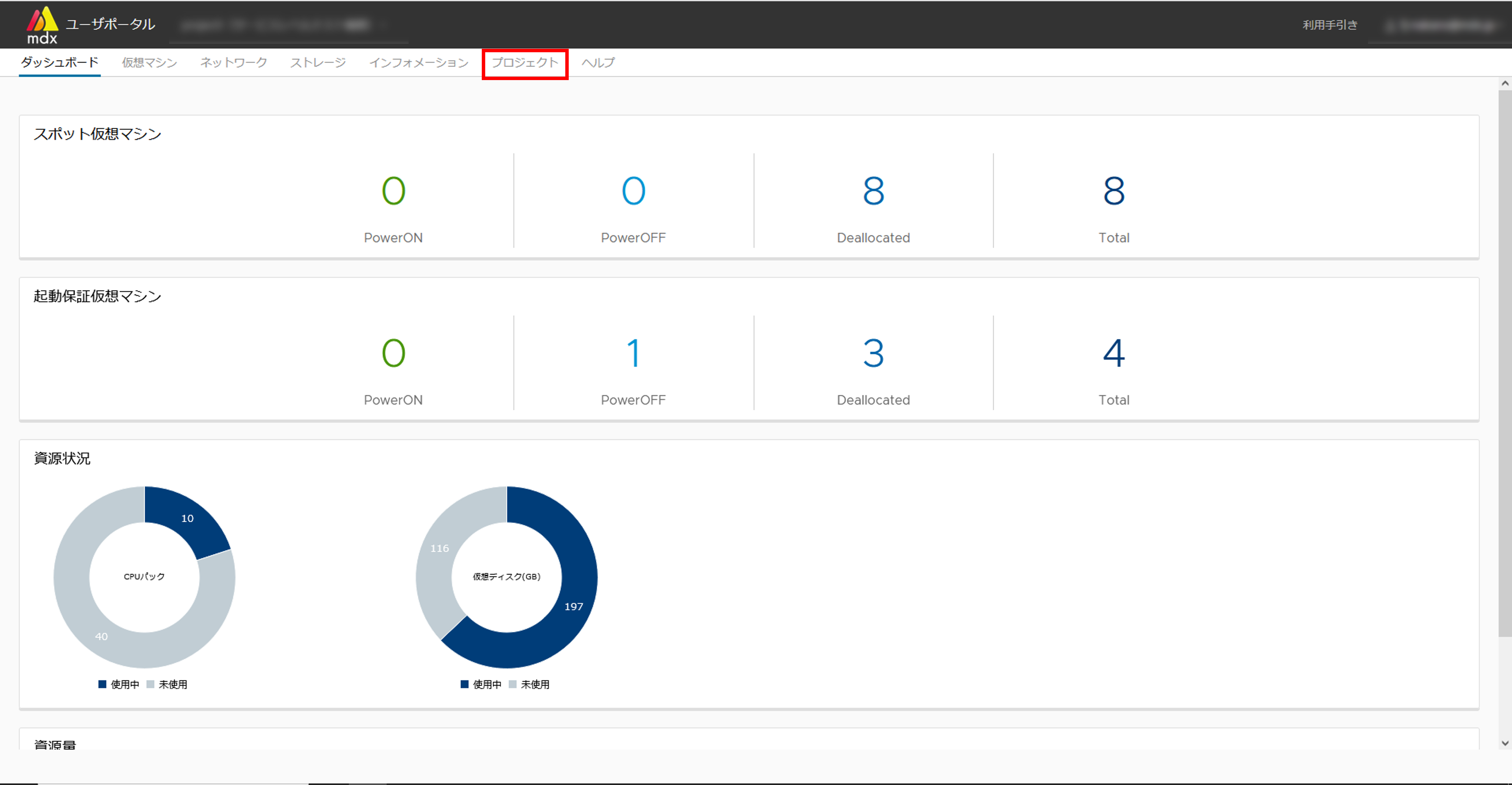

仮想マシンを作成するためには、作成する仮想マシン分の資源が残っている必要があります。 ダッシュボード画面にて、仮想マシンの電源状態や、資源割当状況などが確認できます。

ダッシュボード

ユーザポータルにログインするとはじめにダッシュボードの画面が表示されます。

7.2. 仮想マシンの作成と起動¶

仮想マシンを仮想マシンテンプレート、もしくはご自身で用意いただいたISO形式のマシンイメージから作成および起動までの手順を説明します。

7.2.1. 仮想マシンテンプレートを利用して、仮想マシンを作成する¶

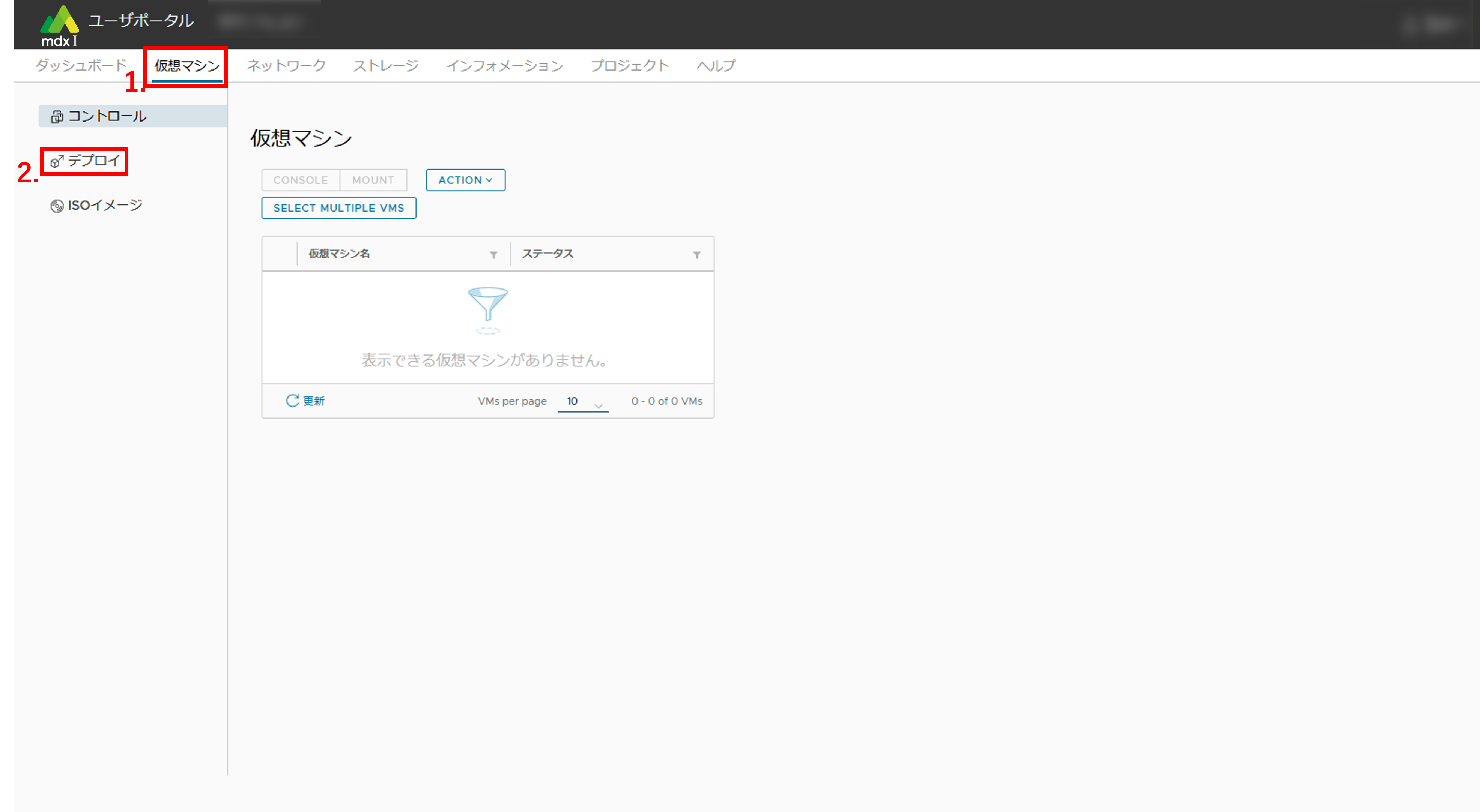

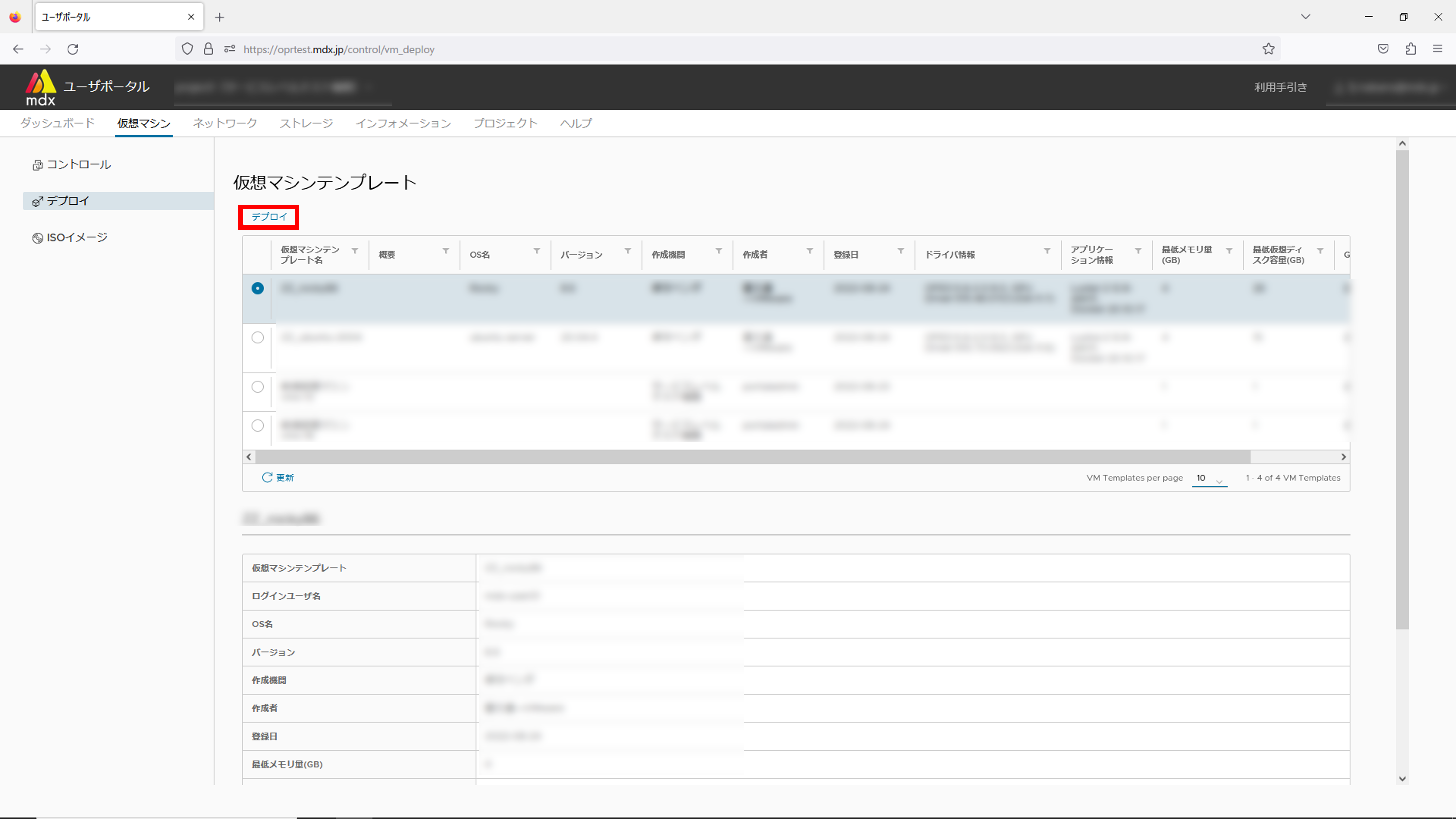

上部メニューから[仮想マシン]をクリックします。

サイドメニューから[デプロイ]をクリックします。

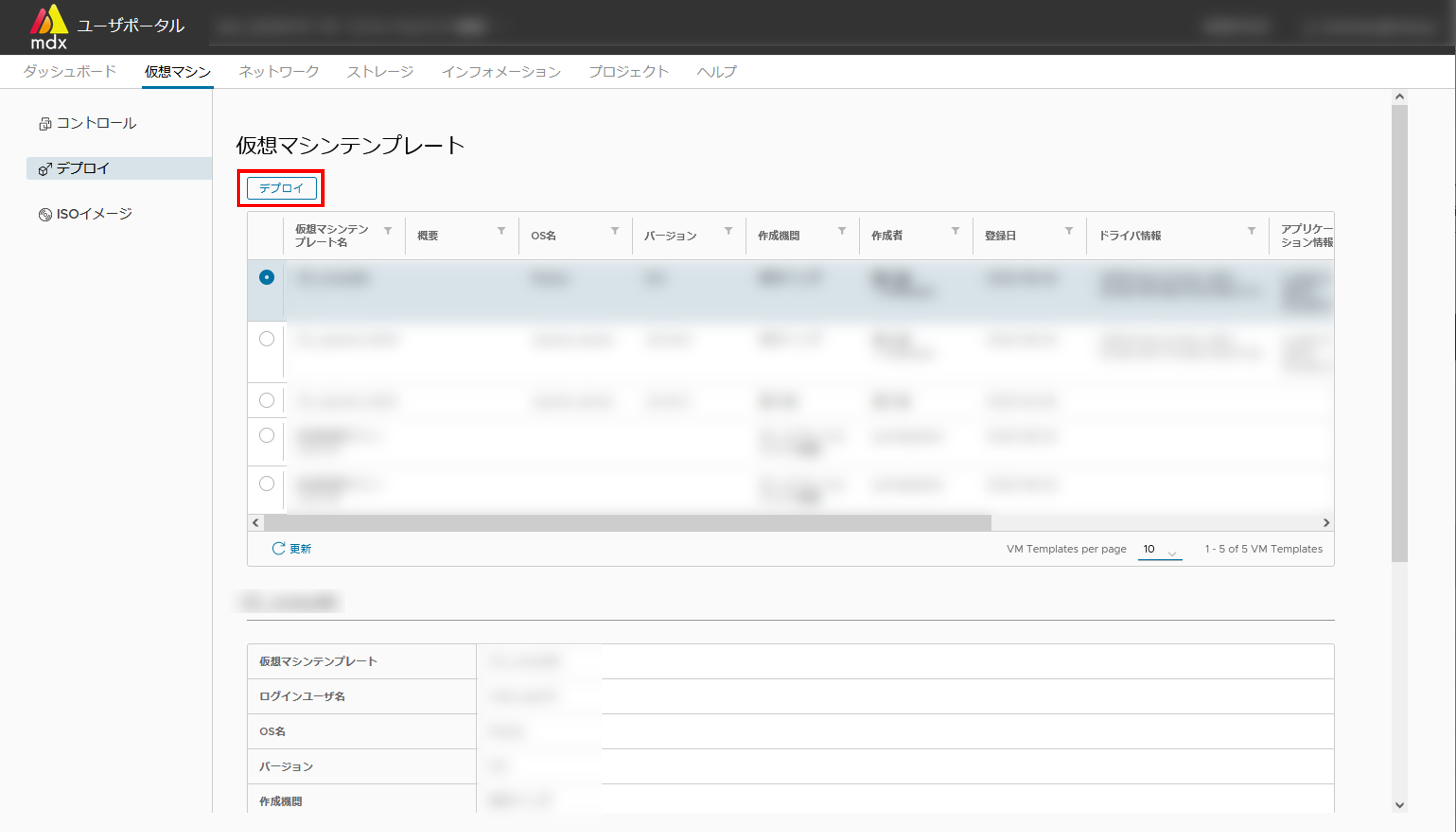

- 表示された仮想マシンのテンプレート一覧から、OS名・バージョンが定義された任意のテンプレートを選択しリスト上部の[デプロイ]をクリックします。

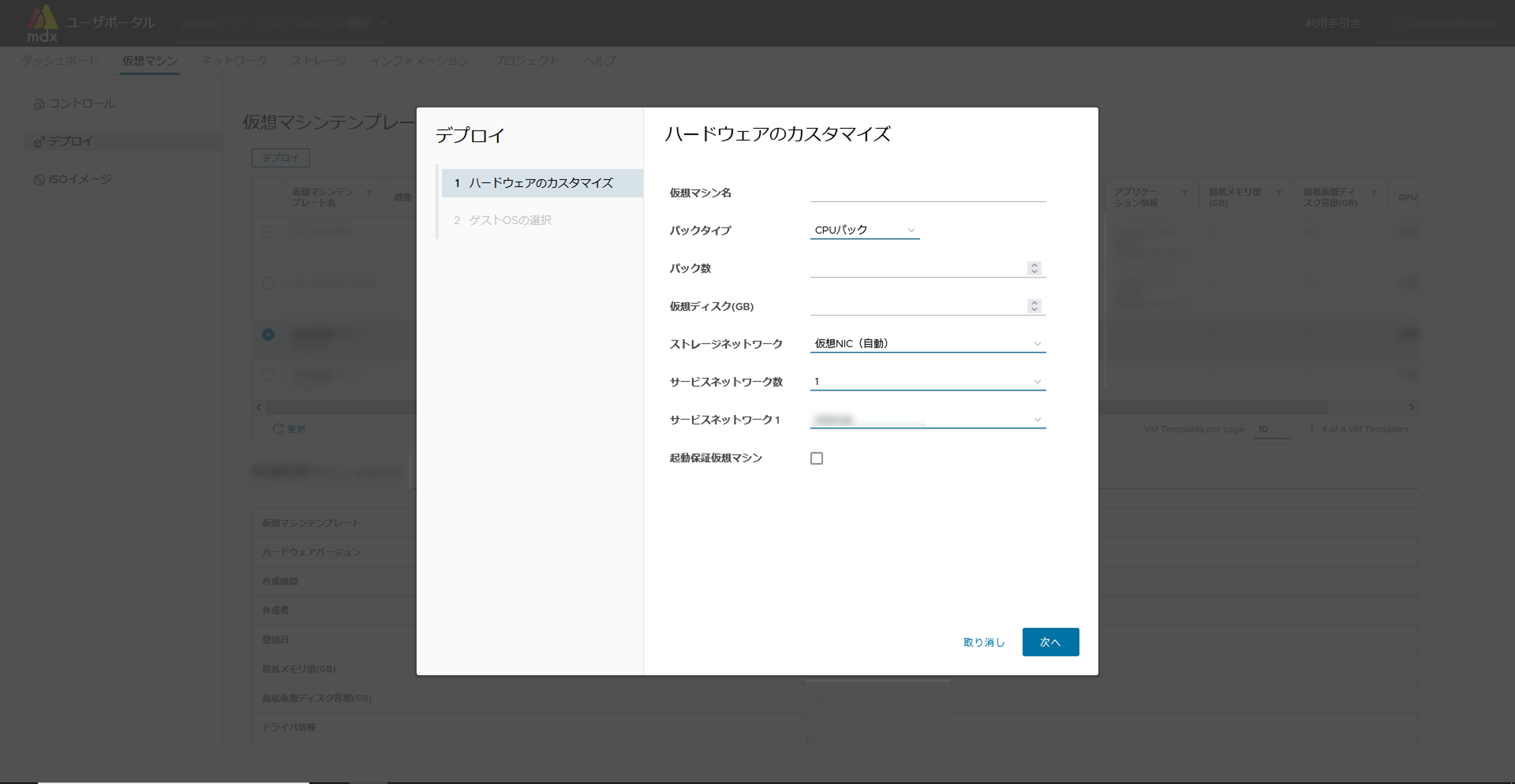

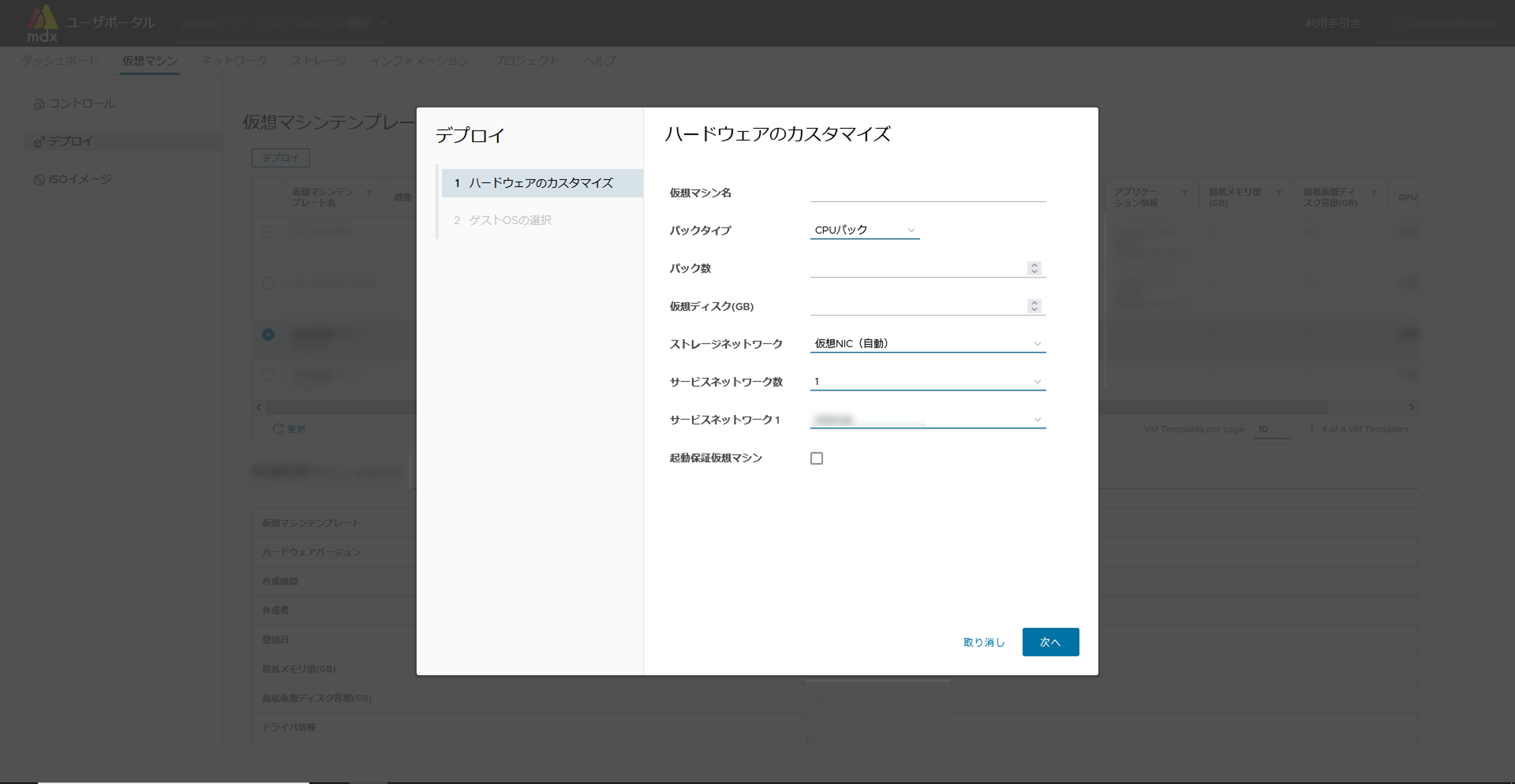

ハードウェアのカスタマイズ画面にて必要事項を入力します。入力が完了したら[デプロイ]をクリックします。

詳細は デプロイ時の設定項目 をご確認ください。

仮想マシンへのログイン時に必要となりますので表示された[ログインユーザ名]を手元に控えておいてください。

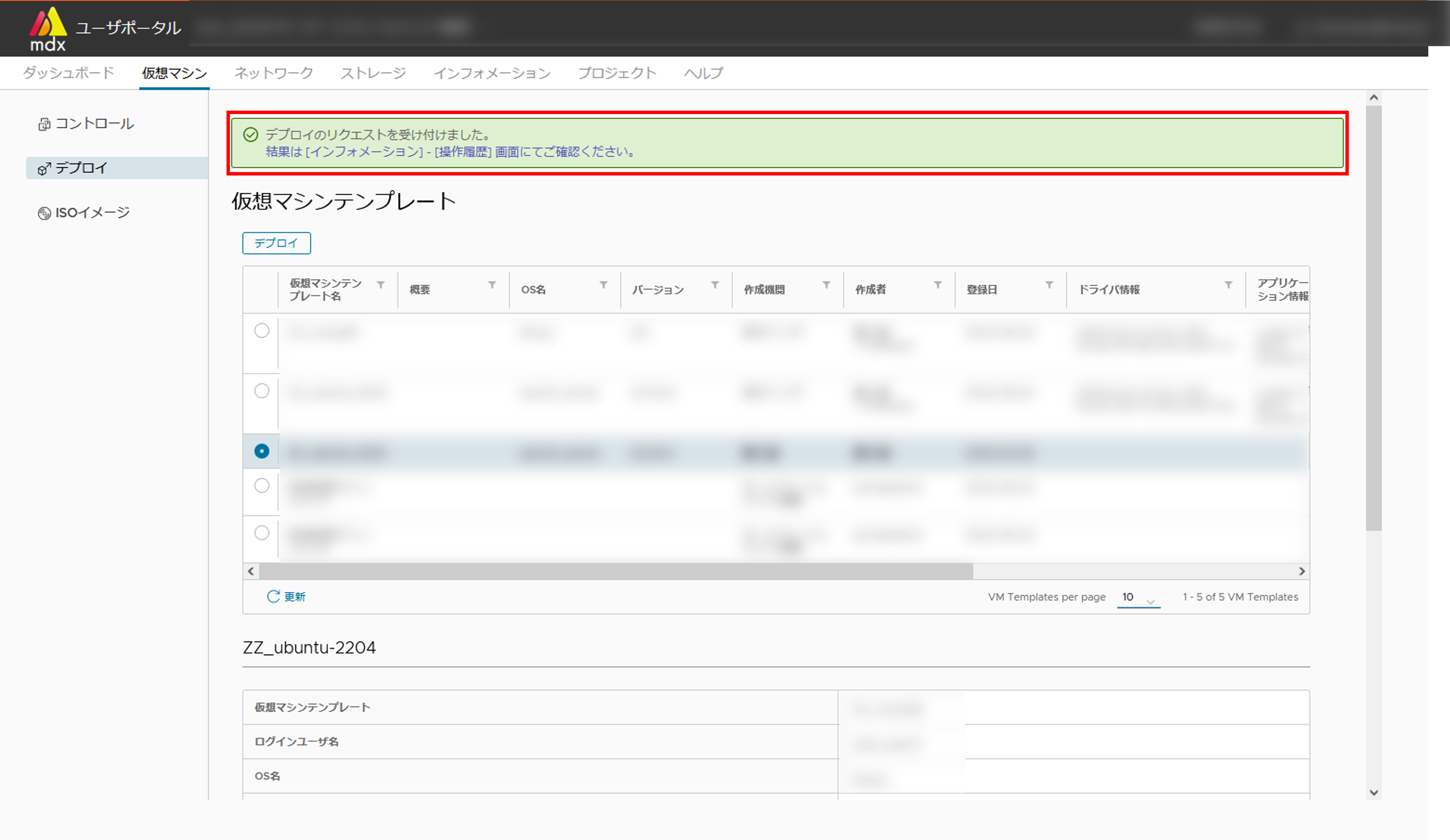

画面上部にリクエストを受け付けた旨のメッセージが表示されます。

リクエストの完了までには環境に応じて数分を要します。

リクエストの進捗状況につきましてはメッセージに記載の[操作履歴]画面へのリンクより確認が可能です。

リクエストの受付に失敗した旨のエラーメッセージが表示された場合には、機関の管理者までお問い合わせください。

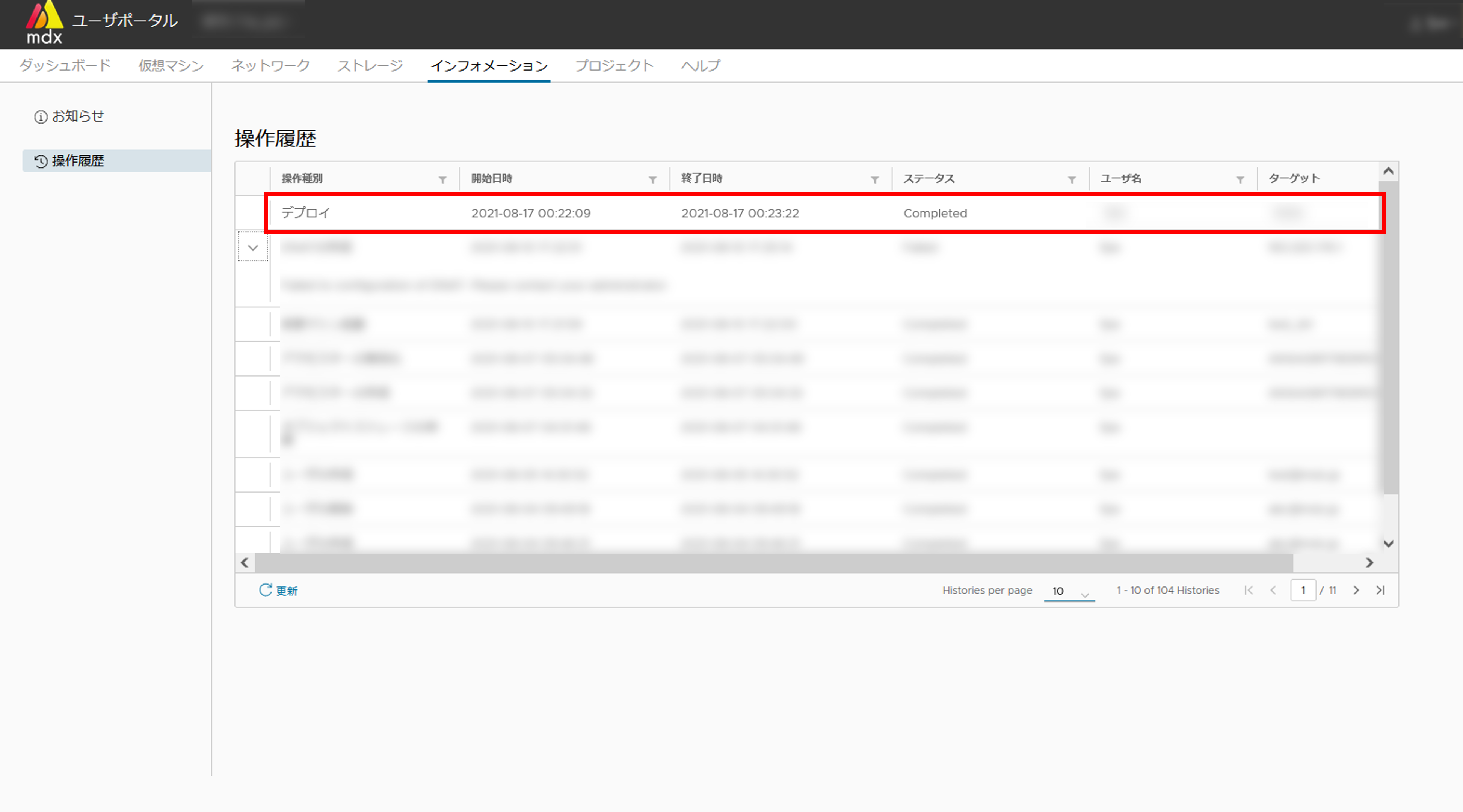

操作履歴画面にて自身の行った操作の結果をステータス欄で確認します。

[Completed]の場合は、次の手順に進みます。

[Failed]の場合は、項目左の[>]をクリックすることで失敗の詳細を確認することができます。

上部メニューから[仮想マシン]をクリックして仮想マシンのコントロール画面に戻ります。

メイン画面に仮想マシンの一覧が表示されますので、一覧から今作成した仮想マシンを検索・選択します。

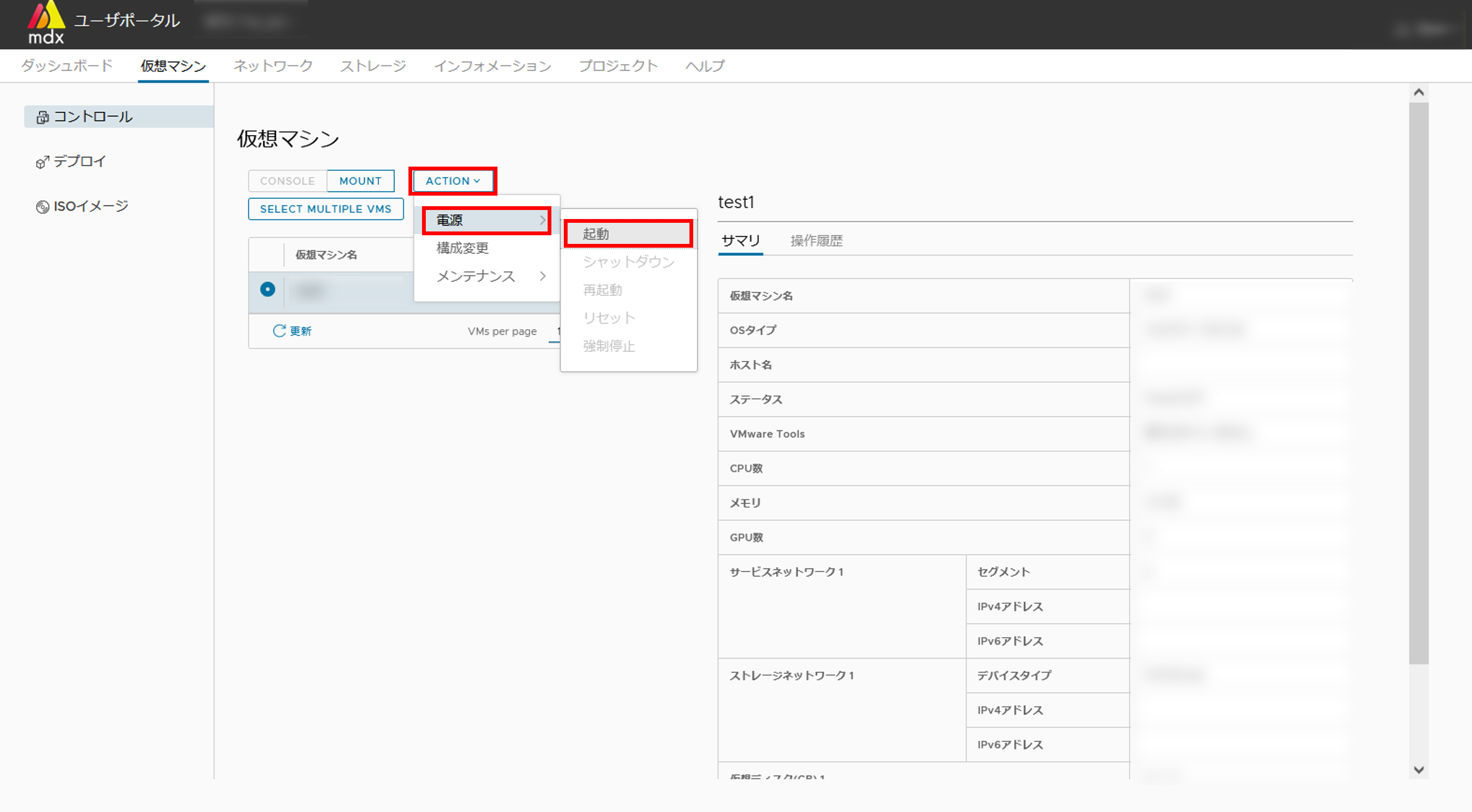

([デプロイ後に起動する]を選択していない場合)リスト上部の[ACTION]から、[電源] > [起動]の順でクリックし、確認メッセージで[はい]をクリックします。

仮想マシンの起動状態を以下で確認します。

上記が確認できましたら以上で起動処理は完了となります。

7.2.2. ISOイメージを指定して、仮想マシンを作成し、OSをインストールする¶

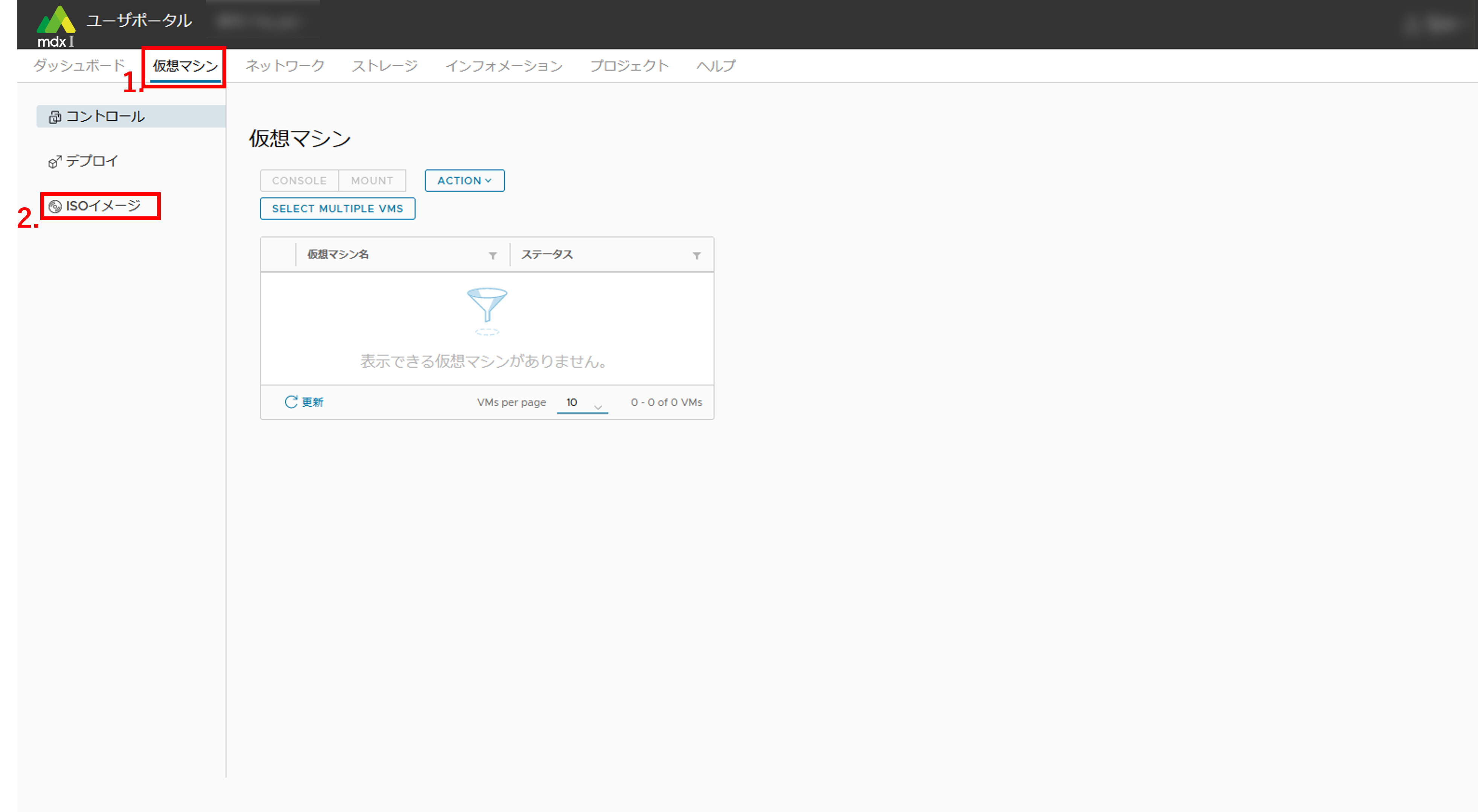

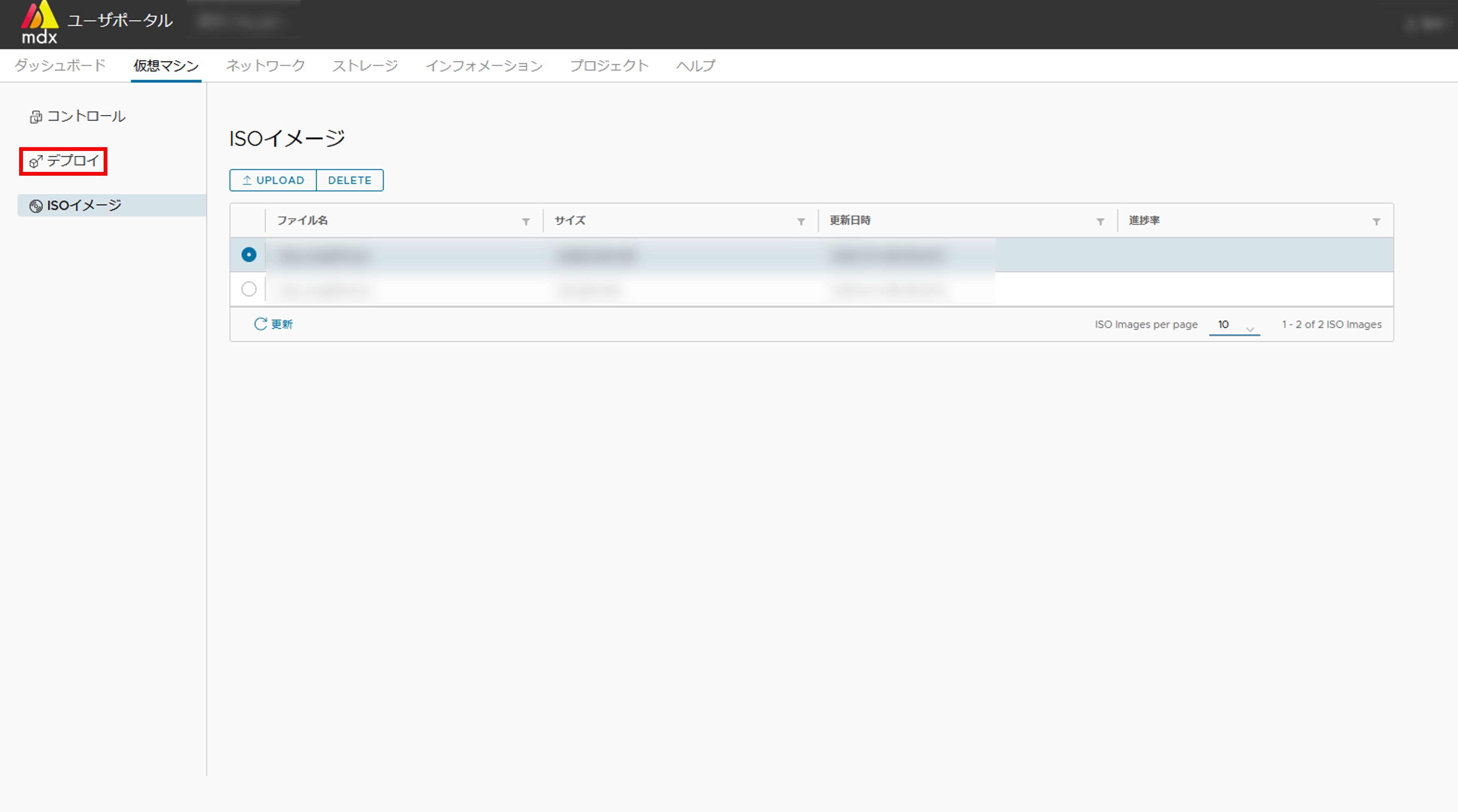

上部メニューから[仮想マシン]をクリックします。

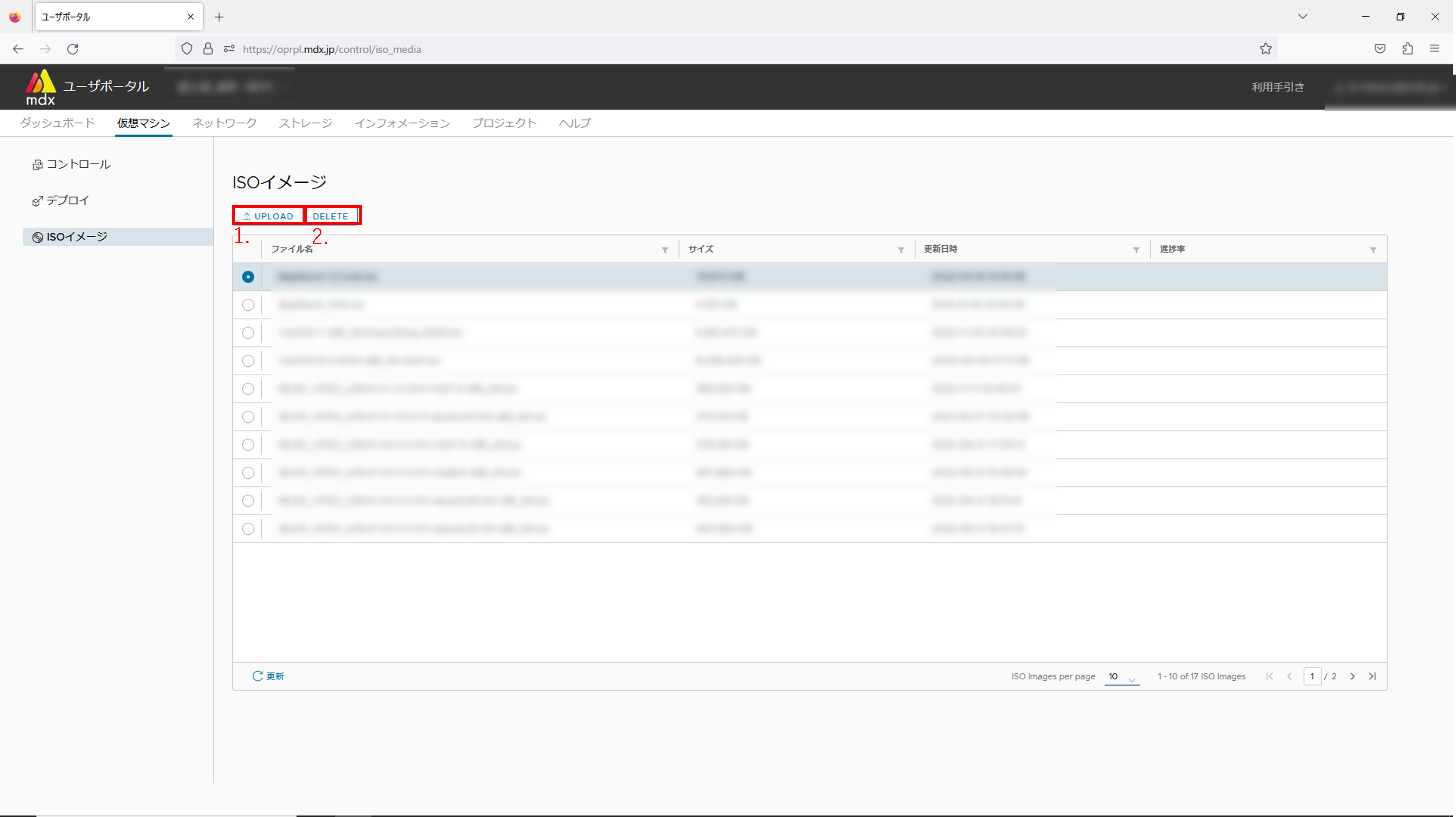

サイドメニューから[ISOイメージ]をクリックします。

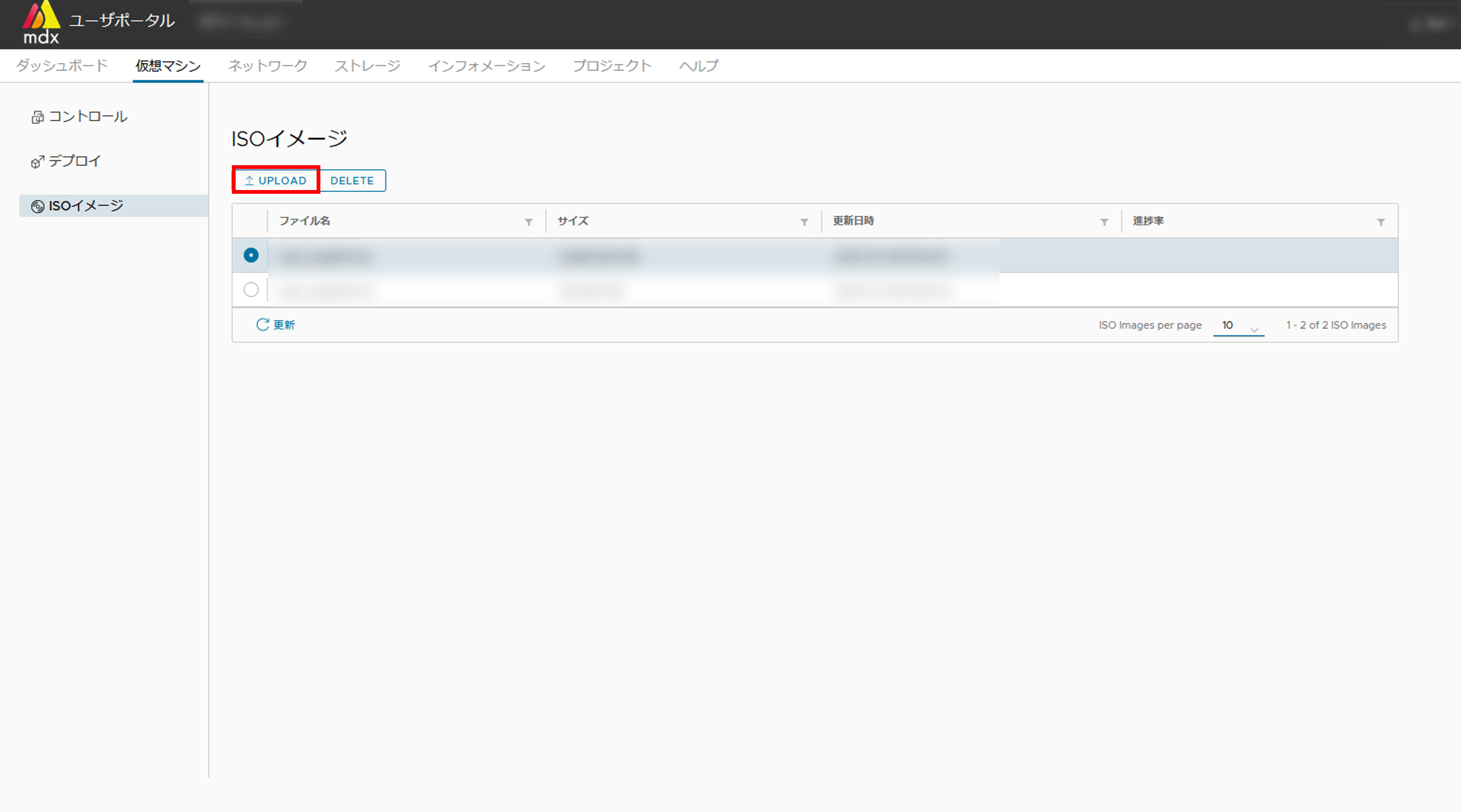

- 表示されたISOイメージの一覧に利用したいISOイメージがアップロードされているかを確認します。アップロードされていない場合にはリスト上部[UPLOAD]をクリックします。

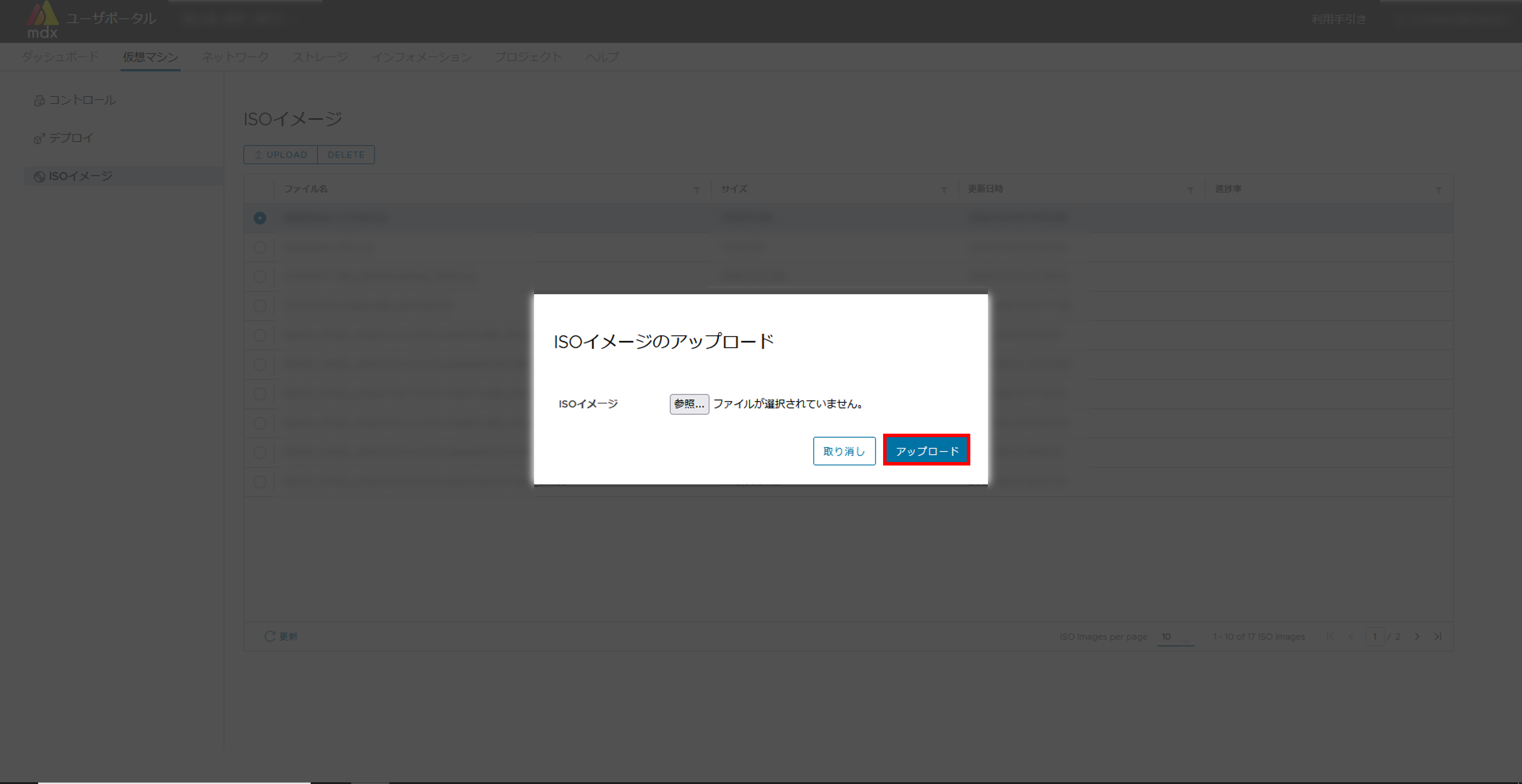

- [参照]からアップロードしたいISOイメージを選択し、[アップロード]をクリックします。アップロードの進捗は操作履歴画面から確認できます。

注釈

アップロードが完了したらサイドメニューから[デプロイ]をクリックします。

表示された仮想マシンのテンプレート一覧から、"ISO_image"を選択しリスト上部の[デプロイ]をクリックします。

ハードウェアのカスタマイズ画面にて必要事項を入力します。入力する項目の詳細は デプロイ時の設定項目 をご確認ください。

必要事項の入力が完了したら[次へ]をクリックします。

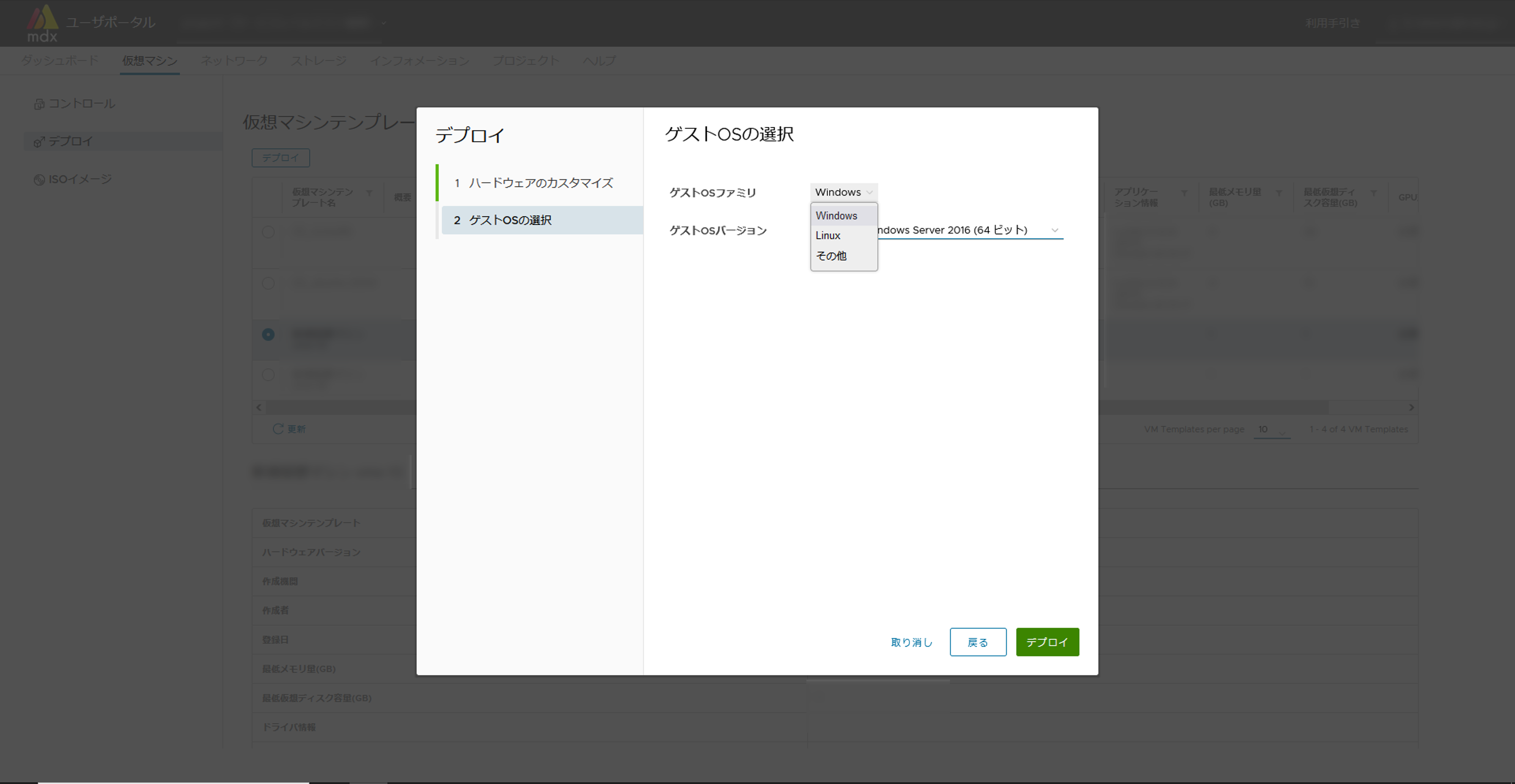

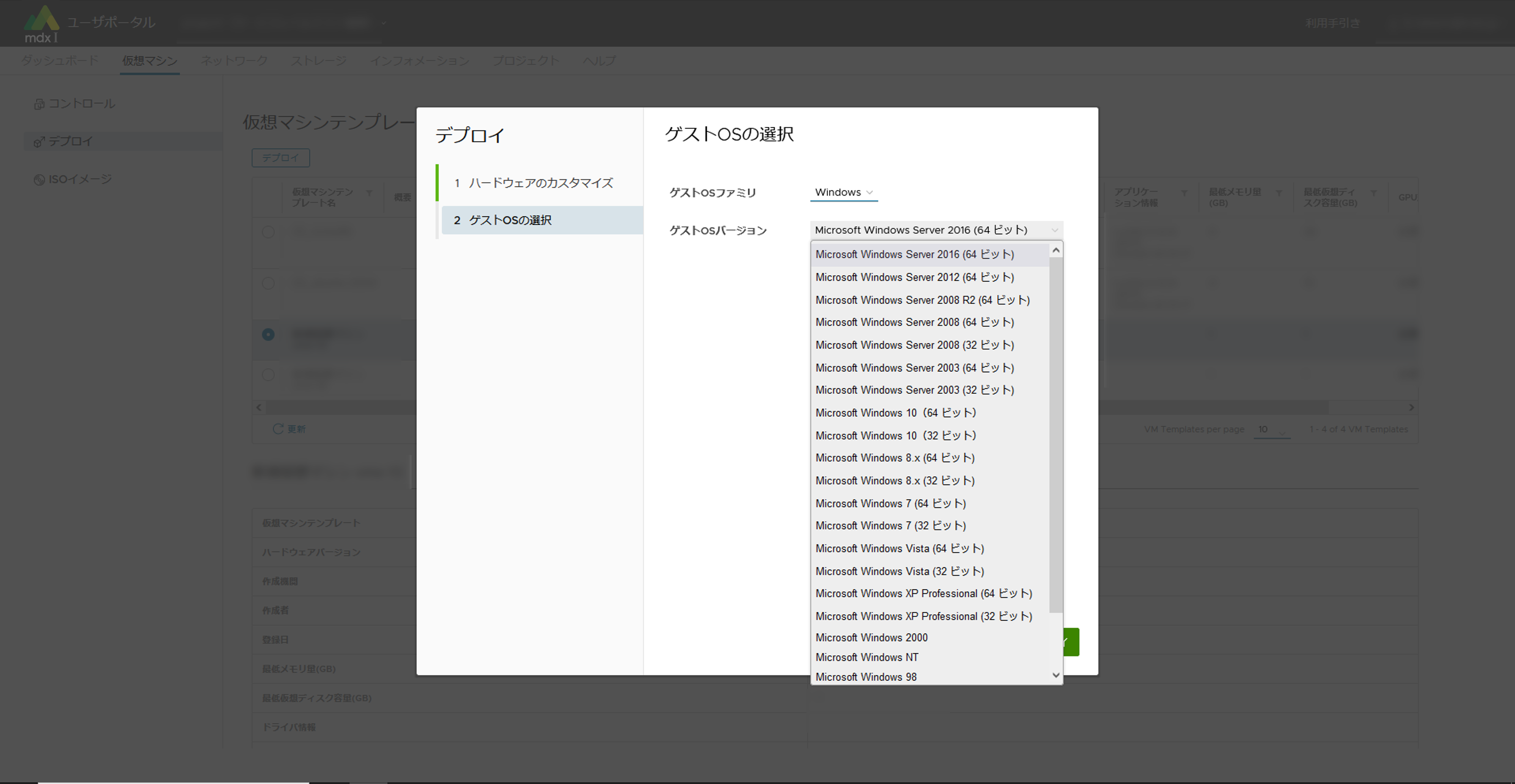

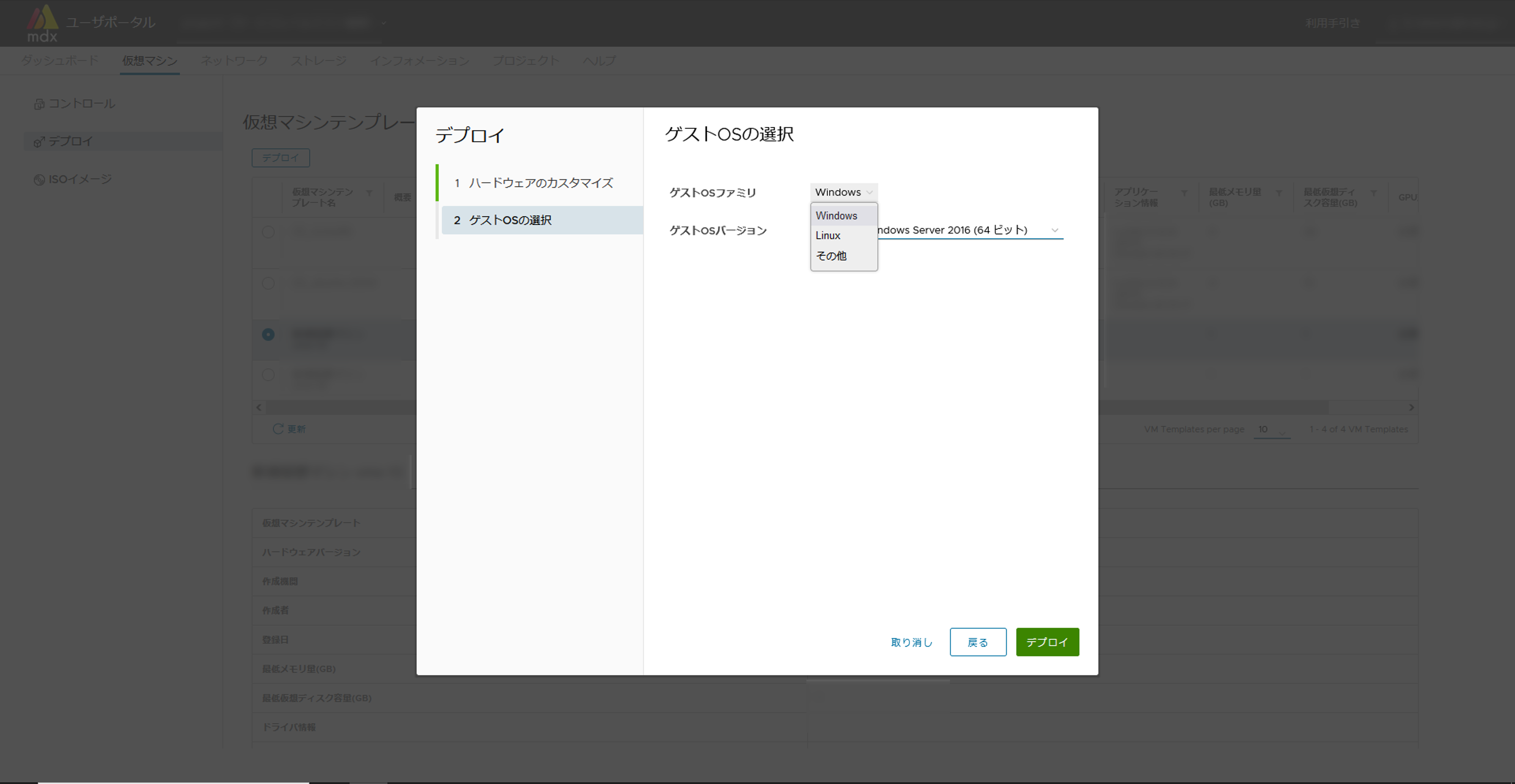

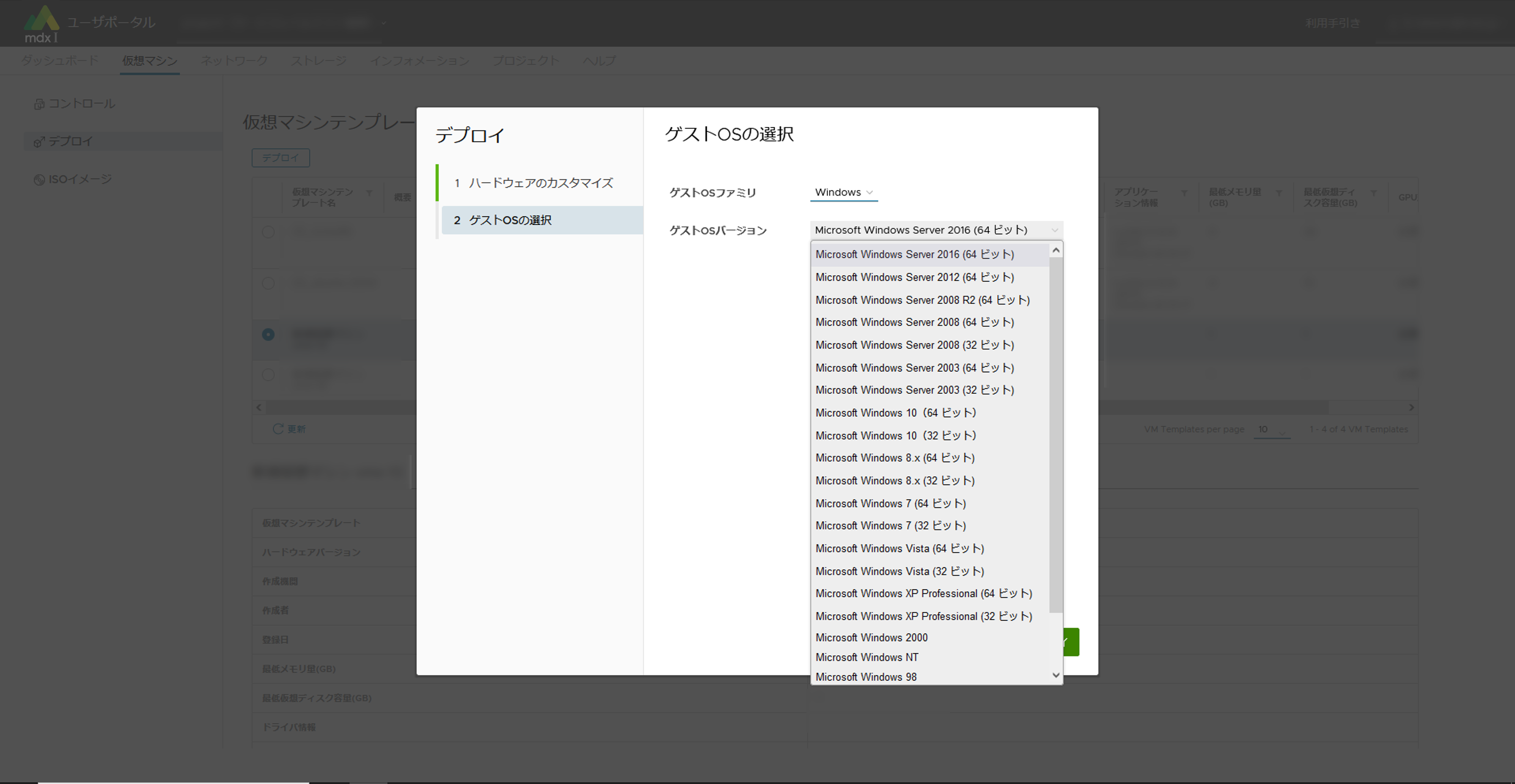

ゲストOSの選択画面にて必要事項を入力します。入力する項目の詳細は デプロイ時の設定項目 をご確認ください。

任意のOSバージョンが選択できない場合には、テンプレートのハードウェアバージョンが影響している可能性があります。その際には機関管理者までお問い合わせください。

必要事項の入力が完了したら[デプロイ]をクリックします。デプロイの進捗は操作履歴画面から確認できます。

デプロイが完了したら、上部メニューから[仮想マシン]をクリックしてコントロール画面に移動します。

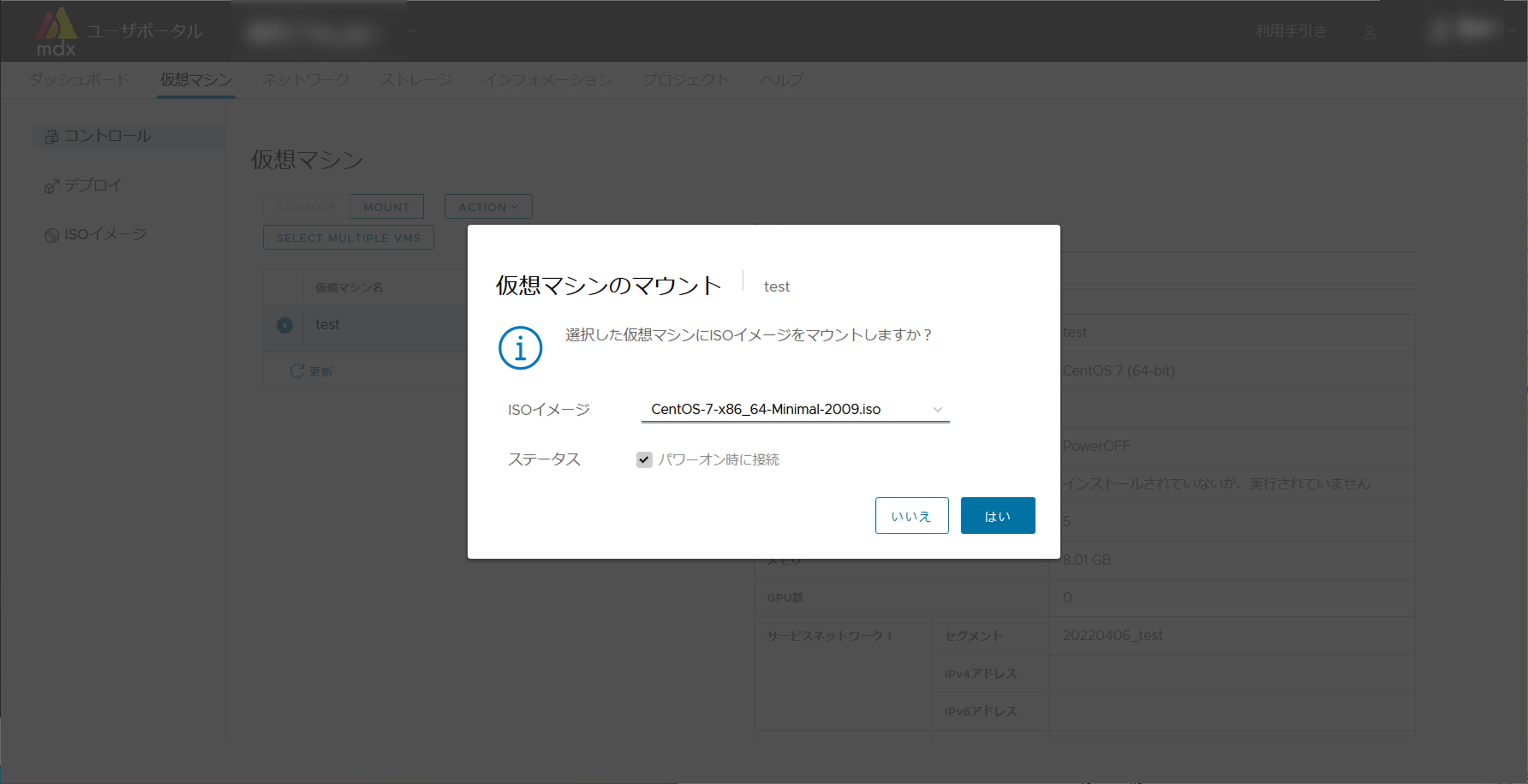

仮想マシンのリストから、デプロイした仮想マシンを選択した状態で、リスト上部の[MOUNT]をクリックします。

プルダウンメニューから仮想マシンにインストールするISOイメージファイルを選択して[はい]をクリックします。

リスト上部の[ACTION]から、[電源] > [起動]の順でクリックし、確認メッセージで[はい]をクリックします。

リスト上部の[CONSOLE]をクリックし、ブラウザの別のタブにコンソール画面を表示させます。

コンソール画面からOSごとにインストール処理を行います。

インストールが完了後、ユーザポータル側で画面右側のサマリにて仮想マシンのIPアドレス(サービスネットワーク)が取得できていることを確認します。

上記が確認できましたら以上で起動処理は完了となります。

7.3. 仮想マシンにアクセスするネットワークの情報を設定する¶

仮想マシンにアクセスするためには、仮想マシンにアクセスするネットワークについて設定を行う必要があります。

7.4. 仮想マシンにアクセスする¶

7.4.1. 他のメンバが管理する仮想マシンにアクセスする場合¶

仮想マシンのグローバルIPアドレス

ユーザ名

公開鍵認証でない場合、パスワード

7.5. 高速内部ストレージ、大容量ストレージをマウントする¶

7.5.1. 仮想マシンテンプレートを利用した仮想マシンの場合¶

以下の仮想マシンテンプレートで作成した仮想マシンの場合はLustre Clientの設定が必要です。

01_Ubuntu-2204-desktop-gpu (Recommended)

01_Ubuntu-2204-desktop (Recommended)

01_Ubuntu-2204-server-gpu (Recommended)

01_Ubuntu-2204-server (Recommended)

02_cluster-pack-client

02_cluster-pack-server

02_MateriApps-live

上記以外の仮想マシンテンプレートを利用した場合は自動でLustreのマウントが行われるため、Lustre Clientの設定は不要です。

OFED ドライバのインストール

インストール済みのため、必要ありません。

Lustre Client のインストール

インストール済みのため、必要ありません。

Lustre Client の設定

/etc/lnet.conf.ddn の設置と修正

/etc/lnet.conf.ddn.j2 の名称を/etc/lnet.conf.ddn に変更します。$ sudo mv /etc/lnet.conf.ddn.j2 /etc/lnet.conf.ddn

設定ファイルを修正します。修正箇所は「- net type: o2ib10」と「- net type: tcp10」のブロック内の、nid のIP アドレスとinterfaces のデバイス名です。{{ ib_src_ipaddr }}、{{ tcp_src_ipaddr }} を「ストレージネットワーク1」のIPv4アドレスに置換します。{{ ib_netif }}、{{ tcp_netif }} を「ストレージネットワーク1」のネットワークインタフェース(ens*)に置換します。「ストレージネットワーク1」のインタフェースのデバイス名の確認方法は、仮想マシンにてターミナルを開き、「ip -br addr」コマンドを実行いただくことで確認可能です。上記コマンドの出力結果のうち、「ストレージネットワーク1」のIPアドレスが表示された行の1カラム目に出力している項目が、ネットワークインタフェース名になります。例:「Storage Network 1」のIPアドレスが「10.134.82.79/21」であった場合。以下の実行例では、「ens194」が「ストレージネットワーク1」のネットワークインタフェース名になります。$ ip -br addr lo UNKNOWN 127.0.0.1/8 ::1/128 ens163 UP 10.aaa.bbb.ccc/21 2001:2f8:1041:223:9ba2:6ea9:3fd4:d289/64 fe80::d707:ca60:98a:cfb2/64 ens194 UP 10.134.82.79/21 fe80::698:e5e1:3574:f2e6/64

以下にIPアドレスが「10.134.82.79」、ネットワークインタフェース名が「ens194」の場合の変更例を記載します。

修正前:

- net type: o2ib10 local NI(s): - nid: {{ ib_src_ipaddr }}@o2ib10 status: up interfaces: 0: {{ ib_netif }} - net type: tcp10 local NI(s): - nid: {{ tcp_src_ipaddr }}@tcp10 status: up interfaces: 0: {{ tcp_netif }}

修正後:

- net type: o2ib10 local NI(s): - nid: 10.134.82.79@o2ib10 status: up interfaces: 0: ens194 - net type: tcp10 local NI(s): - nid: 10.134.82.79@tcp10 status: up interfaces: 0: ens194

/etc/fstab を修正

ストレージネットワークのタイプに「仮想NIC(自動)」を選択した場合はlustre (tcp)の2行、「SR-IOV」を選択した場合はlustre (rdma)の2行のコメントアウトを解除します。

以下にストレージネットワークのタイプ「SR-IOV」を選択した場合を記載します。

修正前:

# lustre (tcp) #172.17.8.40@tcp10:172.17.8.41@tcp10:/fast /fast lustre network=tcp10,flock,noauto,defaults 0 0 #172.17.8.56@tcp10:172.17.8.57@tcp10:/large /large lustre network=tcp10,flock,noauto,defaults 0 0 # lustre (rdma) #172.17.8.40@o2ib10:172.17.8.41@o2ib10:/fast /fast lustre network=o2ib10,flock,noauto,defaults 0 0 #172.17.8.56@o2ib10:172.17.8.57@o2ib10:/large /large lustre network=o2ib10,flock,noauto,defaults 0 0

修正後:

# lustre (tcp) #172.17.8.40@tcp10:172.17.8.41@tcp10:/fast /fast lustre network=tcp10,flock,noauto,defaults 0 0 #172.17.8.56@tcp10:172.17.8.57@tcp10:/large /large lustre network=tcp10,flock,noauto,defaults 0 0 # lustre (rdma) 172.17.8.40@o2ib10:172.17.8.41@o2ib10:/fast /fast lustre network=o2ib10,flock,noauto,defaults 0 0 172.17.8.56@o2ib10:172.17.8.57@o2ib10:/large /large lustre network=o2ib10,flock,noauto,defaults 0 0

/etc/modprobe.d/lustre.conf を修正

この修正は、ストレージネットワークのタイプに「仮想NIC(自動)」を選択した場合に修正必要になります。ストレージネットワークのタイプに「SR-IOV」を選択した場合は、修正必要ありません。修正前:

options lnet lnet_peer_discovery_disabled=1 options lnet lnet_transaction_timeout=100 # lustre (tcp) #options ksocklnd rx_buffer_size=16777216 #options ksocklnd tx_buffer_size=16777216

修正後:

options lnet lnet_peer_discovery_disabled=1 options lnet lnet_transaction_timeout=100 # lustre (tcp) options ksocklnd rx_buffer_size=16777216 options ksocklnd tx_buffer_size=16777216

Lustreクライアントサービスの自動起動を設定し、仮想マシンを再起動します。

$ sudo systemctl enable lustre_client $ sudo reboot再起動後、/large と /fast がlustreストレージとしてマウントされます。

7.5.2. 仮想マシンテンプレートを使用しない場合 (Rocky Linux 8)¶

OSは Rocky Linux release 8.10 (Rocky-8.10-x86_64-dvd1.iso: 公式ページ などから入手)を前提としています。

- OFED ドライバのインストールMellanox 社のWeb からOFED ドライバのISO イメージ「MLNX_OFED_LINUX-23.10-5.1.4.0-rhel8.10-x86_64.iso」を入手します。ISO イメージをマウントし、インストールスクリプトを実行します。この際、インストールするモジュールの選択として「--guest(VM のゲストOS 用)」を指定します。

# mount -o ro,loop MLNX_OFED_LINUX-23.10-5.1.4.0-rhel8.10-x86_64.iso /mnt # cd /mnt # ./mlnxofedinstall --guest

OSに含まれるパッケージのうち、環境にインストールされていないものがある場合、OFEDのインストールに失敗することがあります。その場合は、OSのISOイメージからそれらのパッケージをインストールしてください。(インターネット公開された最新パッケージを適用しない)。 - Lustre Client ソース・設定ファイルひな形入手DDN 社が提供するLustre Client のソースプログラムファイルと、Lustre Client 用の各種設定ファイルのひな形をmdx 内からのみアクセス可能なWeb サーバから入手します。

lustre-2.14.0_ddn198.tar.gz

lustre_config_rocky_rdma.tgz(rdma を使用する場合)

lustre_config_rocky_tcp.tgz(tcp を使用する場合)

# wget http://172.16.2.26/lustre-2.14.0_ddn198.tar.gz # wget http://172.16.2.26/lustre_config_rocky_rdma.tgz # wget http://172.16.2.26/lustre_config_rocky_tcp.tgz

- Lustre Client パッケージビルド入手したソースプログラムを展開し、パッケージの構築を行います。

# dnf install gcc-gfortran libtool libmount-devel libyaml-devel json-c-devel rpm-build kernel-rpm-macros kernel-abi-whitelists # tar zxf lustre-2.14.0_ddn198.tar.gz # cd lustre-2.14.0_ddn198 # LANG=C # sh autogen.sh # ./configure --with-o2ib=/usr/src/ofa_kernel/default --disable-server --disable-lru-resize # make rpms

- Lustre Client のインストール作成したパッケージの内、以下の2つのパッケージをインストールします。

# rpm -ivh kmod-lustre-client-2.14.0_ddn198-1.el8.x86_64.rpm lustre-client-2.14.0_ddn198-1.el8.x86_64.rpm - Lustre Client の設定入手した設定ファイルのひな形を利用して、各種ファイルの修正・配備を行います。

- /etc/fstab/etc/fstab にLustre Filesystem のエントリを追加します。

SR-IOV を使用する場合は、以下の行をfstab に追加します。

172.17.8.40@o2ib10:172.17.8.41@o2ib10:/fast /fast lustre network=o2ib10,flock,noauto,defaults 0 0 172.17.8.56@o2ib10:172.17.8.57@o2ib10:/large /large lustre network=o2ib10,flock,noauto,defaults 0 0

通常の仮想NIC(VMXNET3)を使用する場合は、以下の行をfstab に追加します。

172.17.8.40@tcp10:172.17.8.41@tcp10:/fast /fast lustre network=tcp10,flock,noauto,defaults 0 0 172.17.8.56@tcp10:172.17.8.57@tcp10:/large /large lustre network=tcp10,flock,noauto,defaults 0 0

- /etc/lnet.conf.ddnetc/lnet.conf.ddn を/etc/lnet.conf.ddn に複写し、自身の環境に合わせて修正します。修正箇所は「- net type: o2ib10」と「- net type: tcp10」のブロック内の、nid のIP アドレスとinterfaces のデバイス名です。「ストレージネットワーク1」のインタフェースのデバイス名の確認方法は、仮想マシンにてターミナルを開き、「ip -br addr」コマンドを実行いただくことで確認可能です。上記コマンドの出力結果のうち、「ストレージネットワーク1」のIPアドレスが表示された行の1カラム目に出力している項目が、ネットワークインタフェース名になります。例:「Storage Network 1」のIPアドレスが「10.134.82.79/21」であった場合。以下の実行例では、「ens194」が「ストレージネットワーク1」のネットワークインタフェース名になります。

$ ip -br addr lo UNKNOWN 127.0.0.1/8 ::1/128 ens163 UP 10.aaa.bbb.ccc/21 2001:2f8:1041:223:9ba2:6ea9:3fd4:d289/64 fe80::d707:ca60:98a:cfb2/64 ens194 UP 10.134.82.79/21 fe80::698:e5e1:3574:f2e6/64

以下にIPアドレスが「10.134.82.79」、ネットワークインタフェース名が「ens194」の場合の変更例を記載します。

修正前:

- net type: o2ib10 local NI(s): - nid: 172.17.8.32@o2ib10 status: up interfaces: 0: enp59s0f0 - net type: tcp10 local NI(s): - nid: 172.17.8.32@tcp10 status: up interfaces: 0: enp59s0f0

修正後:

- net type: o2ib10 local NI(s): - nid: 10.134.82.79@o2ib10 status: up interfaces: 0: ens194 - net type: tcp10 local NI(s): - nid: 10.134.82.79@tcp10 status: up interfaces: 0: ens194

- /etc/sysconfig/lustre_clientetc/sysconfig/lustre_client を/etc/sysconfig/lustre_client に複写します。

- /etc/modprobe.d/lustre.confetc/modprobe.d/lustre.conf を/etc/modprobe.d/lustre.conf に複写します。

- /etc/init.d/lustre_clientetc/init.d/lustre_client を/etc/init.d/lustre_client に複写します。

- /usr/lib/systemd/system/lustre_client.serviceusr/lib/systemd/system/lustre_client.service を/usr/lib/systemd/system/lustre_client.service に複写します。

Lustreクライアントサービスの自動起動を設定し、仮想マシンを再起動します。

$ sudo systemctl enable lustre_client $ sudo reboot再起動後、/large と /fast がlustreストレージとしてマウントされます。

7.5.3. 仮想マシンテンプレートを使用しない場合 (Rocky Linux 9)¶

OSは Rocky Linux release 9.6 (Rocky-9.6-x86_64-dvd1.iso: 公式ページ などから入手)を前提としています。

- OFED ドライバのインストールMellanox 社のWeb からOFED ドライバのISO イメージ「MLNX_OFED_LINUX-24.10-3.2.5.0-rhel9.6-x86_64.iso」を入手します。ISO イメージをマウントし、インストールスクリプトを実行します。この際、インストールするモジュールの選択として「--guest(VM のゲストOS 用)」を指定します。

# mount -o ro,loop MLNX_OFED_LINUX-24.10-3.2.5.0-rhel9.6-x86_64.iso /mnt # cd /mnt # ./mlnxofedinstall --guest

OSに含まれるパッケージのうち、環境にインストールされていないものがある場合、OFEDのインストールに失敗することがあります。その場合は、OSのISOイメージからそれらのパッケージをインストールしてください。(インターネット公開された最新パッケージを適用しない)。 - Lustre Client ソース・設定ファイルひな形入手DDN 社が提供するLustre Client のソースプログラムファイルと、Lustre Client 用の各種設定ファイルのひな形をmdx 内からのみアクセス可能なWeb サーバから入手します。

lustre-2.14.0_ddn198.tar.gz

lustre_config_rocky_rdma.tgz(rdma を使用する場合)

lustre_config_rocky_tcp.tgz(tcp を使用する場合)

# wget http://172.16.2.26/lustre-2.14.0_ddn198.tar.gz # wget http://172.16.2.26/lustre_config_rocky_rdma.tgz # wget http://172.16.2.26/lustre_config_rocky_tcp.tgz

- Lustre Client パッケージビルド入手したソースプログラムを展開し、パッケージの構築を行います。

# dnf install libtool flex bison kernel-devel keyutils-libs-devel libmount-devel rpm-build kernel-abi-stablelists kernel-rpm-macros initscripts # dnf --enablerepo=devel install libyaml-devel json-c-devel # tar zxf lustre-2.14.0_ddn198.tar.gz # cd lustre-2.14.0_ddn198 # LANG=C # sh autogen.sh # ./configure --with-o2ib=/usr/src/ofa_kernel/default --disable-server --disable-lru-resize # make rpms

- Lustre Client のインストール作成したパッケージの内、以下の2つのパッケージをインストールします。

# rpm -ivh kmod-lustre-client-2.14.0_ddn198-1.el8.x86_64.rpm lustre-client-2.14.0_ddn198-1.el8.x86_64.rpm - Lustre Client の設定入手した設定ファイルのひな形を利用して、各種ファイルの修正・配備を行います。

- /etc/fstab/etc/fstab にLustre Filesystem のエントリを追加します。

SR-IOV を使用する場合は、以下の行をfstab に追加します。

172.17.8.40@o2ib10:172.17.8.41@o2ib10:/fast /fast lustre network=o2ib10,flock,noauto,defaults 0 0 172.17.8.56@o2ib10:172.17.8.57@o2ib10:/large /large lustre network=o2ib10,flock,noauto,defaults 0 0

通常の仮想NIC(VMXNET3)を使用する場合は、以下の行をfstab に追加します。

172.17.8.40@tcp10:172.17.8.41@tcp10:/fast /fast lustre network=tcp10,flock,noauto,defaults 0 0 172.17.8.56@tcp10:172.17.8.57@tcp10:/large /large lustre network=tcp10,flock,noauto,defaults 0 0

- /etc/lnet.conf.ddnetc/lnet.conf.ddn を/etc/lnet.conf.ddn に複写し、自身の環境に合わせて修正します。修正箇所は「- net type: o2ib10」と「- net type: tcp10」のブロック内の、nid のIP アドレスとinterfaces のデバイス名です。「ストレージネットワーク1」のインタフェースのデバイス名の確認方法は、仮想マシンにてターミナルを開き、「ip -br addr」コマンドを実行いただくことで確認可能です。上記コマンドの出力結果のうち、「ストレージネットワーク1」のIPアドレスが表示された行の1カラム目に出力している項目が、ネットワークインタフェース名になります。例:「Storage Network 1」のIPアドレスが「10.134.82.79/21」であった場合。以下の実行例では、「ens194」が「ストレージネットワーク1」のネットワークインタフェース名になります。

$ ip -br addr lo UNKNOWN 127.0.0.1/8 ::1/128 ens163 UP 10.aaa.bbb.ccc/21 2001:2f8:1041:223:9ba2:6ea9:3fd4:d289/64 fe80::d707:ca60:98a:cfb2/64 ens194 UP 10.134.82.79/21 fe80::698:e5e1:3574:f2e6/64

以下にIPアドレスが「10.134.82.79」、ネットワークインタフェース名が「ens194」の場合の変更例を記載します。

修正前:

- net type: o2ib10 local NI(s): - nid: 172.17.8.32@o2ib10 status: up interfaces: 0: enp59s0f0 - net type: tcp10 local NI(s): - nid: 172.17.8.32@tcp10 status: up interfaces: 0: enp59s0f0

修正後:

- net type: o2ib10 local NI(s): - nid: 10.134.82.79@o2ib10 status: up interfaces: 0: ens194 - net type: tcp10 local NI(s): - nid: 10.134.82.79@tcp10 status: up interfaces: 0: ens194

- /etc/sysconfig/lustre_clientetc/sysconfig/lustre_client を/etc/sysconfig/lustre_client に複写します。

- /etc/modprobe.d/lustre.confetc/modprobe.d/lustre.conf を/etc/modprobe.d/lustre.conf に複写します。

- /etc/init.d/lustre_clientetc/init.d/lustre_client を/etc/init.d/lustre_client に複写します。

- /usr/lib/systemd/system/lustre_client.serviceusr/lib/systemd/system/lustre_client.service を/usr/lib/systemd/system/lustre_client.service に複写します。

Lustreクライアントサービスの自動起動を設定し、仮想マシンを再起動します。

$ sudo systemctl enable lustre_client $ sudo reboot再起動後、/large と /fast がlustreストレージとしてマウントされます。

7.5.4. 仮想マシンテンプレートを使用しない場合 (ubuntu20.04)¶

- OFED ドライバのインストールMellanox 社のWeb からOFED ドライバのISO イメージ「MLNX_OFED_LINUX-5.8-5.1.1.2-ubuntu20.04-x86_64.iso」を入手します。ISO イメージをマウントし、インストールスクリプトを実行します。この際、インストールするモジュールの選択として「--guest(VM のゲストOS 用)」を指定します。

$ sudo mount -o ro,loop MLNX_OFED_LINUX-5.8-5.1.1.2-ubuntu20.04-x86_64.iso /mnt $ cd /mnt $ sudo ./mlnxofedinstall --guestOSに含まれるパッケージのうち、環境にインストールされていないものがある場合、OFEDのインストールに失敗することがあります。その場合は、OSのISOイメージからそれらのパッケージをインストールしてください。(インターネット公開された最新パッケージを適用しない)。 - Lustre Client ソース・設定ファイルひな形入手DDN 社が提供するLustre Client のソースプログラムファイル及びパッチファイルと、Lustre Client 用の各種設定ファイルのひな形をmdx 内からのみアクセス可能なWeb サーバから入手します。

lustre-2.12.9_ddn48.tar.gz

lustre-2.12.9_ddn48.ubuntu20.04.patch (lustreを ubuntu20.04でビルドするためのパッチ)

lustre_config_ubuntu_rdma.tgz(rdma を使用する場合)

lustre_config_ubuntu_tcp.tgz(tcp を使用する場合)

$ wget http://172.16.2.26/lustre-2.12.9_ddn48.tar.gz $ wget http://172.16.2.26/lustre-2.12.9_ddn48.ubuntu20.04.patch $ wget http://172.16.2.26/lustre_config_ubuntu_rdma.tgz $ wget http://172.16.2.26/lustre_config_ubuntu_tcp.tgz

- Lustre Client パッケージビルド入手したソースプログラムを展開し、パッケージの構築を行います。

# apt install libkeyutils-dev libmount-dev libyaml-dev zlib1g-dev module-assistant libreadline-dev libselinux1-dev libsnmp-dev mpi-default-dev libssl-dev # tar zxf lustre-2.12.9_ddn48.tar.gz # cd lustre-2.12.9_ddn48 # patch -p1 < ../lustre-2.12.9_ddn48.ubuntu20.04.patch # ./configure --with-linux=/usr/src/linux-headers-$(uname -r) --with-o2ib=/usr/src/ofa_kernel/default --disable-server --disable-lru-resize # make dkms-debs

これで再利用可能なdebパッケージが作成されます。

Lustre Client のインストール

注釈

既にインストールされているkernel moduleが存在する場合には、本手順実行前にremoveを行ってください。

# cd debs # apt install ./lustre-client-modules-dkms_2.12.9-ddn48-1_amd64.deb # apt install ./lustre-client-utils_2.12.9-ddn48-1_amd64.deb

- Lustre Client の設定入手した設定ファイルのひな形(lustre_config_ubuntu_*.tgz)を利用して、各種ファイルの修正・配備を行います。

- /etc/fstab/etc/fstab にLustre Filesystem のエントリを追加します。

SR-IOV を使用する場合は、以下の行をfstab に追加します。

172.17.8.40@o2ib10:172.17.8.41@o2ib10:/fast /fast lustre network=o2ib10,flock,noauto,defaults 0 0 172.17.8.56@o2ib10:172.17.8.57@o2ib10:/large /large lustre network=o2ib10,flock,noauto,defaults 0 0

通常の仮想NIC(VMXNET3)を使用する場合は、以下の行をfstab に追加します。

172.17.8.40@tcp10:172.17.8.41@tcp10:/fast /fast lustre network=tcp10,flock,noauto,defaults 0 0 172.17.8.56@tcp10:172.17.8.57@tcp10:/large /large lustre network=tcp10,flock,noauto,defaults 0 0

- /etc/lnet.conf.ddnetc/lnet.conf.ddn を/etc/lnet.conf.ddn に複写し、自身の環境に合わせて修正します。修正箇所は「- net type: o2ib10」と「- net type: tcp10」のブロック内の、nid のIP アドレスとinterfaces のデバイス名です。

「ストレージネットワーク1」のインタフェースのデバイス名の確認方法は、仮想マシンにてターミナルを開き、「ip -br addr」コマンドを実行いただくことで確認可能です。

上記コマンドの出力結果のうち、「ストレージネットワーク1」のIPアドレスが表示された行の1カラム目に出力している項目が、ネットワークインタフェース名になります。

例:「Storage Network 1」のIPアドレスが「10.134.82.79/21」であった場合。以下の実行例では、「ens194」が「ストレージネットワーク1」のネットワークインタフェース名になります。$ ip -br addr lo UNKNOWN 127.0.0.1/8 ::1/128 ens163 UP 10.aaa.bbb.ccc/21 2001:2f8:1041:223:9ba2:6ea9:3fd4:d289/64 fe80::d707:ca60:98a:cfb2/64 ens194 UP 10.134.82.79/21 fe80::698:e5e1:3574:f2e6/64

以下にIPアドレスが「10.134.82.79」、ネットワークインタフェース名が「ens194」の場合の変更例を記載します。

修正前:

- net type: o2ib10 local NI(s): - nid: 172.17.8.32@o2ib10 status: up interfaces: 0: enp59s0f0 - net type: tcp10 local NI(s): - nid: 172.17.8.32@tcp10 status: up interfaces: 0: enp59s0f0

修正後:

- net type: o2ib10 local NI(s): - nid: 10.134.82.79@o2ib10 status: up interfaces: 0: ens194 - net type: tcp10 local NI(s): - nid: 10.134.82.79@tcp10 status: up interfaces: 0: ens194

- /etc/sysconfig/lustre_clientetc/sysconfig/lustre_client を/etc/sysconfig/lustre_client に複写します。

- /etc/modprobe.d/lustre.confetc/modprobe.d/lustre.conf を/etc/modprobe.d/lustre.conf に複写します。

- /etc/init.d/lustre_clientetc/init.d/lustre_client を/etc/init.d/lustre_client に複写します。

- /usr/lib/systemd/system/lustre_client.serviceusr/lib/systemd/system/lustre_client.service を/usr/lib/systemd/system/lustre_client.service に複写します。

Lustreクライアントサービスの自動起動を設定し、仮想マシンを再起動します。

$ sudo systemctl enable lustre_client $ sudo reboot再起動後、/large と /fast がlustreストレージとしてマウントされます。

7.5.5. 仮想マシンテンプレートを使用しない場合 (ubuntu22.04, ubuntu24.04)¶

- OFED ドライバのインストールMellanox 社のWeb からOFED ドライバのISO イメージを入手します。OSごとに必要なファイル名は以下の通りです。

ubuntu22.04:MLNX_OFED_LINUX-5.8-7.0.6.1-ubuntu22.04-x86_64.iso

ubuntu24.04:MLNX_OFED_LINUX-24.10-3.2.5.0-ubuntu24.04-x86_64.iso

ISO イメージをマウントし、インストールスクリプトを実行します。この際、インストールするモジュールの選択として「--guest(VM のゲストOS 用)」を指定します。以下はubuntu22.04の場合のコマンドとなります。使用中のOSに合わせて指定するISOイメージのファイル名を変更してください。$ sudo mount -o ro,loop MLNX_OFED_LINUX-5.8-7.0.6.1-ubuntu22.04-x86_64.iso /mnt $ cd /mnt $ sudo ./mlnxofedinstall --guest - Lustre Client ソース・設定ファイルひな形入手DDN 社が提供するLustre Client のソースプログラムファイルと、Lustre Client 用の各種設定ファイルのひな形をmdx 内からのみアクセス可能なWeb サーバから入手します。

lustre-2.14.0_ddn198.tar.gz

lustre_config_ubuntu_rdma.tgz(rdma を使用する場合)

lustre_config_ubuntu_tcp.tgz(tcp を使用する場合)

$ wget http://172.16.2.26/lustre-2.14.0_ddn198.tar.gz $ wget http://172.16.2.26/lustre_config_ubuntu_rdma.tgz $ wget http://172.16.2.26/lustre_config_ubuntu_tcp.tgz

- Lustre Client パッケージビルド入手したソースプログラムを展開し、パッケージの構築を行います。

# apt install libkeyutils-dev libmount-dev libyaml-dev libjson-c-dev zlib1g-dev module-assistant libreadline-dev libssl-dev # tar zxf lustre-2.14.0_ddn198.tar.gz # cd lustre-2.14.0_ddn198 # LANG=C # sh autogen.sh # ./configure --with-o2ib=/usr/src/ofa_kernel/default --disable-server --disable-lru-resize # make dkms-debs

これで再利用可能なdebパッケージが作成されます。

Lustre Client のインストール

注釈

既にインストールされているkernel moduleが存在する場合には、本手順実行前にremoveを行ってください。

# cd debs # apt install ./lustre-client-modules-dkms_2.14.0-ddn198-1_amd64.deb ./lustre-client-utils_2.14.0-ddn198-1_amd64.deb

- Lustre Client の設定入手した設定ファイルのひな形(lustre_config_ubuntu_*.tgz)を利用して、各種ファイルの修正・配備を行います。

- /etc/fstab/etc/fstab にLustre Filesystem のエントリを追加します。

SR-IOV を使用する場合は、以下の行をfstab に追加します。

172.17.8.40@o2ib10:172.17.8.41@o2ib10:/fast /fast lustre network=o2ib10,flock,noauto,defaults 0 0 172.17.8.56@o2ib10:172.17.8.57@o2ib10:/large /large lustre network=o2ib10,flock,noauto,defaults 0 0

通常の仮想NIC(VMXNET3)を使用する場合は、以下の行をfstab に追加します。

172.17.8.40@tcp10:172.17.8.41@tcp10:/fast /fast lustre network=tcp10,flock,noauto,defaults 0 0 172.17.8.56@tcp10:172.17.8.57@tcp10:/large /large lustre network=tcp10,flock,noauto,defaults 0 0

- /etc/lnet.conf.ddnetc/lnet.conf.ddn を/etc/lnet.conf.ddn に複写し、自身の環境に合わせて修正します。修正箇所は「- net type: o2ib10」と「- net type: tcp10」のブロック内の、nid のIP アドレスとinterfaces のデバイス名です。

「ストレージネットワーク1」のインタフェースのデバイス名の確認方法は、仮想マシンにてターミナルを開き、「ip -br addr」コマンドを実行いただくことで確認可能です。

上記コマンドの出力結果のうち、「ストレージネットワーク1」のIPアドレスが表示された行の1カラム目に出力している項目が、ネットワークインタフェース名になります。

例:「Storage Network 1」のIPアドレスが「10.134.82.79/21」であった場合。以下の実行例では、「ens194」が「ストレージネットワーク1」のネットワークインタフェース名になります。$ ip -br addr lo UNKNOWN 127.0.0.1/8 ::1/128 ens163 UP 10.aaa.bbb.ccc/21 2001:2f8:1041:223:9ba2:6ea9:3fd4:d289/64 fe80::d707:ca60:98a:cfb2/64 ens194 UP 10.134.82.79/21 fe80::698:e5e1:3574:f2e6/64

以下にIPアドレスが「10.134.82.79」、ネットワークインタフェース名が「ens194」の場合の変更例を記載します。

修正前:

- net type: o2ib10 local NI(s): - nid: 172.17.8.32@o2ib10 status: up interfaces: 0: enp59s0f0 - net type: tcp10 local NI(s): - nid: 172.17.8.32@tcp10 status: up interfaces: 0: enp59s0f0

修正後:

- net type: o2ib10 local NI(s): - nid: 10.134.82.79@o2ib10 status: up interfaces: 0: ens194 - net type: tcp10 local NI(s): - nid: 10.134.82.79@tcp10 status: up interfaces: 0: ens194

- /etc/sysconfig/lustre_clientetc/sysconfig/lustre_client を/etc/sysconfig/lustre_client に複写します。

- /etc/modprobe.d/lustre.confetc/modprobe.d/lustre.conf を/etc/modprobe.d/lustre.conf に複写します。

- /etc/init.d/lustre_clientetc/init.d/lustre_client を/etc/init.d/lustre_client に複写します。

- /usr/lib/systemd/system/lustre_client.serviceusr/lib/systemd/system/lustre_client.service を/usr/lib/systemd/system/lustre_client.service に複写します。

Lustreクライアントサービスの自動起動を設定し、仮想マシンを再起動します。

$ sudo systemctl enable lustre_client $ sudo reboot再起動後、/large と /fast がlustreストレージとしてマウントされます。

7.5.6. 高速内部ストレージ、大容量ストレージの利用可能な容量を確認する¶

ユーザポータルで確認する

上部メニュー[ストレージ]→サイドメニュー[ストレージ]を選択した状態の画面で確認できます。高速内部ストレージ/大容量ストレージのハードリミットが利用可能な容量の上限です。仮想マシン上で確認する

プロジェクトID確認後に、プロジェクトIDとファイルシステムを指定してquota制限を確認します。- プロジェクトIDの確認以下の実行結果の1000XXXXの部分がプロジェクトIDです。高速内部ストレージ、大容量ストレージにファイルやディレクトリが一つも無い場合は確認できません。何か1つファイルを作成してください。

$ lfs project /large 1000XXXX P /large/mdx-user01 1000XXXX P /large/root

- quota制限の確認以下の例では、ファイルシステムに大容量ストレージ(/large)を指定しています。高速内部ストレージを確認する場合は、/fastを指定してください。usedが現在の使用量、limitが上限(ハードリミット)を表しています。quotaはソフトリミットを表していて、当システムでは利用していません。

$ lfs quota -h -p 1000XXXX /large Disk quotas for prj 1000XXXX (pid 1000XXXX): Filesystem used quota limit grace files quota limit grace /large 12k 0k 100G - 3 0 0 -

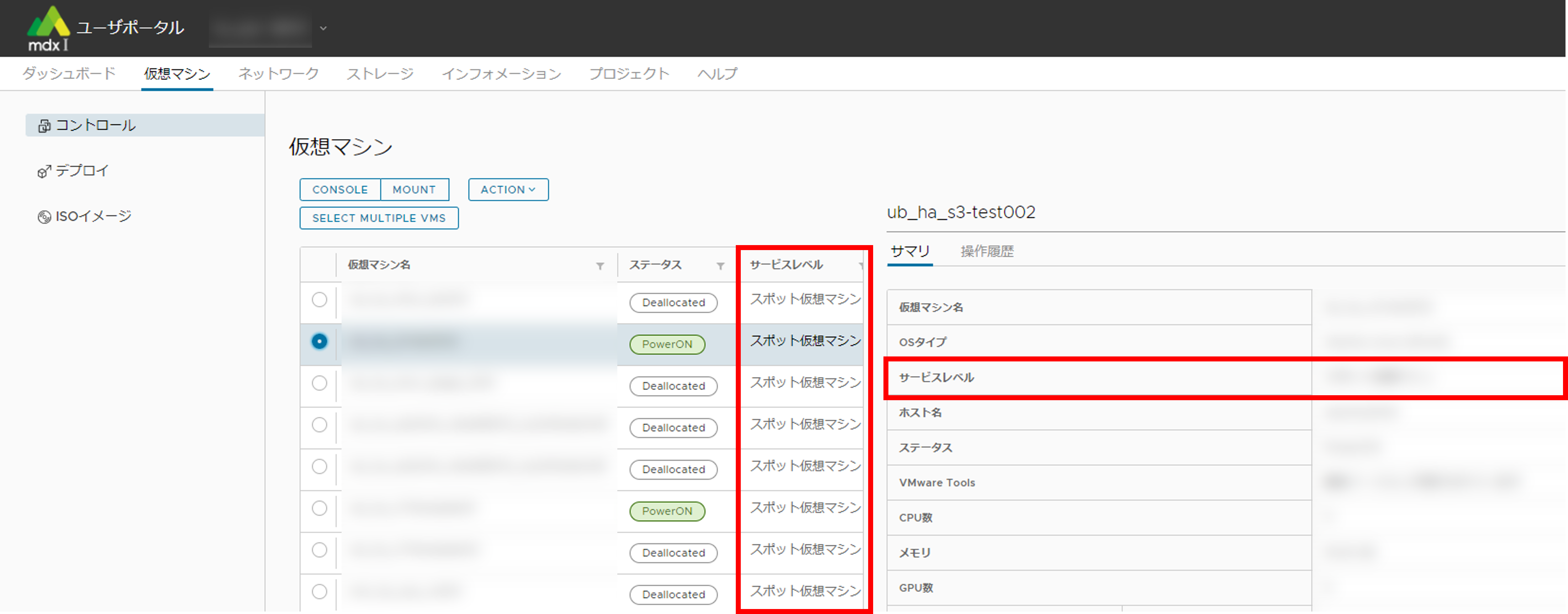

8. サービスレベル¶

本章では、仮想マシンをより効率的に利用することを目的としたサービスレベルに関する機能について説明します。

8.1. サービスレベルの種別¶

8.1.1. スポット仮想マシン¶

通常プロジェクトおよびお試しプロジェクトにて利用可能なサービスレベルです。

スポット仮想マシンはプロジェクトでCPUパック・GPUパックの資源を申請することなく利用することができます(ストレージ資源は申請が必要です)。

スポット仮想マシンが利用可能なCPUパック・GPUパックは、システム全体の資源量として定義した値を上限としています。

デプロイや電源投入時に空き資源が充足する場合は、即時に仮想マシンのデプロイや起動が実行されます。

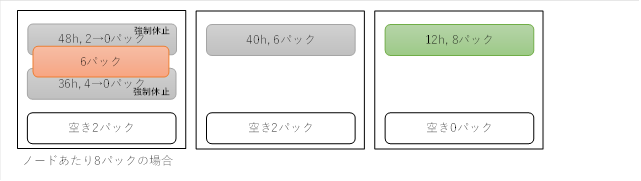

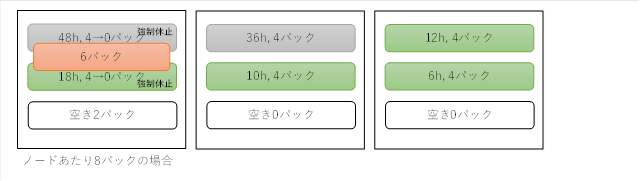

デプロイや電源投入時に空き資源が不足している場合は、既定の条件に該当する他のスポット仮想マシンを強制的に休止状態(ステータス「Deallocated」、PowerOffかつ計算資源を解放した状態)にし、解放された資源を割り当てて実行します。

ただし、他のスポット仮想マシンを休止状態にしてもデプロイ・起動に必要な資源が不足する場合、仮想マシンのデプロイ・起動に失敗します。なお、失敗したことは操作履歴で確認できます。

他のスポット仮想マシンが資源を必要とした場合、強制的に自身のスポット仮想マシンが休止状態に移行する場合があります。

起動保証仮想マシンが資源を必要とした場合、稼働時間に関わらず強制的に自身のスポット仮想マシンが休止状態に移行する場合があります。

- スポット仮想マシンが強制的に休止状態となる場合、プロジェクトユーザに対して事前に通知されるほか、ユーザポータルの仮想マシン一覧画面にて強制休止の対象であることが確認できます。強制休止のタイミングについては、 こちら をご確認ください。

- スポット仮想マシンが強制的に休止状態となった場合でも、ローカルディスク(仮想ディスク)およびストレージ(高速内部ストレージ/大容量ストレージ)に保存済みのデータは削除されることなく、仮想マシンを再起動後に以前と同じ環境で利用可能です。一方、強制停止時に実行中のプロセスが持つデータなどメモリ上にあり、ローカルディスクやストレージに保存されていないものは救済できないためご注意ください。

上記の強制的な休止状態への移行以外に、起動中のスポット仮想マシンが停止された場合も、その仮想マシンは休止状態に遷移します。

プロジェクトにCPUパック・GPUパックが割り当てられている場合は、「メンテナンス」メニューからサービスレベルを「起動保証仮想マシン」に変更することが可能です。

ただし、対象の仮想マシンが強制休止対象( 資源確保と強制休止のタイミング 参照)となった場合、「起動保証仮想マシン」へのサービスレベル変更はできません。

8.1.2. 起動保証仮想マシン¶

起動保証仮想マシンはプロジェクトに割り当てられたCPUおよびGPUの資源を利用して起動する仮想マシンです。

起動保証仮想マシンに割り当てられた資源の総量は、プロジェクトの割当量を超えることはできません。

プロジェクトに割り当てる資源量の総量は、機関に割り当てた上限を超えることはできません。但し、機関の割り当て量の総量は、システム全体の資源量を超えて定義ができます。

起動保証仮想マシンが利用可能な資源量の上限が設定でき、各プロジェクトの割当量の総量はシステム全体の上限以下で設定しなければならない(資源量の定義については後述する)。

起動保証仮想マシンの状態が電源投入状態でも、スポット仮想マシンへ変更することが可能です。

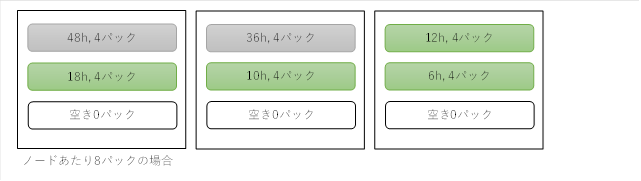

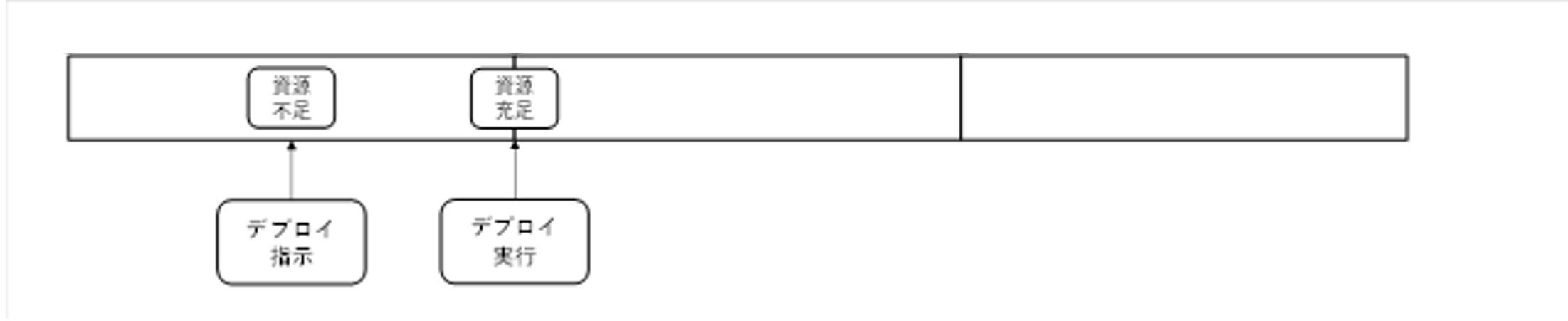

仮想マシンのデプロイや電源投入時に空き資源が充足する場合は、即時に仮想マシンのデプロイや起動が実行されます。

仮想マシンのデプロイや電源投入時に空き資源が不足する場合は、停止中や動作中の状態のスポット仮想マシンを強制休止状態へ遷移させ、解放された資源を使用して実行します。

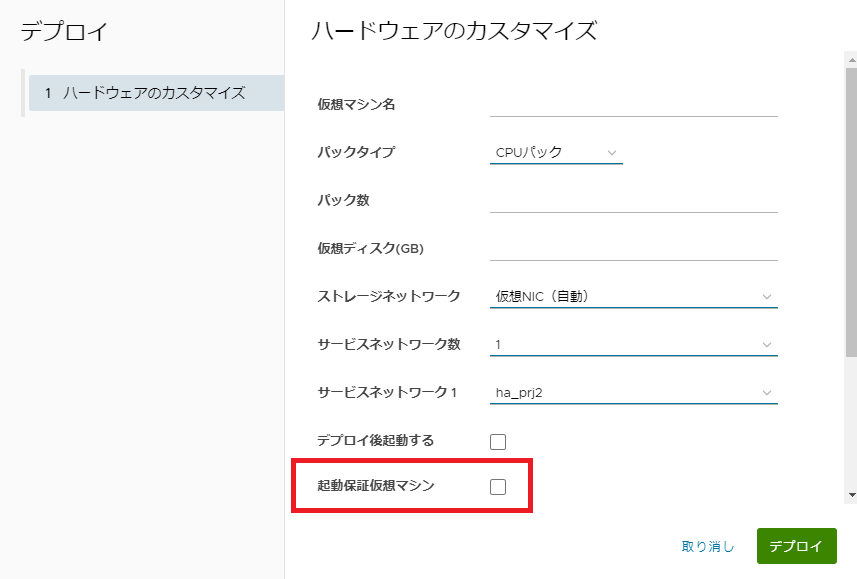

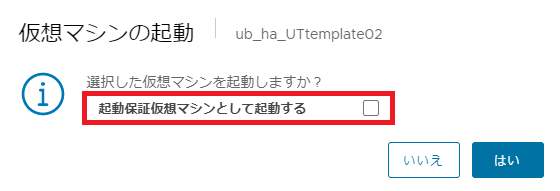

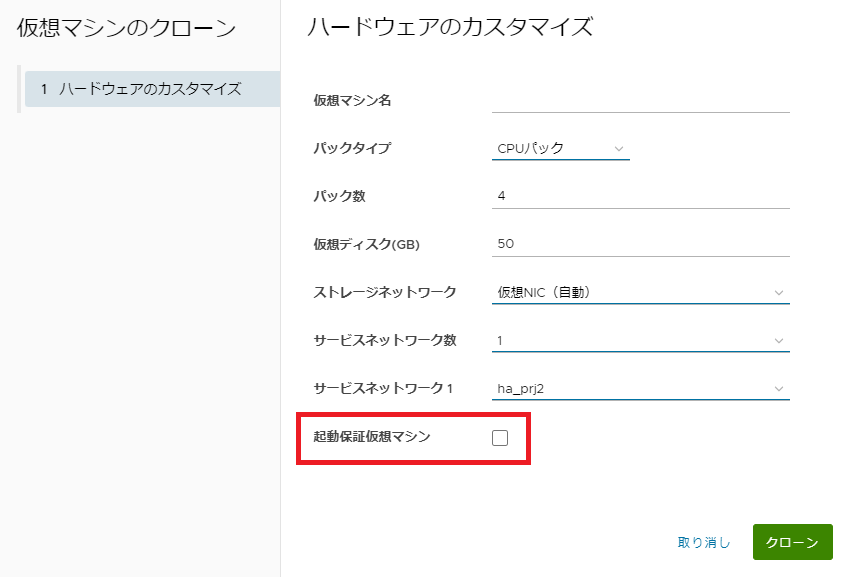

8.3. サービスレベルの指定方法¶

仮想マシンのサービスレベルの変更は、ユーザポータルから以下の操作を行うタイミングで指定可能です。

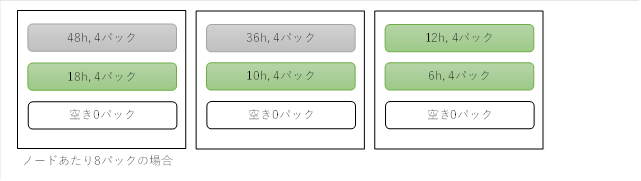

8.4. 資源利用イメージ¶

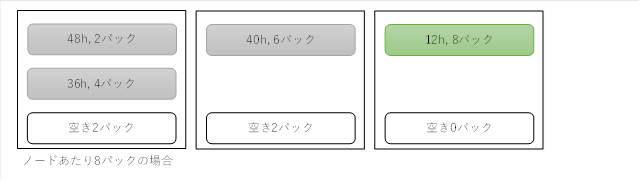

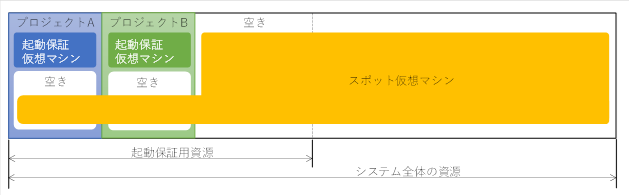

プロジェクトに未割り当ての起動保証用資源は、スポット仮想マシンが利用可能です。

プロジェクトに割り当てられている資源でも、未使用の場合はスポット仮想マシンが利用可能です。

起動保証仮想マシンはプロジェクトに割り当てられている範囲を超えての使用は不可となります。

8.4.1. スポット仮想マシンのデプロイまたは起動¶

(成功パターン)

※一定時間:24時間以上起動しているスポット仮想マシン

起動前

起動後

(失敗パターン)

8.4.2. 起動保証仮想マシンのデプロイまたは起動¶

8.5. 資源確保と強制休止のタイミング¶

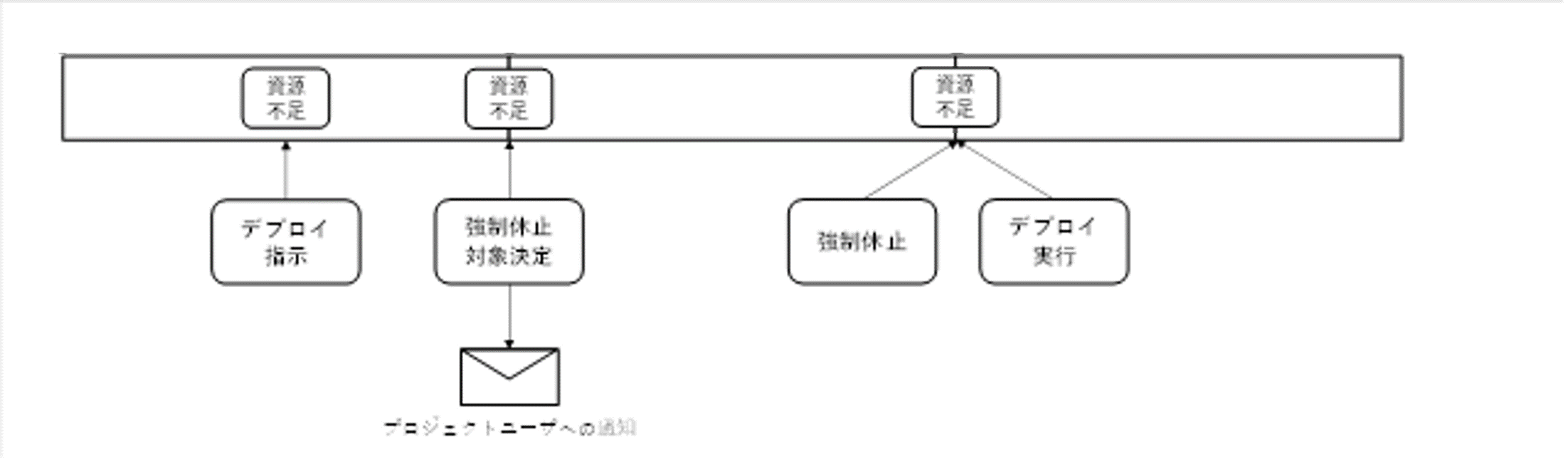

仮想マシンのデプロイ・起動時に実施されるスポット仮想マシンの強制休止処理は、一定周期で以下の順に行われます。

仮想マシンのデプロイ・起動を要求した際に必要な資源が不足(デプロイ・起動は保留状態となる)

1.操作後の周期処理のタイミング

当該仮想マシンに必要な資源が確保可能となった場合 ⇒ 資源を確保しデプロイ・起動する当該仮想マシンに必要な資源が不足していた場合 ⇒ 強制休止対象となる仮想マシンを決定、および事前通知さらに次の周期処理のタイミング

当該仮想マシンに必要な資源が確保可能となった場合 ⇒ 資源を確保しデプロイ・起動する(2.で予定された仮想マシンの強制休止は実施せず強制休止対象からも除外)当該仮想マシンに必要な資源が不足していた場合 ⇒ 2.で予定された仮想マシンを強制休止して資源を確保しデプロイ・起動する

また、強制休止対象となった仮想マシンはユーザポータルの仮想マシン一覧の画面で確認できます。

9. 資源再配分機能¶

本章では、仮想マシン用利用資源の有効的な利用を目的とする資源再配分機能について説明します。

9.1. 資源再配分機能の概要¶

起動保証仮想マシン用予約分の計算資源(以後、起動保証仮想マシン用資源)はプロジェクトに割り当てられ、割り当て範囲内で起動保証仮想マシンを作成することが可能です。

プロジェクトに割り当てた起動保証仮想マシン用の資源量の総計は、システム側で定義した起動保証仮想マシン用資源の上限を超えることはできません。

プロジェクトの資源申請が承認された際に要求資源量を確保できるかどうかは、起動保証仮想マシン用資源の空き状態によって異なります。

要求資源量が充足する場合は、要求資源量が割当資源量となります。

空き資源が無い(ゼロ)の場合は、割当資源量はゼロとなります。

要求資源量が不足の場合は、その時点の空き資源量が割当資源量となります。

各プロジェクトの要求資源量の総計が起動保証仮想マシン用資源量を超える場合、資源再配分機能により割り当て資源量の増減が行われます。

- 上記にかかわらず、通常プロジェクトではプロジェクトが保有するポイントの残高がゼロを下回りプロジェクトが停止した場合、もしくはプロジェクトが期間終了となった場合、そのプロジェクトの保有する起動保証仮想マシン用資源は全て解放されます(専有プロジェクトは対象外)。

プロジェクトの停止・期間終了による資源解放のタイミングで起動保証仮想マシンをデプロイしていた場合、自動でスポット仮想マシンに変更されます。

プロジェクト毎に最低資源量(Rmin)が定義されます。

各プロジェクトのRmin の総計は、起動保証仮想マシン用資源の上限を超えないよう管理されています。

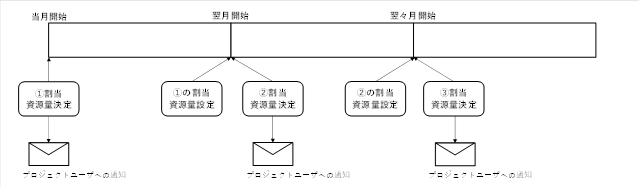

資源再配分処理は定期的に(毎月1日に)行われます。

資源再配分処理により割り当て資源量に変更がある場合は、各プロジェクトのプロジェクトユーザに対して新しい割り当て資源量の通知が行われます。

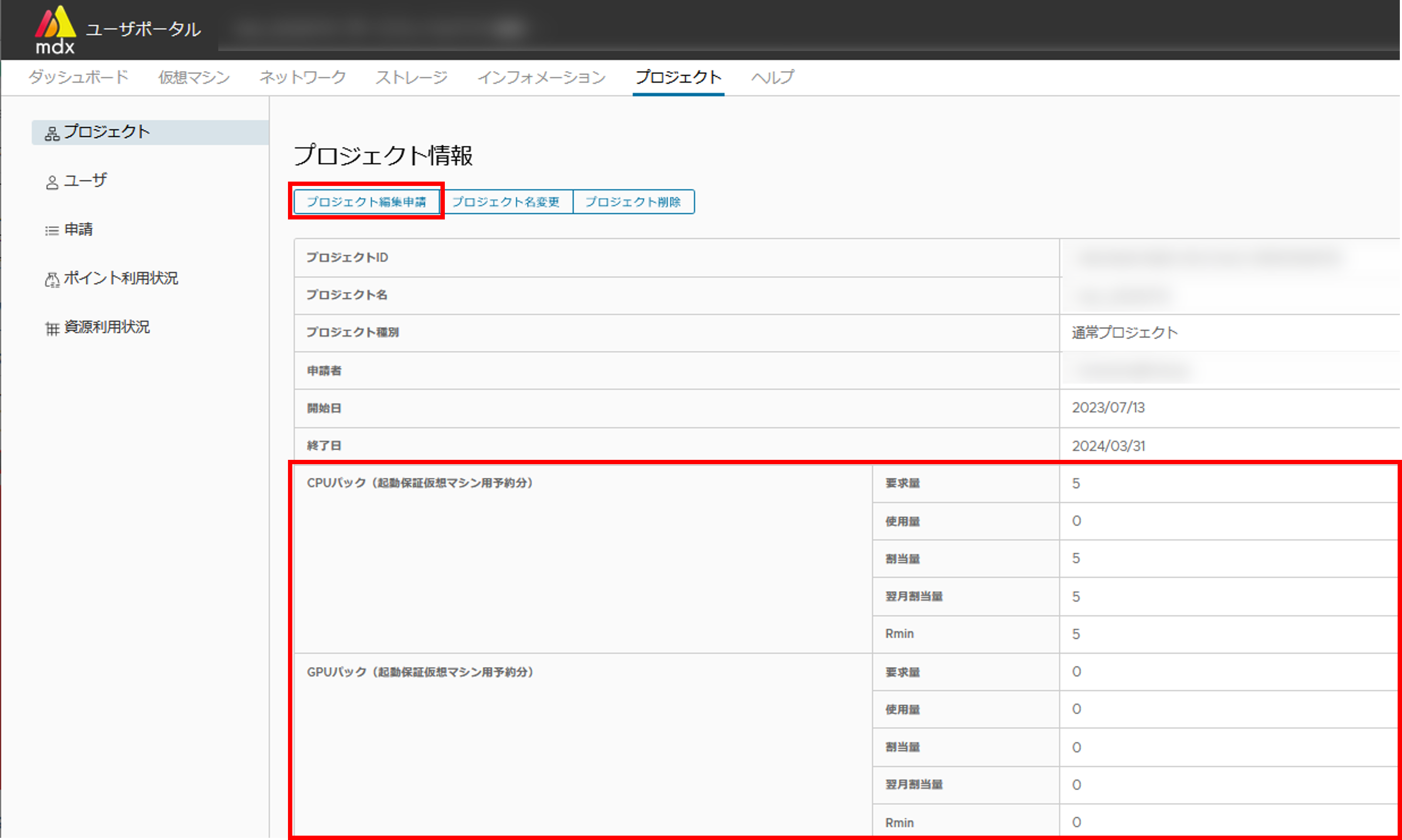

9.4. プロジェクト情報欄で表示している項目の説明¶

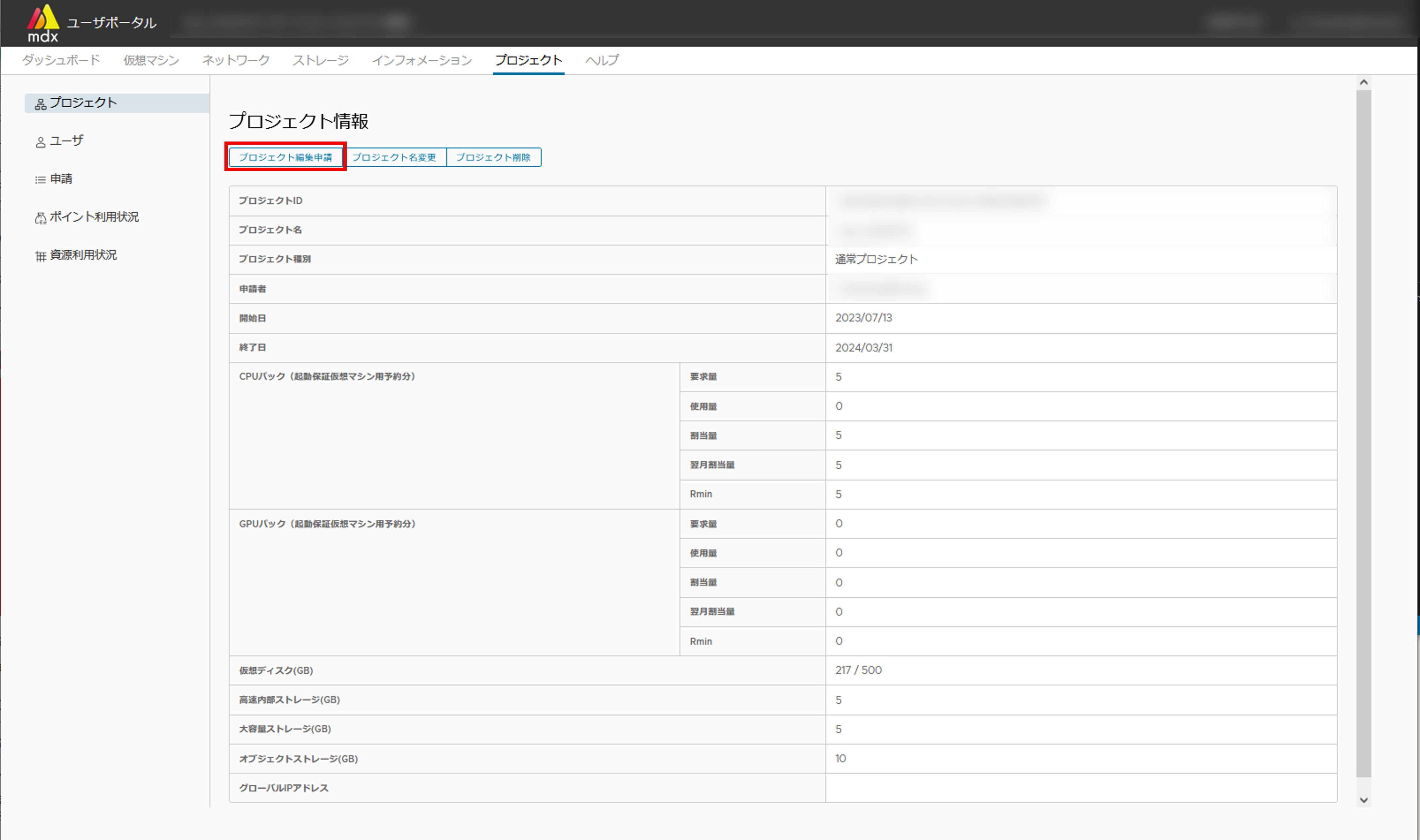

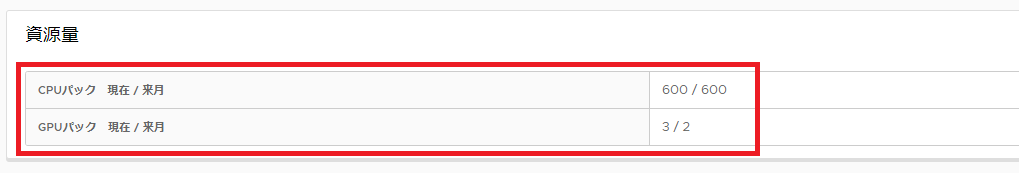

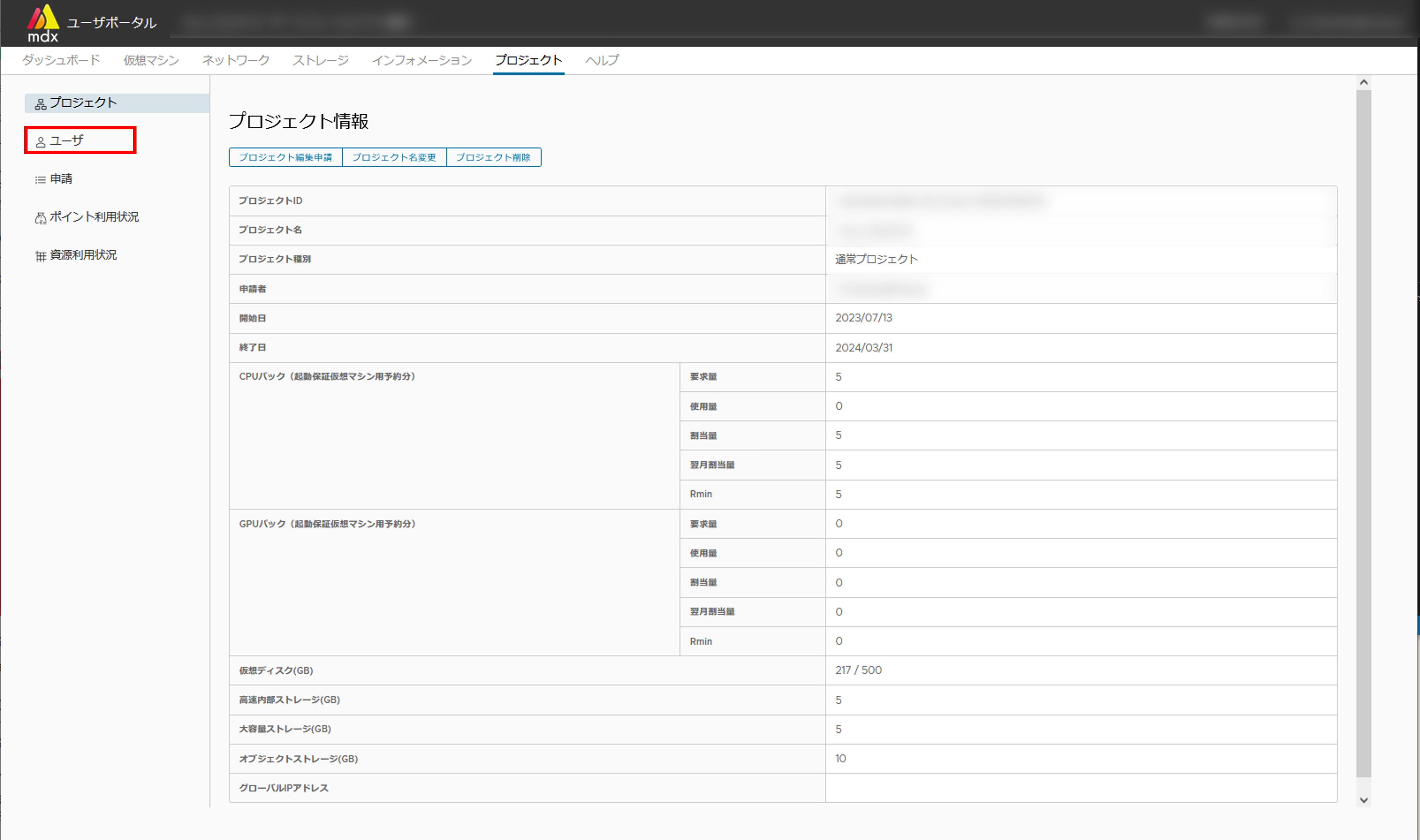

割当量についてユーザポータルの「プロジェクト」で確認できますが、各項目についての用語を説明します。

CPUパック、GPUパックそれぞれの項目について

項目 |

説明 |

|---|---|

要求量 |

プロジェクトが起動保証仮想マシン用として要求している資源量 |

使用量 |

プロジェクト内で起動保証仮想マシンが使用している資源量の総和 (電源 Off 含む) |

割当量 |

プロジェクトに起動保証仮想マシン用として割り当てられている資源量 |

翌月割当量 |

月初に行われる資源回収機能により通知された、来月の起動保証仮想マシン用の割り当て予定資源量 |

Rmin |

プロジェクトに割り当てられる起動保証仮想マシン用資源の下限値 |

10. 機能詳細¶

10.1. プロジェクト申請関連機能¶

この項では、mdxにおけるプロジェクトの申請方法およびその他プロジェクト申請ポータル上で利用可能なプロジェクト申請関連機能について説明します。

10.1.1. 申請状態ごとに可能な操作¶

申請状況/ Application Status |

利用できる操作 |

|---|---|

新規作成 |

申請、保存 |

未申請/ unapplied |

閲覧、申請、削除 |

申請中/ applied |

閲覧、取戻 |

却下/ reject |

閲覧、却下理由を確認し再申請、削除 |

承認済/ approved |

閲覧、複写、ユーザポータルの利用 |

10.1.2. プロジェクトの申請内容詳細¶

10.1.2.1. プロジェクトID¶

プロジェクトが承認された際に自動的に割り振られるIDです。未承認のプロジェクトの場合は表示されません。

10.1.2.2. プロジェクト名¶

作成するプロジェクトの名称です。最大50文字で、日本語の入力も可能です。

10.1.2.3. 利用目的¶

10.1.2.4. プロジェクトタイプ¶

プロジェクトタイプ |

物理ノード |

プロジェクトで利用できる資源 |

期間 |

|---|---|---|---|

通常 |

共有 |

プロジェクト作成後に申請 |

可変(申請) |

セキュア(ノード専有) |

専有 |

プロジェクト作成後に申請 |

可変(申請) |

お試し |

共有 |

一定の資源量に固定 |

3カ月 |

資源申請についての詳細は プロジェクト情報の確認と変更を行う をご確認ください。 また、お試しを選択した場合の資源量は以下となります。

資源名 |

資源量 |

|---|---|

CPUパック(起動保証仮想マシン用予約分) |

8 |

仮想ディスク |

100GB |

高速内部ストレージ |

10GB |

大容量ストレージ |

10GB |

グローバルIPアドレス数 |

1 |

10.1.2.5. 連携機関¶

申請するプロジェクトがどの機関に所属するかを選択します。なお、プロジェクトの承認処理は、所属機関の機関管理者によって行われます。

10.1.2.6. プロジェクト期間¶

10.1.2.7. プロジェクト申請者情報¶

プロジェクト申請者の方の姓名と所属、住所、連絡可能なメールアドレス、および電話番号を入力します。

姓名は最大50文字まで入力できます。

プロジェクトの新規申請時は、メールアドレス認証で利用したものがメールアドレスの初期値として表示されますが、必要に応じて変更できます。

10.1.2.8. プロジェクト代表者情報¶

代表者の方の姓名と所属、連絡可能なメールアドレスを入力します。

10.1.2.9. 事務(連絡)担当者情報¶

プロジェクトの事務連絡を受け取る担当者の方の姓名と所属、連絡可能なメールアドレスを入力します。

10.1.2.10. 通知¶

プロジェクトの利用者にメール通知を発行するかどうかを設定できます。対象は、下記の通りです。

プロジェクト申請者

プロジェクト代表者

事務(連絡)担当者

プロジェクトユーザ

メールによる通知は以下の契機で発行されます。

カテゴリ |

通知のタイミング |

|---|---|

プロジェクト作成・編集申請に関する通知 |

・申請時

・承認/却下時

|

ポイントの購入に関する通知 |

・購入申請時

・購入申請承認/却下時

・クレジットカード決済時

・支払方法編集申請時

・支払方法編集申請承認/却下時

・購入取消時

・管理者による購入取消時

|

ポイントに関する通知 |

・ポイント残量が5000を下回った時

・ポイント残量が0を下回った時

・ポイント有効期限が1カ月前になった時

・管理者による利用停止時

・利用停止状態の解除時

|

プロジェクトの利用に関する通知 |

・お知らせ更新時

・プロジェクト期間終了1カ月前

・プロジェクト期間終了2週間前

・プロジェクト期間終了3日前

・ポイント残量が0を下回ってから83日経過時

(ポイント残量が0を下回ってから90日でプロジェクトは自動削除)

|

資源の回収に関する通知 |

・スポット仮想マシン停止の1時間前

・起動保証用資源回収の1か月前

|

10.1.2.11. ユーザコミュニティ¶

ユーザコミュニティ(Slack)の参加の可否を設定できます。

10.1.2.12. ポイント購入を許可するユーザの追加(任意)¶

プロジェクト申請者本人以外にポイントを購入可能なユーザを設定できます。複数人を指定する場合は、”半角スペース”でユーザIDの間を区切って入力します。

10.1.2.13. 居住国に関する確認事項¶

日本の居住者ではない場合は以下の項目について追加で記載・報告する必要があります。

所属機関

所属機関所在国

身分

国籍

主たる居住地

10.1.2.14. 輸出規制に関する質問事項¶

申請者が外国政府等との雇用に関する契約を結んでいるか、外国政府等から経済的利益を受けているかについて確認します。

10.1.2.15. 利用規約および利用目的に関する同意事項¶

10.1.3. 新規のプロジェクトを申請する¶

申請リストの画面左上にある[プロジェクトの申請/ Project Application]をクリックします。

プロジェクト申請に必要な項目を入力します。

[必須/ required]と記載のある項目は申請時には必ず入力する必要があります。

[詳細/ detail]をクリックすると項目ごとの説明を参照できます。

入力が完了したら、プロジェクト申請を行う場合は画面スクロールして最下部にある[申請/ Apply]を、プロジェクト情報を一時保存する場合には[保存/ Save]をクリックします。

プロジェクト申請一覧画面に戻ると、作成したプロジェクトが申請中の場合には[申請中/ applied]、一時保存した場合には[未申請/ unapplied]で表示されます。以上でプロジェクト申請の作成処理は完了です。

注釈

プロジェクトを一時保存する場合にはプロジェクト名のみ入力が必須となります。

10.1.4. 一時保存したプロジェクトを申請する¶

未申請状態となっているプロジェクトを申請します。

申請リスト画面で対象とするプロジェクトのアクションから[申請/ Apply]をクリックします。

必要に応じて任意の項目の情報を修正します。

修正が完了したら、プロジェクト申請を行う場合は画面スクロールして最下部にある[申請/ Apply]を、再度プロジェクト情報を一時保存する場合には[保存/ Save]をクリックします。

プロジェクト申請一覧画面に戻ると、作成したプロジェクトが申請中の場合には[申請中/ applied]、一時保存した場合には[未申請/ unapplied]で表示されます。以上で申請処理は完了です。

10.1.5. プロジェクトの申請内容を削除する¶

未申請もしくは却下された状態のプロジェクトを削除します。

申請リスト画面で対象とするプロジェクトのアクションから[削除/ Delete]をクリックします。

表示された内容に問題がなければ画面スクロールして最下部にある[削除/ Delete]をクリックします。

プロジェクト申請一覧画面に戻り削除したプロジェクトが表示されていないことを確認します。以上で削除処理は完了です。

10.1.6. プロジェクト申請を取り下げる¶

申請状態のプロジェクトの申請を取り下げます。

申請リスト画面で対象とするプロジェクトのアクションから[取戻/ Cancel]をクリックします。

表示された内容に問題がなければ画面スクロールして最下部にある[取戻/ Cancel]をクリックします。

プロジェクト申請一覧画面に戻り取戻処理を行ったプロジェクトが[未申請/ unapplied]状態になっていることを確認します。以上で取戻処理は完了です。

10.1.7. プロジェクトを却下された理由を確認し再申請を行う¶

申請リスト画面で対象とするプロジェクトのアクションから[却下理由を確認し再申請/ Confirm Reject Reason and Reapply]をクリックします。

画面の最上部に却下理由が赤文字で表示されます。

(再申請を行う場合)

再申請を行う場合には却下理由に沿って現在の画面で任意の項目の情報を修正します。

修正が完了したら、再申請を行う場合は画面スクロールして最下部にある[再申請/ Reapply]を、プロジェクト情報を一時保存する場合には[保存/ Save]をクリックします。

プロジェクト申請一覧画面に戻ると、作成したプロジェクトが申請中の場合には[申請中/ applied]、一時保存した場合には[未申請/ unapplied]で表示されます。以上で再申請処理は完了です。

10.1.8. プロジェクトの申請内容を複写する¶

承認済みのプロジェクトを同じ入力情報で別のプロジェクトとして申請もしくは保存します。

申請リスト画面で対象とするプロジェクトのアクションから[複写/ Copy]をクリックします。

任意の項目の情報を修正します。

修正が完了したら、そのままプロジェクト申請を行う場合は画面スクロールして最下部にある[申請/ Apply]を、プロジェクト情報を一時保存する場合には[保存/ Save]をクリックします。

プロジェクト申請一覧画面に戻ると、作成したプロジェクトが申請中の場合には[申請中/ applied]、一時保存した場合には[未申請/ unapplied]で表示されます。以上で複写処理は完了です。

10.1.9. ユーザポータルへ移動してmdxの機能を利用する¶

10.1.10. プロジェクト申請の内容を確認する¶

プロジェクト申請の内容を確認します。一時保存もしくは一度でも申請を行ったプロジェクト申請が対象です。

申請リスト画面で対象とするプロジェクトのアクションから[閲覧/ Browse]をクリックします。

対象のプロジェクト申請の内容が表示されます。

確認できたら、画面をスクロールして最下部にある[一覧に戻る/ Return list]をクリックすると申請リスト画面に戻ります。

10.2. ポイント購入申請関連機能¶

mdxのポイント制度については 利用料金制度のページ をご確認ください。

10.2.1. プロジェクトのポイントの保有状況を確認する¶

今年度残ポイント数:今年度に利用できるポイントの合計を表示します。

「○○○ reserved」表記のポイントは、プロジェクト期間の開始前などまだ利用開始していないポイントです。

次年度残ポイント数:次年度用に予約購入したポイントの合計を表示します。

なお、ポイントの購入単位で残量を確認したい場合は ユーザポータルのポイント利用状況 から確認できます。

10.2.2. ポイント購入申請内容詳細¶

10.2.2.1. ポイント購入者情報¶

ポイント購入者の情報を入力します。以下の情報は必須入力です。

姓名

所属機関

所属部署

職名

メールアドレス

電話番号

以下の情報は任意入力です。

郵便番号

住所

10.2.2.2. 支払事務担当者情報¶

支払事務担当者の情報を入力する場合は、以下の情報は必須入力です。

姓名

所属機関

所属部署

職名

メールアドレス

電話番号

以下の情報は任意入力です。

郵便番号

住所

10.2.2.3. 必要ポイント数の申請¶

10.2.2.4. お支払方法¶

学認IDでログインかつ 所属が東京大学以外の場合

mdx認証基盤IDでログインしている場合

10.2.2.5. 支払予算¶

ポイント購入者が学認IDでログインかつ 所属が東京大学の場合に選択可能です。科研費、科研費以外 の2種類から選択します。

10.2.2.6. 支払に関する詳細情報¶

ポイント購入者・支払方法により、設定項目が異なります。

学認IDでログインかつ 所属が東京大学以外 or mdx認証基盤IDでログインしている場合

請求書払いの場合、設定項目は下記の通りです。なお、過去に請求書払いによりポイントを購入していた場合、過去に申請した請求先を選択して申請することが可能です。請求書の宛名

請求書送付先

姓名

所属機関

所属部署

職名

郵便番号

住所

電話番号

クレジットカード払いを選択した場合、設定項目はありません。

ポイント購入者が学認IDでログインかつ 所属が東京大学の場合

設定項目は下記の通りです。

予算責任者

部局名

部署コード(10桁)

プロジェクトコード(12桁) / 予算科目(6桁)

10.2.3. 新規のポイント購入を申請する¶

新規のポイント購入申請を行います。

ポイント購入可能なプロジェクトが表示されている画面で、対象とするプロジェクトのアクションから [購入する/ Purchase]をクリックします。

ポイント購入申請に必要な項目を入力します。

[必須/ required]と記載のある項目は必ず入力してください。

ポイント購入申請の入力項目の詳細は ポイント購入申請内容詳細 を参照してください。

入力が完了したら申請画面最下部の左にある[申請内容を確認する/ Confirm the application]をクリックします。

もし、入力内容に不備がある場合は申請ボタンの上に申請ボタンの上にエラーメッセージが表示されます。

不備がある項目名が赤色で表示されますので、修正のうえ再度[申請内容を確認する/ Confirm the application]をクリックしてください。

ポイント購入申請の内容を確認して、問題が無ければ[ポイントの購入を申請する / Apply to purchase points]をクリックしてください。

入力内容を一時的に保存したい場合には、[入力内容を一時保存する / Save as draft]をクリックします。一時保存したポイント購入申請を使用する場合には、 復元の操作 を参照してください。

ポイント購入申請を辞める場合には、[プロジェクト一覧に戻る/ Return project list]をクリックすることでポイント購入画面に戻ることができます。

ポイント購入履歴画面にて、申請したポイント購入申請のステータスが[申請中/ Applied]で表示されます。以上でポイント購入申請処理は完了です。

10.2.4. ポイント購入を許可するユーザを操作する¶

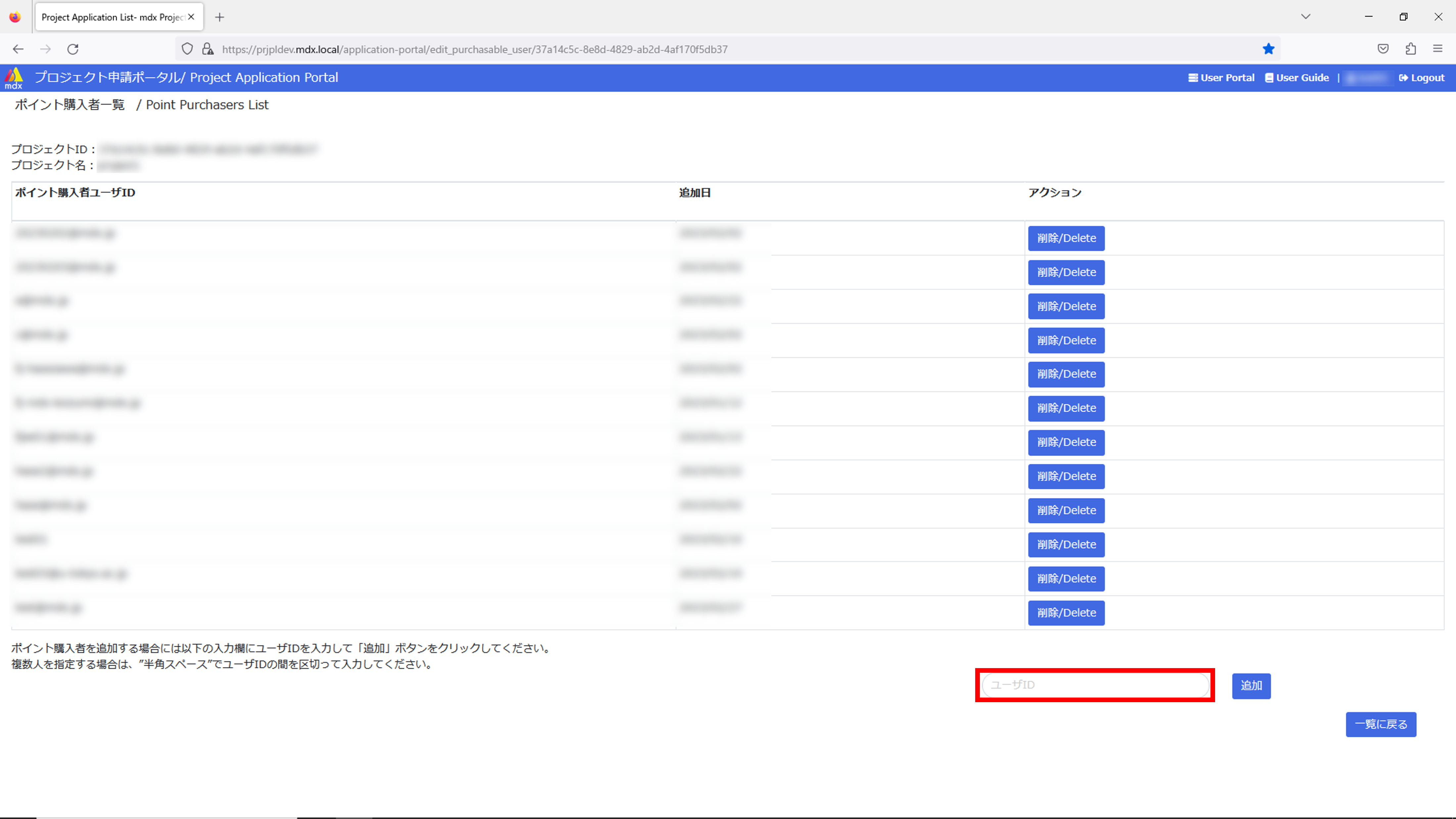

10.2.4.1. ポイント購入を許可するユーザの追加¶

プロジェクトの申請者が、プロジェクトのポイント購入を許可するユーザを追加します。

ポイント購入可能なプロジェクトが表示されている画面で、対象とするプロジェクトのアクションから[ポイント購入者を確認する/ Verify purchasers]をクリックします。

ポイント購入者一覧画面にポイント購入可能なユーザのリストが表示されます。

- リストの下部にある入力欄にポイントを購入可能なユーザのユーザIDを入力します。複数人を指定する場合は、”半角スペース”でユーザIDの間を区切って入力してください。

入力欄の右にある[追加/ Add]をクリックします。

ポイント購入可能なユーザのリストが更新され、入力したユーザが追加されていることを確認します。以上でポイント購入可能なユーザを追加する処理は完了です。

10.2.4.2. ポイント購入を許可するユーザの削除¶

追加時同様にポイント購入者一覧画面に遷移します。

削除したいユーザの右にある[削除/ Delete]をクリックします。

ポイント購入可能なユーザのリストが更新され、削除したユーザが消えていることを確認します。以上でポイント購入可能なユーザを削除する処理は完了です。

10.2.5. 一時保存したポイント購入申請を復元して申請する¶

一時保存した未申請のポイント購入申請を復元して申請します。

ポイント購入履歴画面で対象とするポイント購入申請のアクションから[申請/ Apply]をクリックします。

[入力内容を一時保存する/ Save as draft]をクリックする前のポイント購入申請が復元されるため、必要事項を入力して、[申請内容を確認する/ Confirm the application] をクリックします。

ポイント購入申請の内容を確認して、問題が無ければ[ポイントの購入を申請する/ Apply to purchase points]をクリックしてください。

ポイント購入履歴画面にて、申請したポイント購入申請のステータスが[申請中/ Applied]で表示されます。以上で一時保存したポイント購入申請を復元して申請する処理は完了です

10.2.6. ポイント購入申請を取り下げる¶

申請中のポイント購入申請を取り下げます。

ポイント購入履歴画面で対象とするポイント購入申請のアクションから[取消/ Cancel]をクリックします。

表示された内容に問題がなければ画面スクロールして最下部にある[ポイント購入を取り消す/ Cancel point purchase]をクリックします。

ポイント購入履歴画面に戻り、取り下げたポイント購入申請のステータスが[未申請/ Unapplied]で表示されていることを確認します。以上で取り下げ処理は完了です。

10.2.7. 却下されたポイント購入申請を再申請する¶

却下されたポイント購入申請を再申請します。

ポイント購入履歴画面で対象とするポイント購入申請のアクションから[再申請/ Re-apply]をクリックします。

申請画面上方・ポイント基本情報内の[却下理由/ Reject reason]を確認し、ポイント購入申請の内容に原因があれば修正します。

ポイント購入申請の内容を確認して、問題が無ければ[ポイントの購入を申請する / Apply to purchase points]をクリックしてください。

ポイント購入履歴画面にて、申請したポイント購入申請のステータスが[申請中/ Applied]で表示されます。以上で却下されたポイント購入申請を再申請する処理は完了です。

10.2.8. ポイント購入申請の支払い方法の変更を申請する¶

ポイント購入履歴画面で対象とするポイント購入申請のアクションから[支払方法編集/ Edit payment method]をクリックします。

[お支払方法/ Payment method]以下の項目について編集したい内容を入力します。

[編集内容を申請する/ Request edits edits] をクリックします。以上でポイント購入申請の支払い方法編集申請処理は完了です。

支払い方法の編集申請が承認もしくは却下されるまでは[支払方法編集/ Edit payment method]の画面で申請内容を修正することはできませんのでご注意ください。

10.2.9. ポイント購入申請の決済処理を行う(クレジットカード決済のみ)¶

支払い方法がクレジットカード払いかつ承認済のポイント購入申請の決済処理を行います。

ポイント購入履歴画面で対象とするポイント購入申請のアクションから[決済情報入力/ Enter payment info]をクリックします。

ポイント決済画面に遷移するため、ご利用内容を確認して、問題が無ければ、クレジットカード決済申し込みフォームに必要情報を入力します。

入力画面の下部の[お申し込み内容確認]をクリックします。

10.2.10. ポイント購入申請を取り消す¶

取り消したポイントは二度と利用することはできず請求も行われません。

ポイント購入履歴画面で対象とするポイント購入申請のアクションから[取消/ Cancel]をクリックします。

表示された内容に問題がなければ画面スクロールして最下部にある[ポイント購入を取り消す/ Cancel point purchase]をクリックします。

ポイント購入履歴画面に戻り、取り消ししたポイント購入申請が表示されていないことを確認します。以上でポイント購入申請を取り消す処理は完了です。

10.2.11. ポイント購入申請の内容を複製する¶

承認済のポイント購入申請を複製します。

ポイント購入履歴画面で対象とするポイント購入申請のアクションから[複製/ Copy]をクリックします。

[ポイントの購入/ Buy Points]画面の入力項目に初期値として、複製したポイント購入申請の情報が入力されます。以上でポイント購入申請の内容を複製する処理は完了です。

10.2.12. ポイントの詳細情報を確認する¶

ポイント基本情報

ポイント管理番号:ポイント購入申請が作成された際に自動的に割り振られる固有の番号。

承認状態:現在のポイント購入申請の状態。

申請中:ポイント購入申請が申請されており、まだ承認も却下もされていない状態。

承認:ポイント購入申請が承認された状態。

却下:ポイント購入申請が却下された状態。却下理由をポイント基本情報にて確認可能。

未申請:まだ申請しておらず一時保存されている状態。

ポイント状態:現在のポイントの状態。

有効:承認済み、支払方法がクレジットカード払いの場合は決済まで完了した状態。

停止:未承認、またはクレジットカード払いを選択かつ未決済の状態。または有効化されたポイントが管理者により一時利用停止された状態。

取消:有効化されたポイントが取り消された状態。取消後はポイントとして利用ができず、請求も行われない。… 取消に関する詳細

以下は「承認状態」が「承認」の場合のみ表示されます。

ポイント付与日:ポイントが承認された日付、支払方法がクレジットカード払いの場合は決済を完了した日付。

ポイント利用開始日:ポイントの利用開始日付。次年度分のポイントを購入した場合などは未来の日付となる。

ポイント有効期限:ポイントが利用可能である期間の最終日。期限が過ぎたポイントは利用できない。

ポイント購入金額(税込):本ポイント購入により請求される金額を税込みで表示。

請求月:請求が行われる年と月。

以下は「承認状態」が「却下」の場合のみ表示されます。

却下理由:購入申請が却下された理由を表示。

プロジェクト基本情報

各項目の詳細は プロジェクトの申請内容詳細 をご確認ください。

プロジェクト名

プロジェクトID

連携機関

プロジェクト期間

申請者氏名

申請者メールアドレス

代表者氏名

代表者メールアドレス

10.3. 仮想マシンの作成に関する機能¶

10.3.1. デプロイ¶

テンプレートから新規に仮想マシンを作成(デプロイ)します。

テンプレートにはOSなどあらかじめ様々な設定が入った仮想マシンテンプレートとOS設定のないテンプレートがあります。

自身のISOイメージから仮想マシンを作成する場合にはOS設定のないテンプレートをご利用ください。

以下からデプロイの手順について説明します。

利用したいテンプレートを選択して[デプロイ]をクリックします。

各設定項目を入力もしくは選択します。

仮想マシンテンプレートの場合にはハードウェアカスタマイズ画面の設定のみ行います。

ISOイメージから新規仮想マシンを作成するためのテンプレートの場合はゲストOSの選択画面の設定を追加で行います。

<仮想マシンテンプレートの場合>

<OS設定のないテンプレートの場合>

入力が完了したら[デプロイ]をクリックします。以上で仮想マシンの作成は完了です。

10.3.1.1. デプロイ時の設定項目¶

ハードウェアのカスタマイズ

項目 |

説明 |

|---|---|

仮想マシン名 |

作成する仮想マシンの名前を最大80 文字の英数字で指定する。

複数の仮想マシンを同時にデプロイしたい場合には仮想マシン名[(開始番号)-(終了番号)]という書き方が可能。

指定する開始番号と終了番号は桁数を揃える必要があり、開始番号の桁が少ない場合は上位桁を「0」で埋めること。

例) machine[0-3] と指定すると、名前以外のカスタマイズが同じ machine0, machine1,..., machine3 の4台

machine[00-10] と指定すると、名前以外のカスタマイズが同じ machine00, machine01,..., machine10 の11台 がデプロイされる

また、カンマ(,)区切りで複数の仮想マシン名を記載での書き方も可能。

例) machine0,machine1 と指定すると、machine0, machine1 の2台がデプロイされる。

上記2つを組み合わせた書き方も可能。

例) machine[0-1],machine2,machine3 と指定すると、machine0, machine1,machine2,machine3 の4台がデプロイされる。

【使用可能な文字種】

・英大文字(A-Z)

・英小文字(a-z)

・数字(0-9)

・記号:( ) + - . = ^ _ { } ~

なお、複数デプロイの場合において、以下の記号も許可する。

・カンマ(,)は、区切り文字のみ

・[ ]は、範囲指定のみ

|

パックタイプ |

通常・お試しプロジェクト時のみ。構築する仮想マシンがGPU を使用しない場合は「CPU パック」を、GPU を使用する場合は「GPUパック」を選択する。 |

パック数 |

通常・お試しプロジェクト時のみ。仮想マシンに割り当てるCPUパックもしくはGPUパックの数を指定する。※

ただし、ひとつの物理ノードの資源量(CPU,メモリ)を超える仮想マシンは構成できない。

(CPUパックは最大で152パック、GPUパックは最大で8パックまで指定することが可能)

|

CPU数 |

セキュアプロジェクト時のみ。仮想マシンに割り当てるCPU数を指定する。(最大で152まで指定可) |

メモリ(GB) |

セキュアプロジェクト時のみ。仮想マシンに割り当てるメモリの容量を指定する。

(物理的な最大量は汎用ノードで256GB、演算加速ノードで512GBだが、GPU利用時やストレージネットワークに

「SR-IOV」を選択した場合はメモリ予約が行われるため、指定できるメモリの最大量が減少する)

|

GPU数 |

セキュアプロジェクト時のみ。仮想マシンに割り当てるGPU数を指定する。(最大で8まで指定可) |

仮想ディスク(GB) |

OS が格納されるハードディスクの容量を指定する。minimal install でも20GB 程度は必要であり、追加インストール するアプリケーションが使用する容量を加味して大きさを見積もる。 |

ストレージネットワーク |

ストレージネットワークとして「仮想NIC(自動)」、「仮想NIC(E1000)」、「PVRDMA」、「SR-IOV」の中から使用する種別を選択。

Lustre を使用する場合、「仮想NIC(自動)」または「SR-IOV」を選択、更にLustre をRDMA で使用する場合は「SR-IOV」を選択する。

|

サービスネットワーク数 |

構築する仮想マシンに、いくつのサービスネットワークを接続するかを選択する。単体システムの場合は1で良い。 |

サービスネットワーク1, 2, ..., n |

利用するサービスネットワーク名を指定する。サービスネットワークは上部メニューネットワークのセグメントから

追加できる(プロジェクトの初期設定としてプロジェクト名と同じ名前のセグメントが用意される)。

サービスネットワーク数で選択した数と同数のサービスネットワークの項目を表示・指定できる。

|

デプロイ後起動する |

設定中の仮想マシンのデプロイ後にすぐにマシンを起動したい場合にチェックを入れる。 |

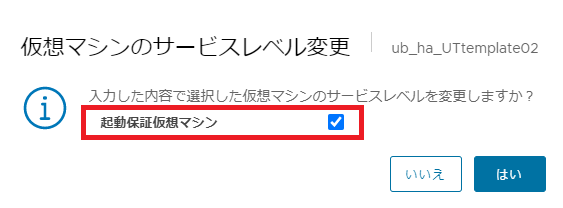

起動保証仮想マシン |

通常・お試しプロジェクト時のみ。設定中の仮想マシンを起動保証仮想マシンとして取り扱う場合にチェックを入れる。 |

ログインユーザ名 |

公開鍵が設定されるユーザ名が表示される。 |

公開鍵 |

ssh でログインするための公開鍵を指定する。 |

※1パックにつき割り当てられる資源量は CPUパック・GPUパックについて を参照ください。

ゲストOSの選択

項目 |

説明 |

|---|---|

ゲストOSファミリ |

新規仮想マシンでインストールするOSのファミリをWindows/Linux/その他から選択する |

ゲストOSバージョン |

新規仮想マシンにインストールするOSの種別・バージョンをリストから選択する |

10.4. 仮想マシンの制御に関する機能¶

ステータス名 |

説明 |

|---|---|

PowerON |

仮想マシンの電源がONである状態。 |

PowerOFF |

仮想マシンの電源がOFFである状態。 |

Deploying |

仮想マシンのデプロイが進行している状態。 |

Deallocated |

休止状態。仮想マシンの電源がOFFであることに加え計算資源(CPU・GPU)を解放した状態。 |

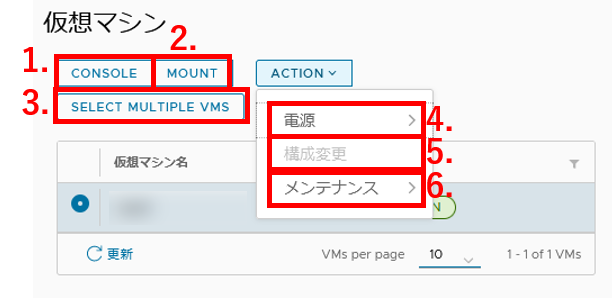

リストで指定した仮想マシンに対してコントロール画面の各種機能を利用することができます。

CONSOLE:仮想マシンの起動状態をコンソールで確認します。

OSのインストールを行う場合もコンソールから操作を行います。

MOUNT:仮想マシンにISOイメージのマウントを行います。

マウントに利用するISOイメージは ISOイメージのアップロード画面 から事前にアップロードしておく必要があります。

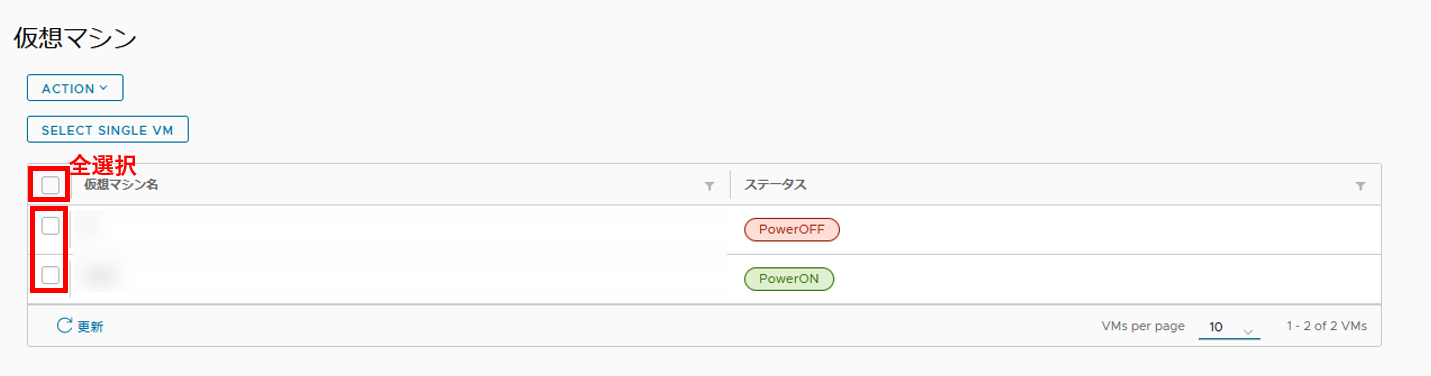

SELECT MULTIPLE VMS:仮想マシンの複数の仮想マシンを同時に操作するモード(以後、マルチ操作モード)に移行します。

[SELECT MULTIPLE VMS]をクリックしてモードが移行するとボタンの名称が[SELECT SINGLE VM]に変化します。

[SELECT SINGLE VM]をクリックすると再度1つの仮想マシンを操作するモード(以後、シングル操作モード)に戻ります。

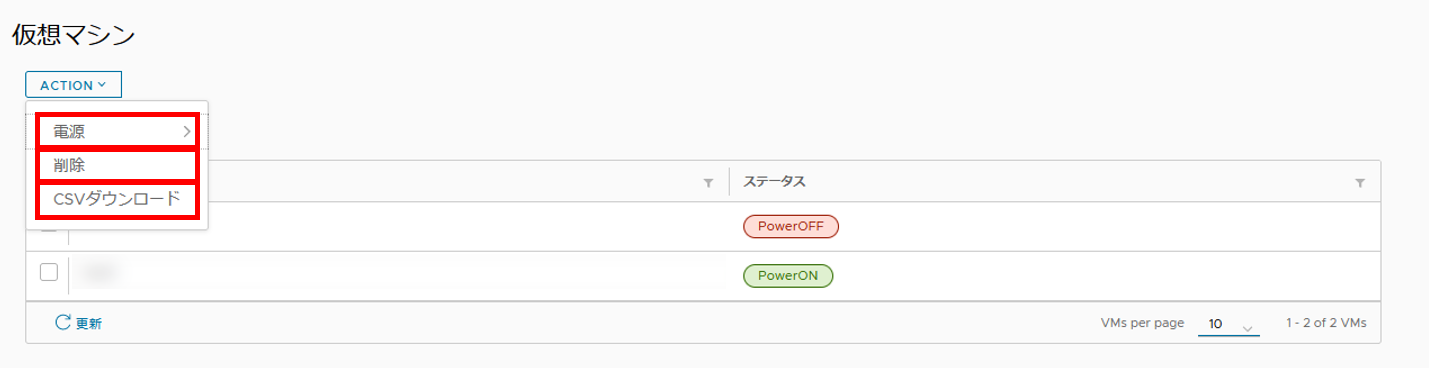

以下の機能は[ACTION]から利用できます。

電源:仮想マシンの電源操作を行います。

構成変更:仮想マシンのハードウェア構成の設定値を変更します。

メンテナンス:仮想マシンのメンテナンス機能を利用します。

10.4.1. 複数の仮想マシンを同時に操作する¶

[SELECT MULTIPLE VMS]をクリックするとマルチ操作モードに移行し、専用の画面が表示されます。

- 操作する仮想マシン名の左にあるチェックボックスをチェックします。すべての仮想マシンを対象とする場合はリスト最上部の項目名左にあるチェックボックスをチェックします。

選択した仮想マシンに対する操作を選択します。

電源:選択した仮想マシンに対して電源関連の操作を行います。

可能な操作は[起動], [シャットダウン], [再起動], [リセット], [強制停止]です。

削除:選択した仮想マシンを削除します。

CSVダウンロード:選択した仮想マシンのネットワークに関する情報を出力します。

10.4.2. 電源関連の操作を行う¶

10.4.3. ハードウェア構成設定を変更する¶

[ACTION]>[構成変更]から仮想マシン作成時に設定したハードウェア構成設定を変更することができます。

(通常プロジェクトの場合) パック数

(セキュアプロジェクトの場合) CPU数

(セキュアプロジェクトの場合) メモリ(GB)

(セキュアプロジェクトの場合) GPU数

サービスネットワーク数

サービスネットワーク

仮想ディスク容量

仮想ディスクの追加・削除

注:仮想ディスク容量を増やす場合には仮想マシン側でパーティションの再設定が必要となります。操作例については こちら をご確認ください。

10.4.4. メンテナンス¶

[ACTION]>[メンテナンス]からその他の操作を行うことができます。

仮想マシン名変更: 仮想マシンの名称を変更します。詳細は デプロイ時の設定項目 。

仮想マシンの削除: 仮想マシンを削除します。

仮想マシンのクローン: 仮想マシンのクローンを行います。

仮想マシンの休止: 仮想マシンを休止状態(ステータス「Deallocated」)にして仮想マシンに割り当てられている計算資源を解放します。

休止後の仮想マシンの状態は、 VMWare Tools のインストール状態によって異なります。

VMWare Toolsの状態は仮想マシンの詳細情報に表示されるサマリタブ内の項目[VMWare Tools]で確認できます。

VMware Toolsがインストール済みかつ実行されている場合の仮想マシン:シャットダウン → CPUおよびGPUの割り当て解除

VMware Toolsがインストールされていない、もしくはインストール済かつ実行されていない場合の仮想マシン:強制停止 → CPUおよびGPUの割り当て解除

サービスレベル変更: 現在の仮想マシンのサービスレベルを変更します。「スポット仮想マシン」から「起動保証仮想マシン」への変更あるいは、「起動保証仮想マシン」から「スポット仮想マシン」へ変更します。

アロケートのキャンセル: 仮想マシンの起動処理中で空きリソース待ちの際、起動処理中の状態をキャンセルします。

OVFインポート: 仮想マシンのOVFイメージをインポートします。

OVFエクスポート: 仮想マシンのOVFイメージをエクスポートします。

ACL設定:指定したマシンのIPアドレスを元にACLの設定を追加します。詳細は ACL設定 。

DNAT設定:指定したマシンのIPアドレスを元にDNATの設定を追加します。詳細は DNAT設定 。

10.4.4.1. 仮想マシンのクローンを利用して仮想マシンを複製する¶

仮想マシンの複製を行いたい場合、[ACTION]>[メンテナンス]>[仮想マシンのクローン]より行います。

クローン時の設定項目は、デプロイ時の設定項目で書かれた一部を指定できますが、項目の説明内容は同じ意味になります。 なお、仮想マシン名の記述形式により、複数の仮想マシンを同時にクローンできます。

詳細は デプロイ時の設定項目 をご確認ください。

10.4.4.2. OVFイメージを利用して仮想マシンを作成する¶

エクスポート

注釈

本操作を行う際は仮想マシンの状態を示すステータス欄が「休止(Deallocated)」であることをご確認ください。

コントロール画面のリストからエクスポートする仮想マシンにチェックを入れます。

[ACTION]>[メンテナンス]から[OVFエクスポート]をクリックします。

確認画面で[はい]をクリックします。

ブラウザのダウンロード機能でローカルに.ovf、.vmdkファイルの2点を保存します。

インポート

[ACTION]>[メンテナンス]から[OVFインポート]を選択します。

ローカルファイルでエクスポート時に生成した.ovf、.vmdkファイルをクリックします。

その他の項目を入力します。詳細は デプロイ時の設定項目 から確認できます。

入力が完了したら[はい]をクリックします。

10.5. ネットワーク設定¶

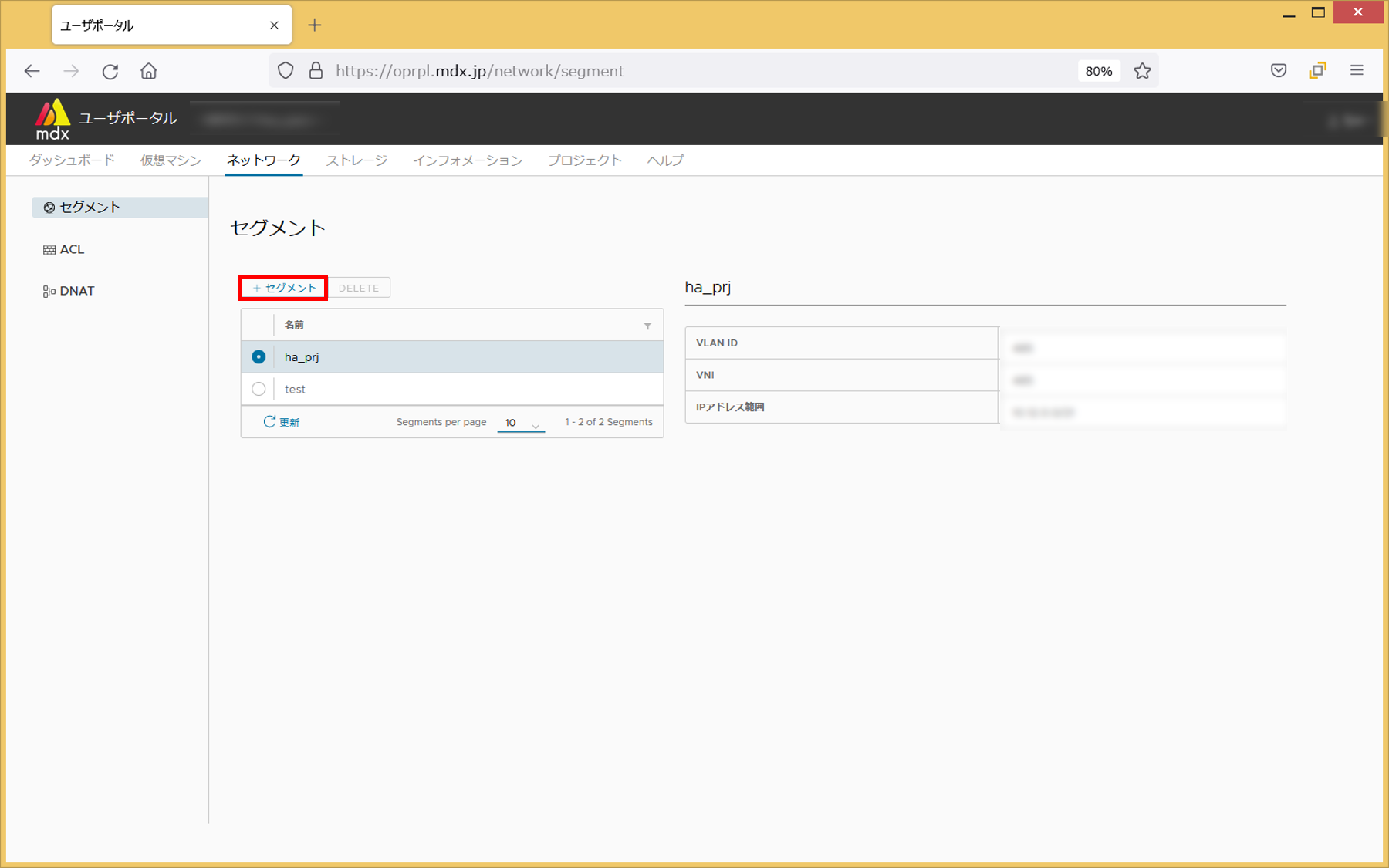

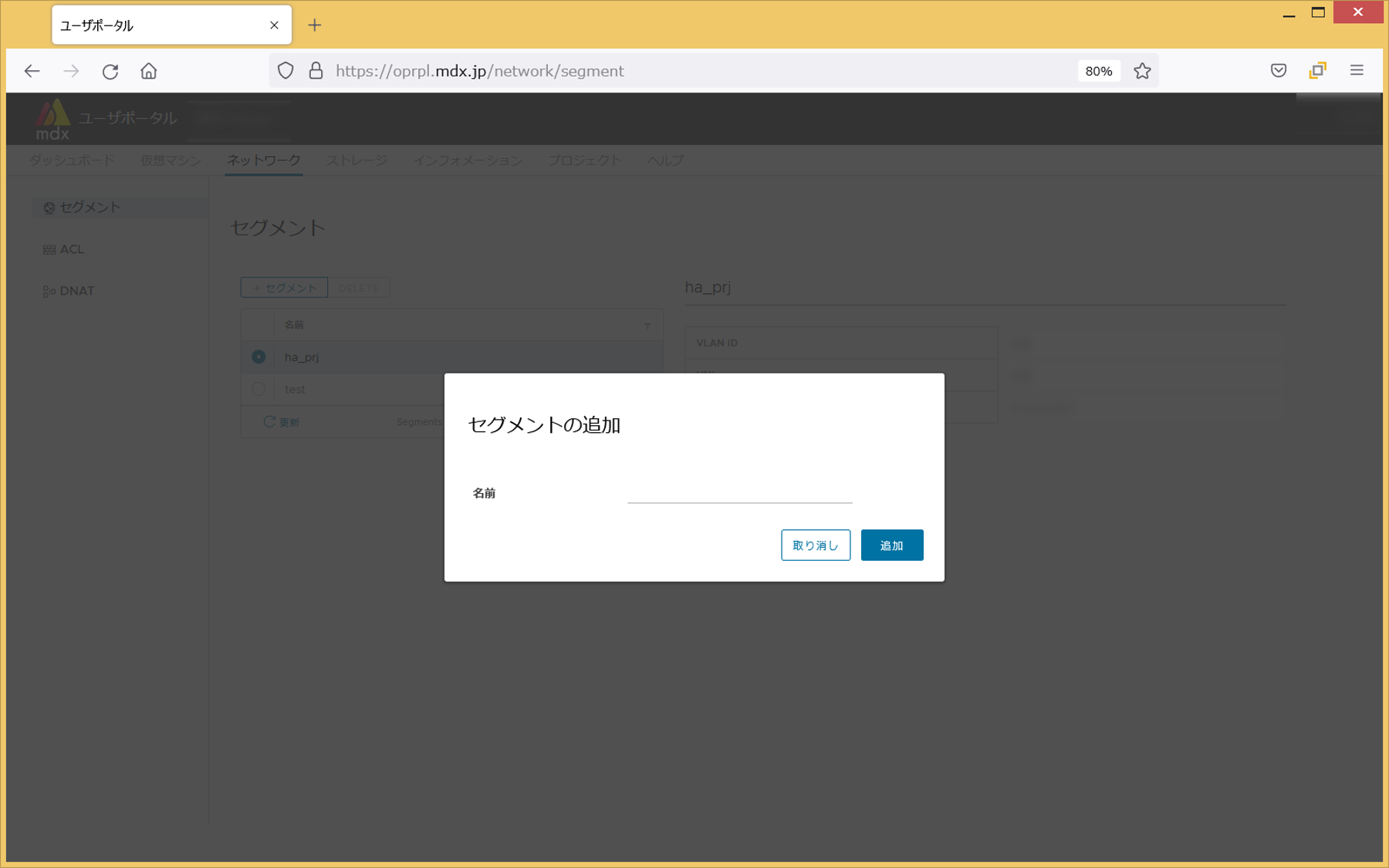

10.5.1. セグメント¶

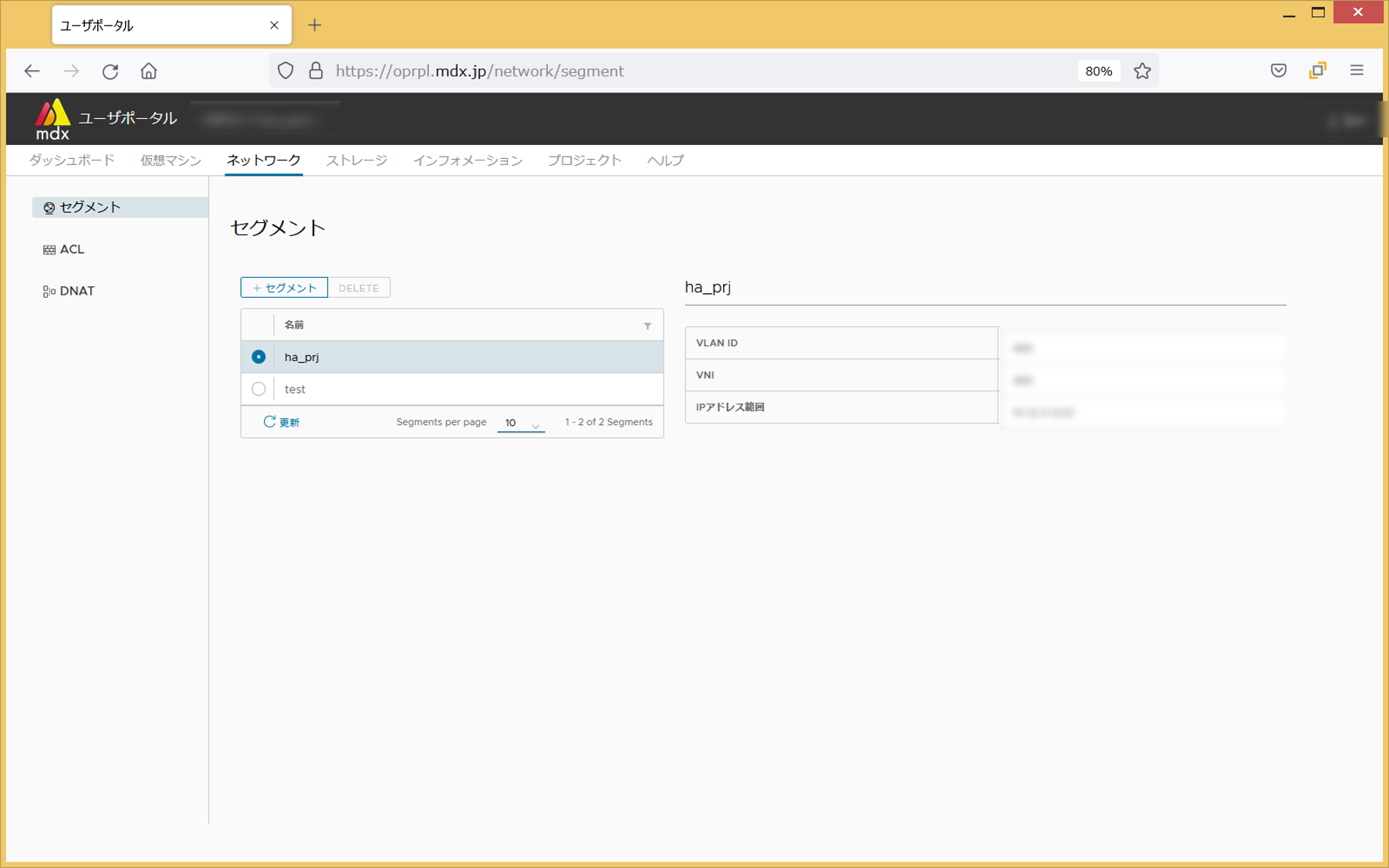

リストから任意のセグメントを選択すると、セグメントのパラメータを確認できます。

VLAN ID

IPアドレス範囲

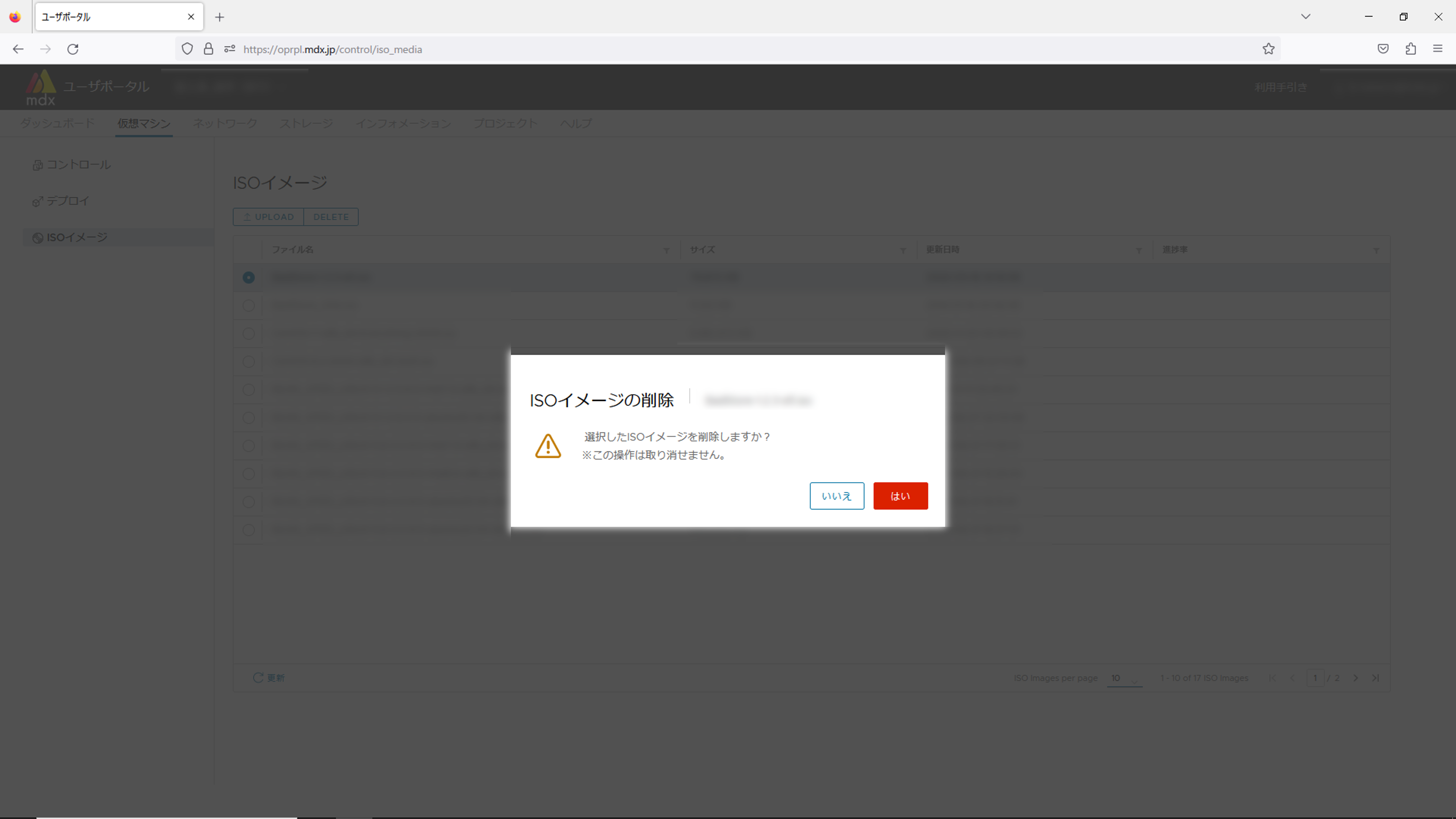

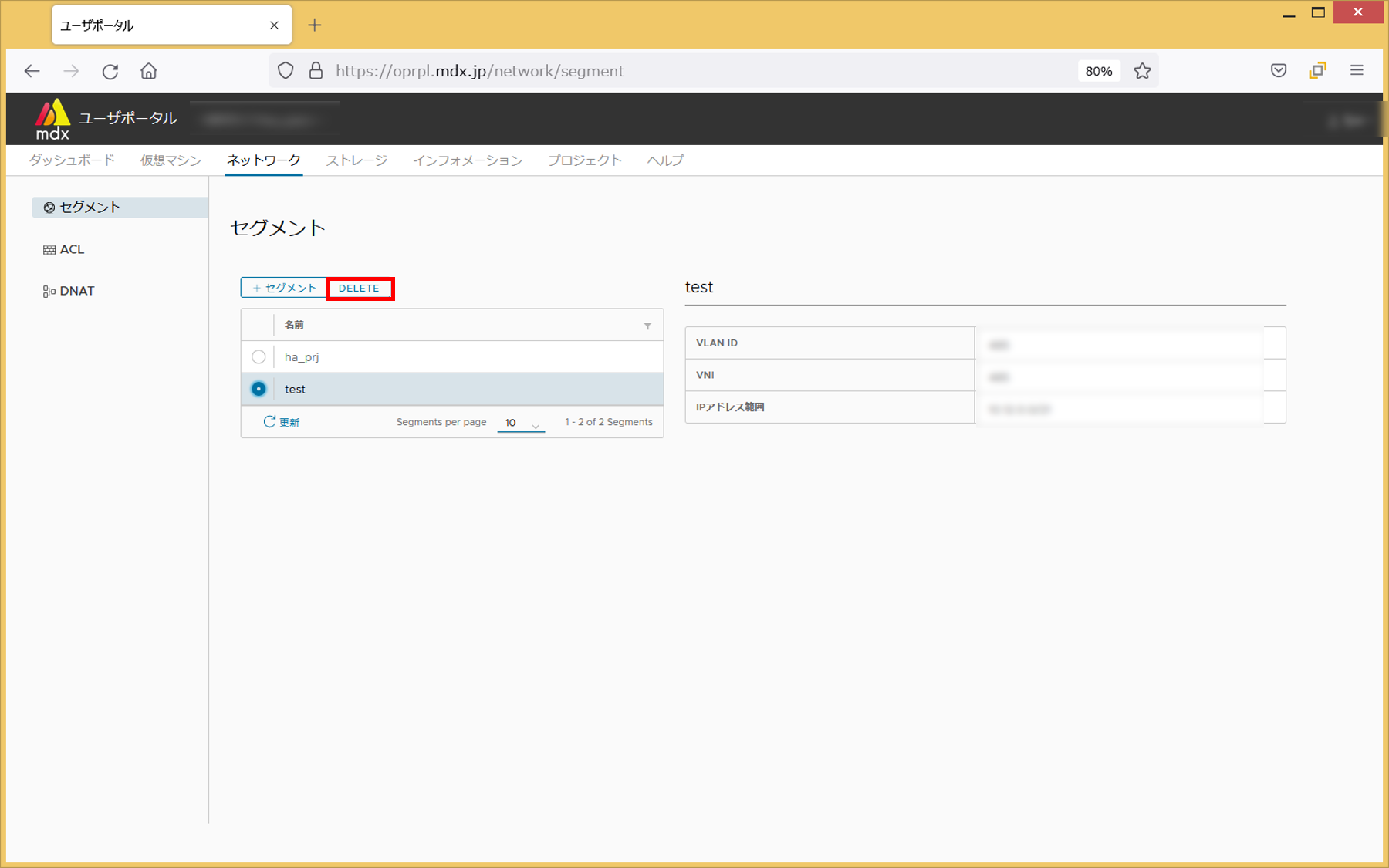

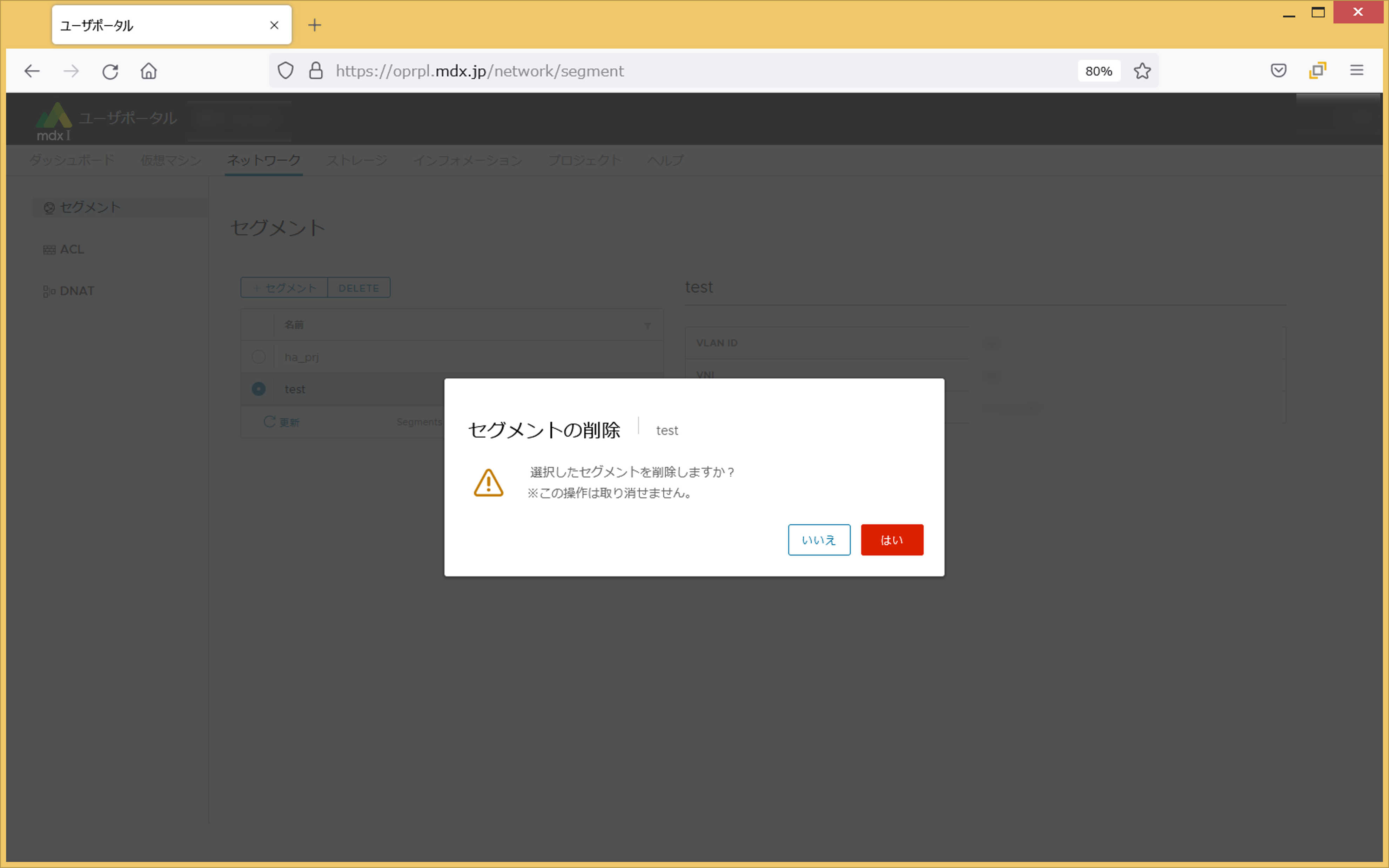

10.5.1.2. セグメントの削除¶

利用されていないセグメントを削除します。

任意のセグメントを選択します。

メイン画面・リスト上部の[DELETE]をクリックします。

削除しても問題ない場合は[はい]をクリックします。

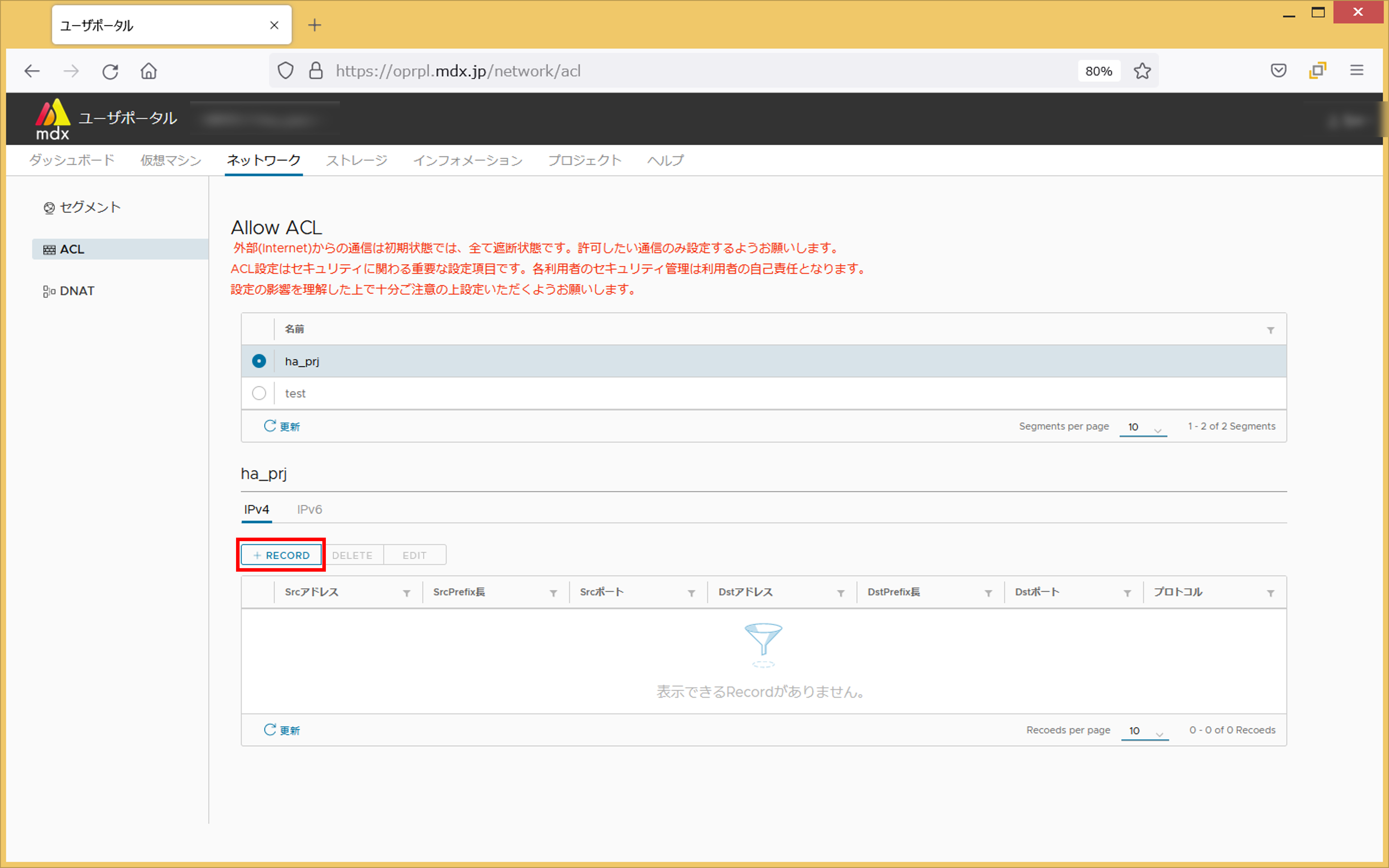

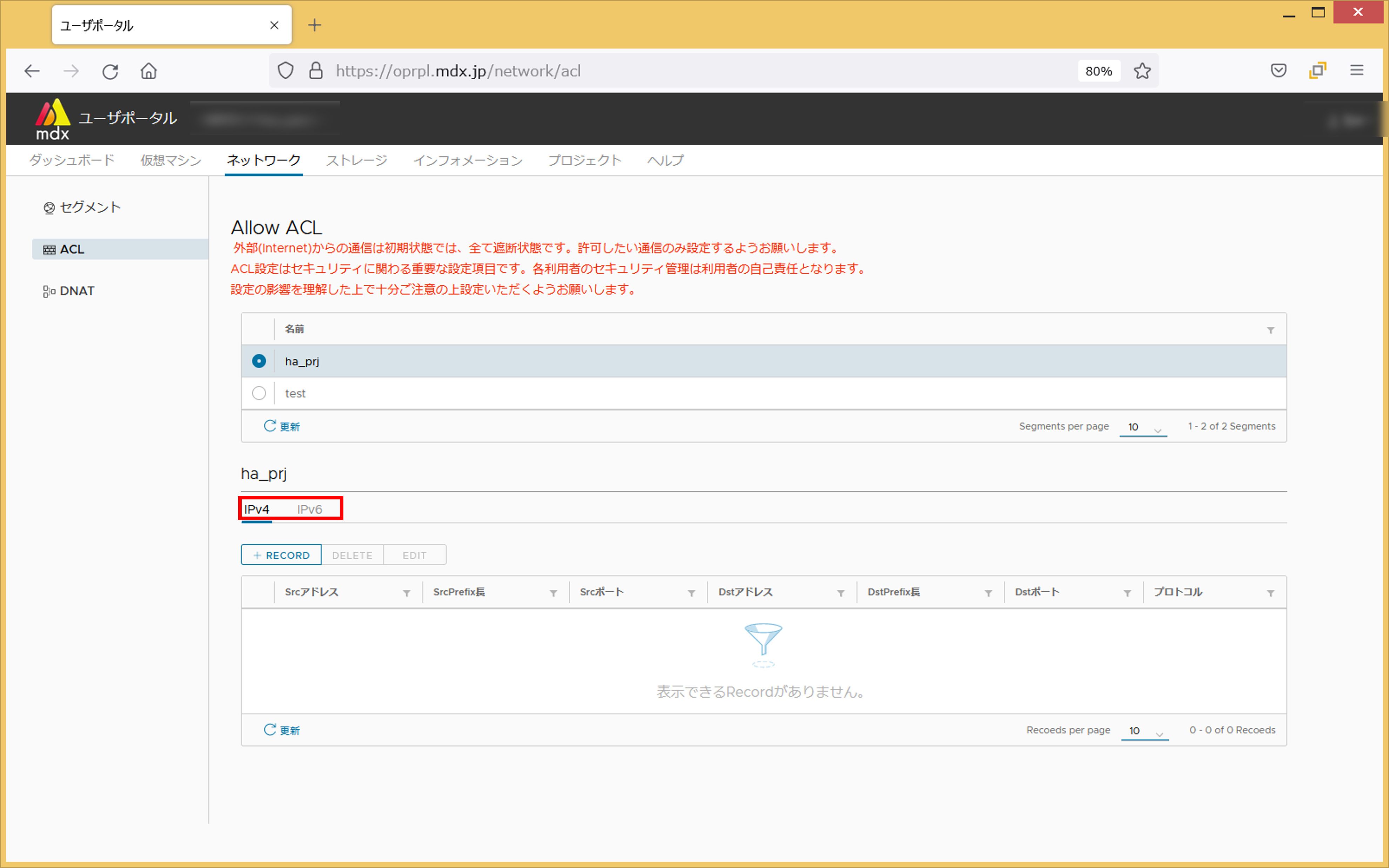

10.5.2. ACL(Access Control List)¶

注釈

メイン画面上部リストよりACLの設定を行う任意のセグメントを選択します。

メイン画面下部リストにてIPv4、IPv6のいずれかからネットワーク設定を確認したい方のタブをクリックします。

10.5.2.1. 設定項目¶

項目 |

説明 |

|---|---|

プロトコル |

許可するプロトコルを、ICMP(IPv6の場合は"ICMPv6")、TCP、UDPの中から選択する。 |

Srcアドレス/ SrcPrefix長 |

アクセスを許可する送信元のIP アドレスを指定する。

Prefix 長によってアドレス範囲が決まる。ここで指定したアドレス以外は接続を許可しない。

|

Srcポート |

アクセスを許可する送信元のポート番号を指定する。ポート番号を指定は、

複数指定(例:「80,443」)、範囲の指定(例:「22-443」)、Any(全て)の指定も可能。

|

Dstアドレス/ DstPrefix長 |

アクセスを許可する仮想マシンのIP アドレスを指定する。

Prefix 長によってアドレス範囲が決まる。ここで指定したアドレス以外は接続を許可しない。

|

Dstポート |

アクセスを許可する仮想マシンのポート番号を指定する。ポート番号を指定は、

複数指定(例:「80,443」)、範囲の指定(例:「22-443」)、Any(全て)の指定も可能。

|

Tips

ネットワークアドレスの設定方法についての詳細は FAQのDNAT・ACLについて をご確認ください。

10.5.2.3. レコードの削除¶

削除したい任意のレコードを選択した状態で[DELETE]をクリックします。

確認画面が表示されますので問題なければ[はい]をクリックします。

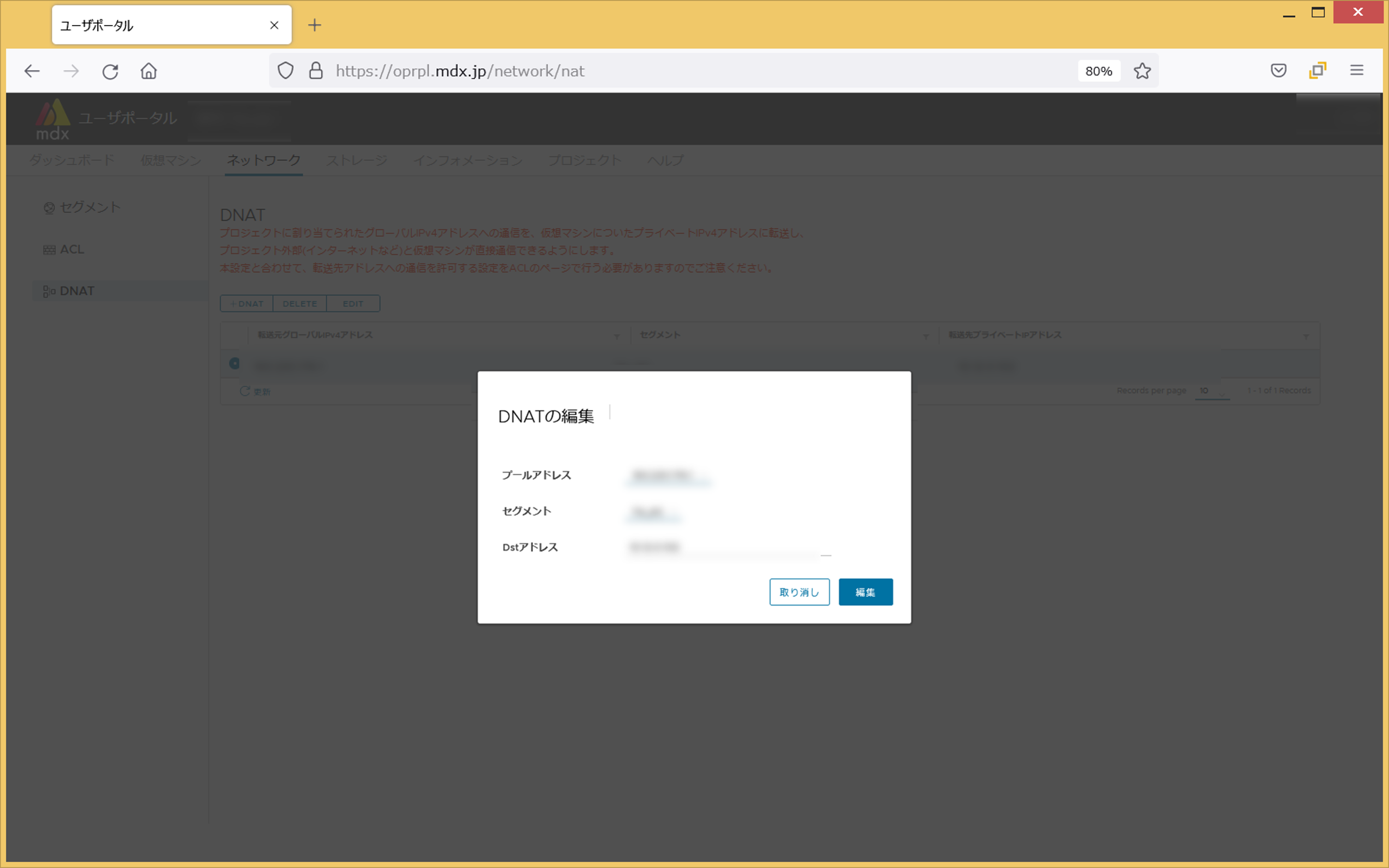

10.5.2.4. レコードの編集¶

編集したい任意のレコードを選択した状態で[EDIT]をクリックします。

編集したい設定項目を更新します。

入力が完了したら[編集]をクリックします。

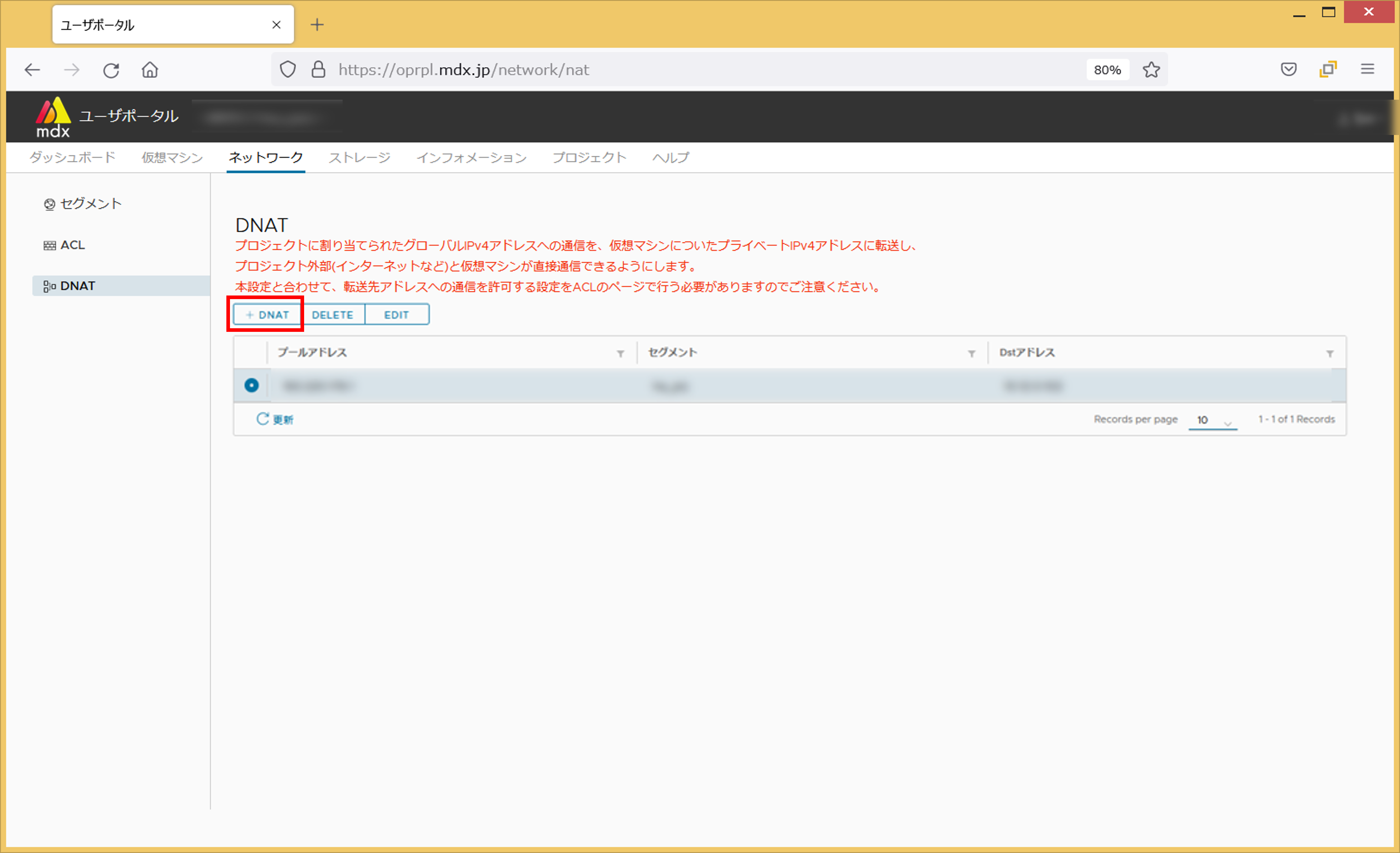

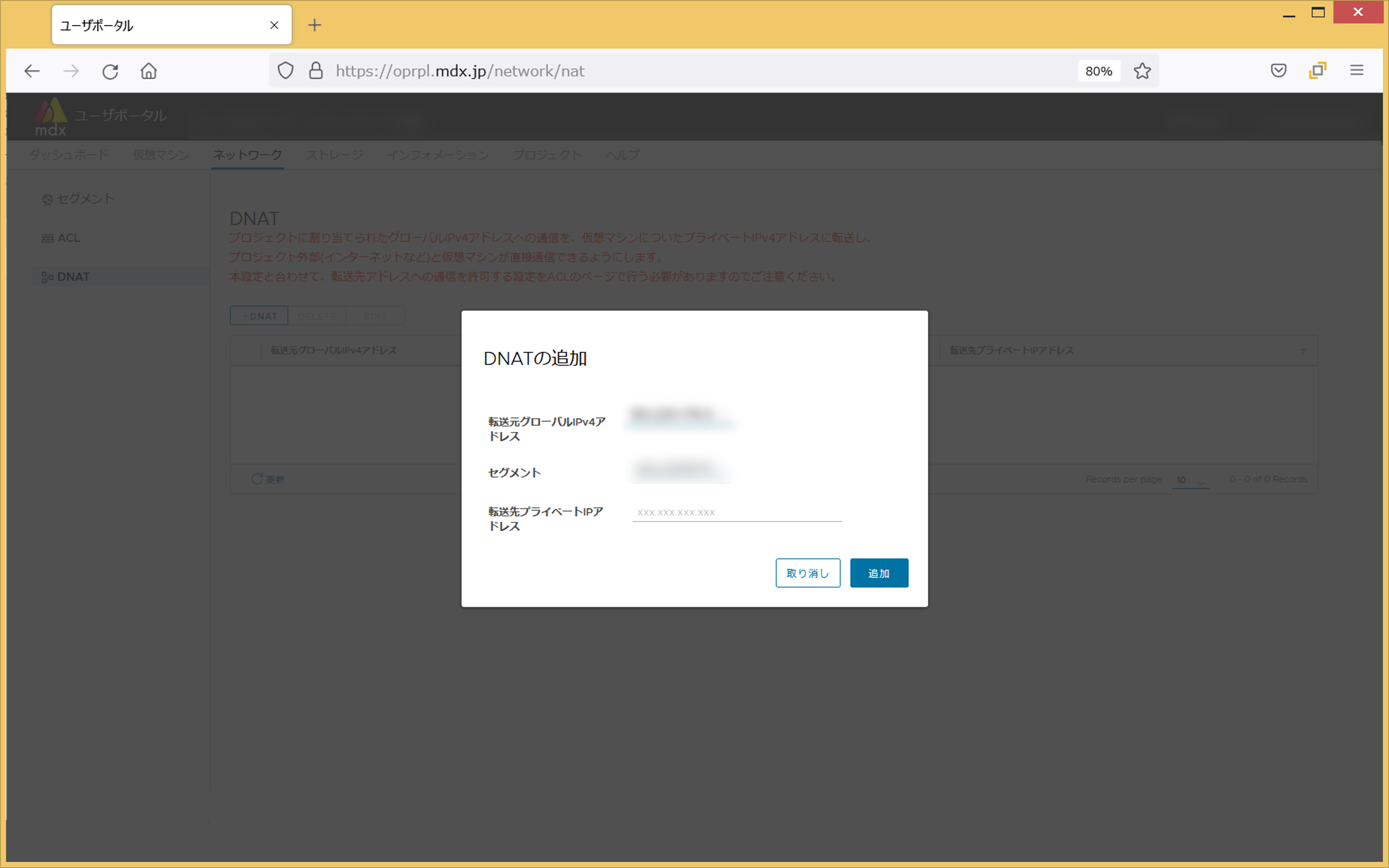

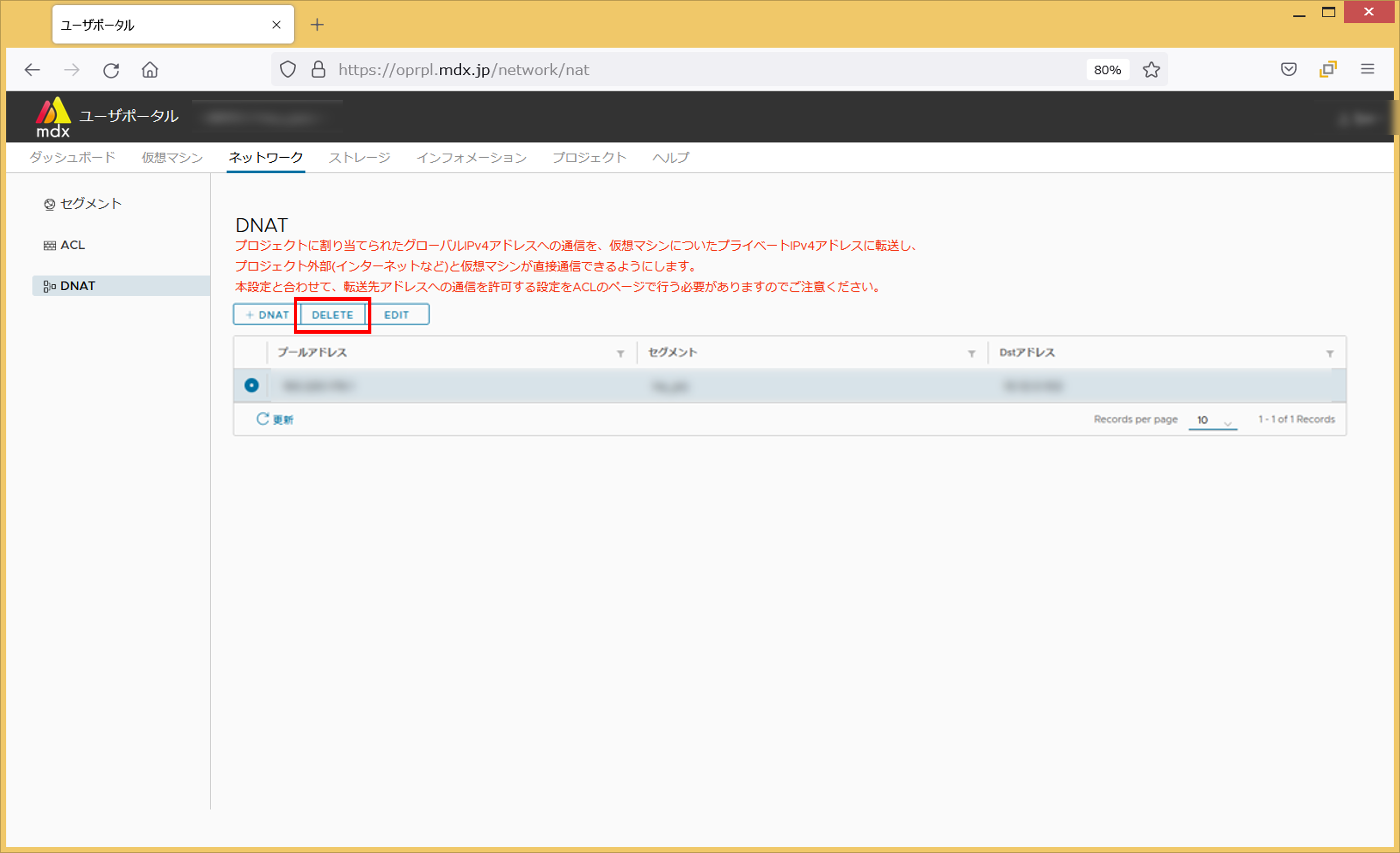

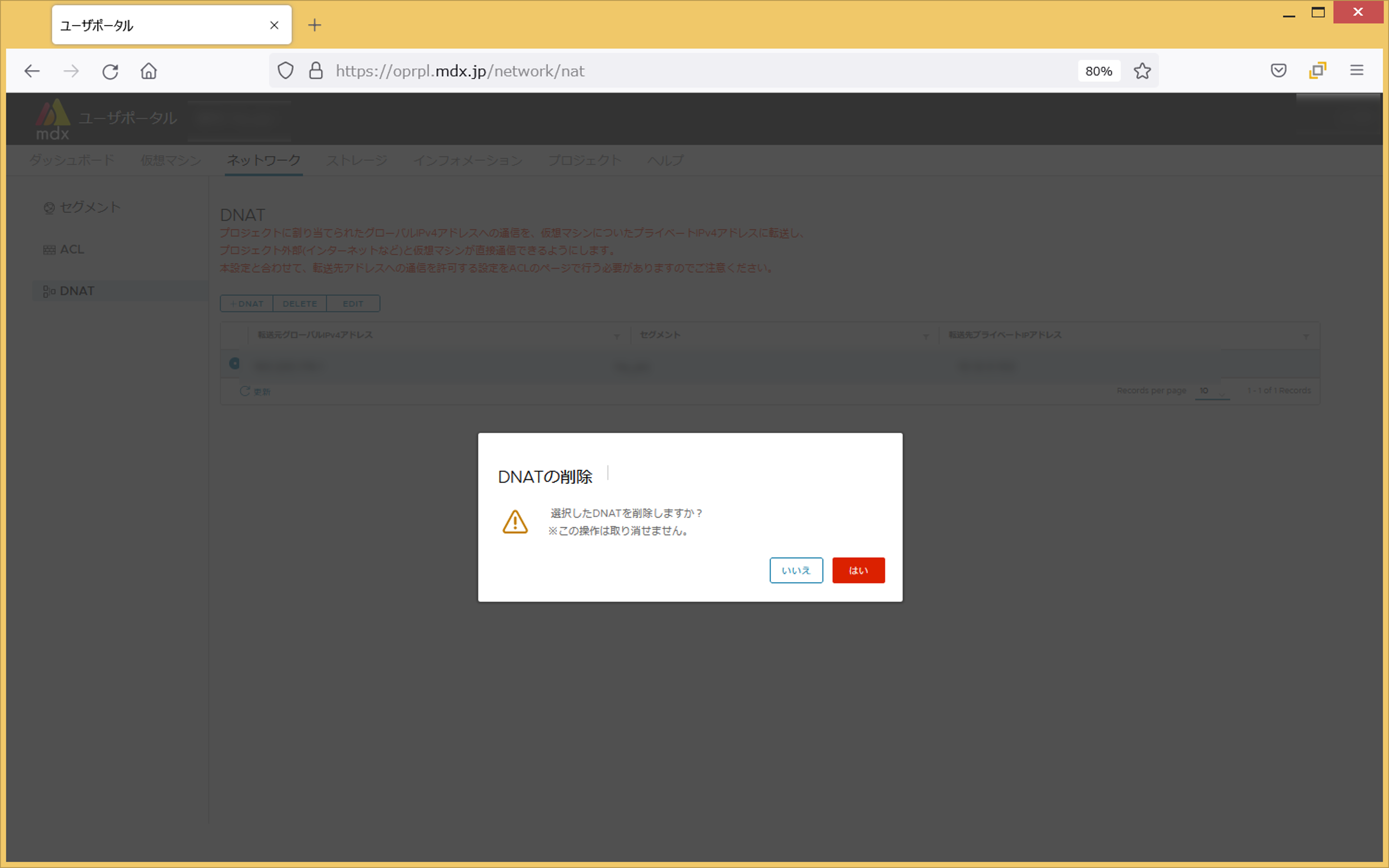

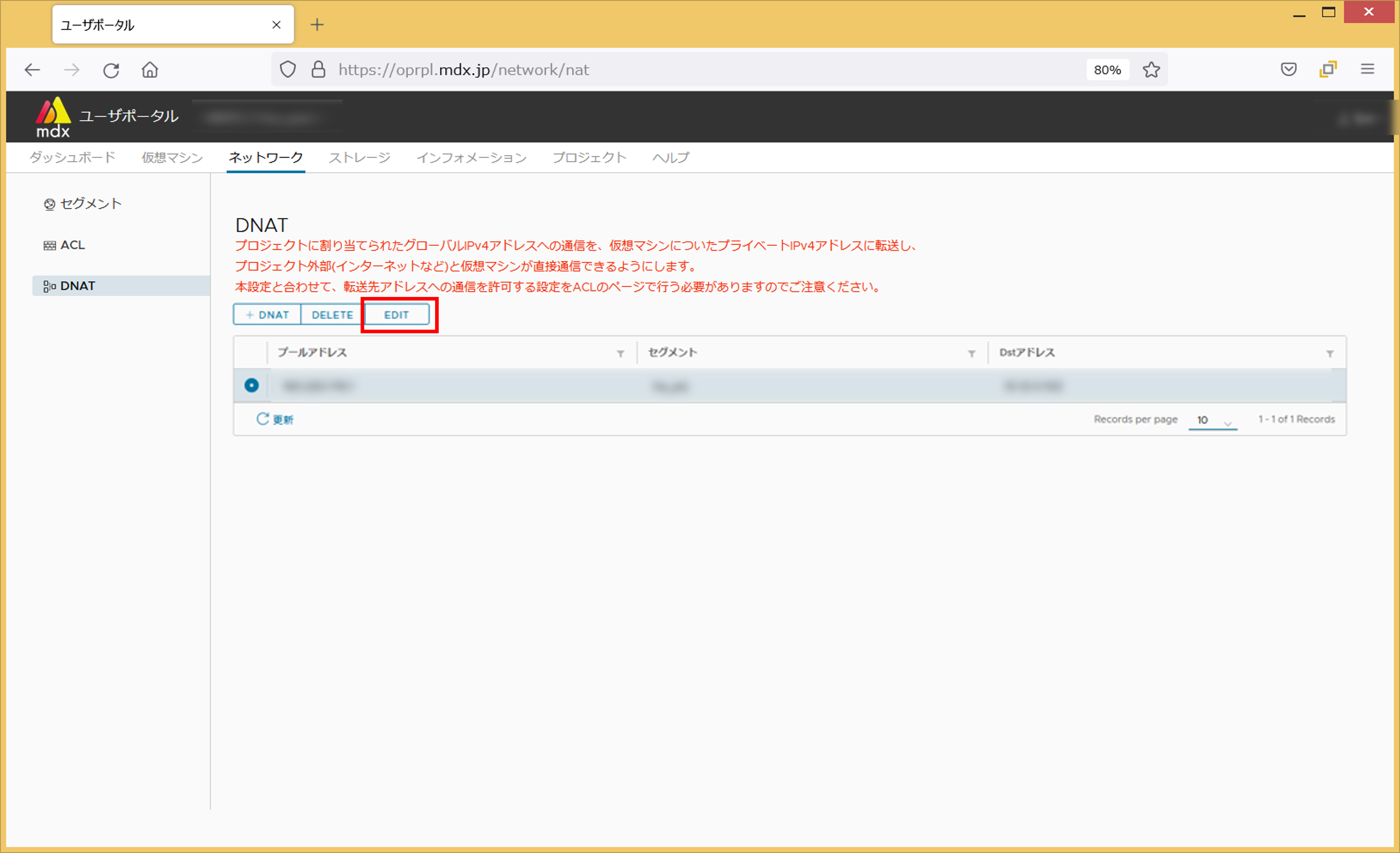

10.5.3. DNAT¶

注釈

DNATにおける設定項目は以下の通りです。

項目 |

説明 |

|---|---|

転送元グローバルIPv4アドレス |

変換先のグローバルアドレスを指定する。 |

セグメント |

対象となるセグメントを指定する。 |

転送先プライベートIPアドレス |

変換元の仮想マシンのIP アドレスを指定する。 |

DNATの設定方法を以下で説明します。

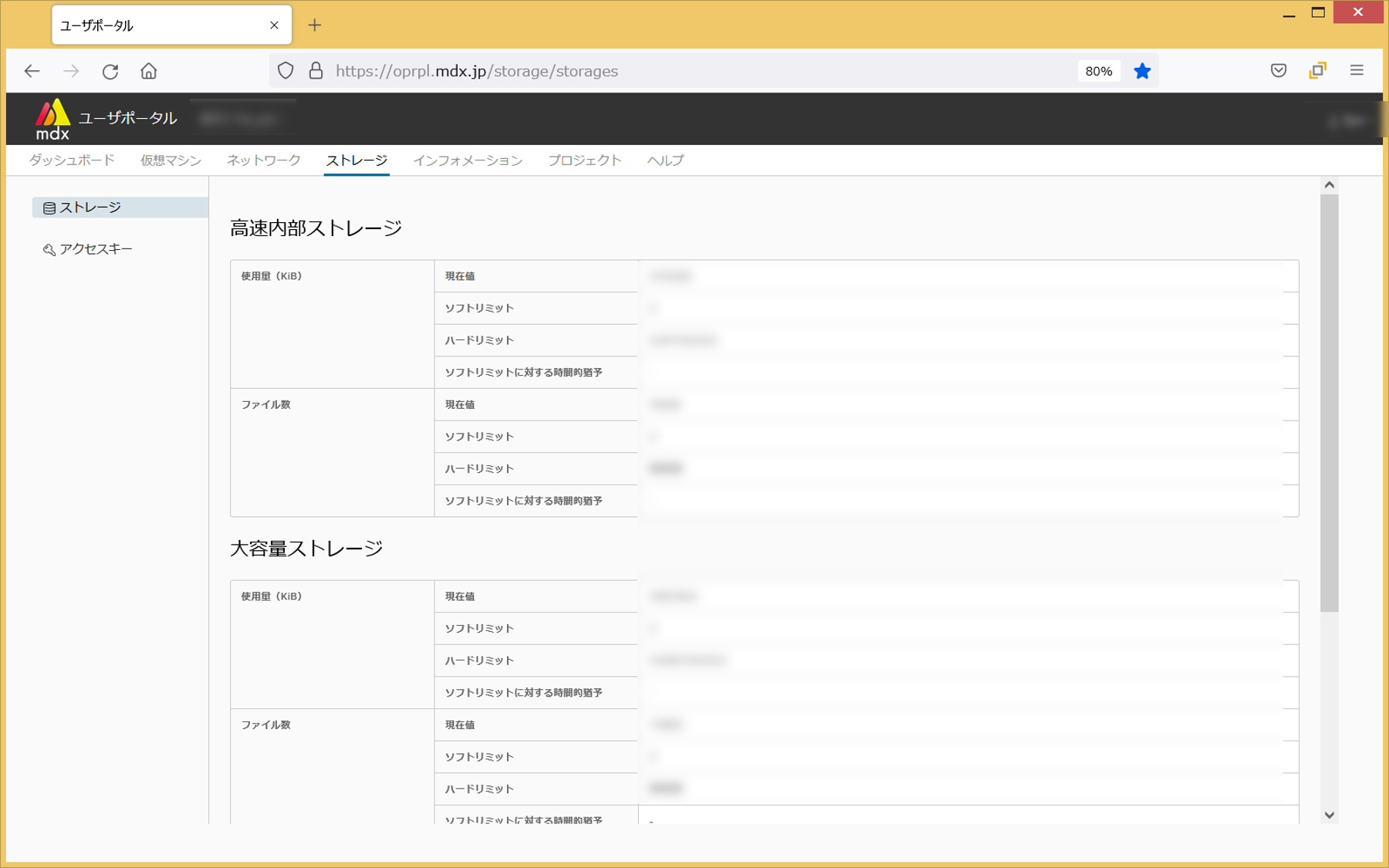

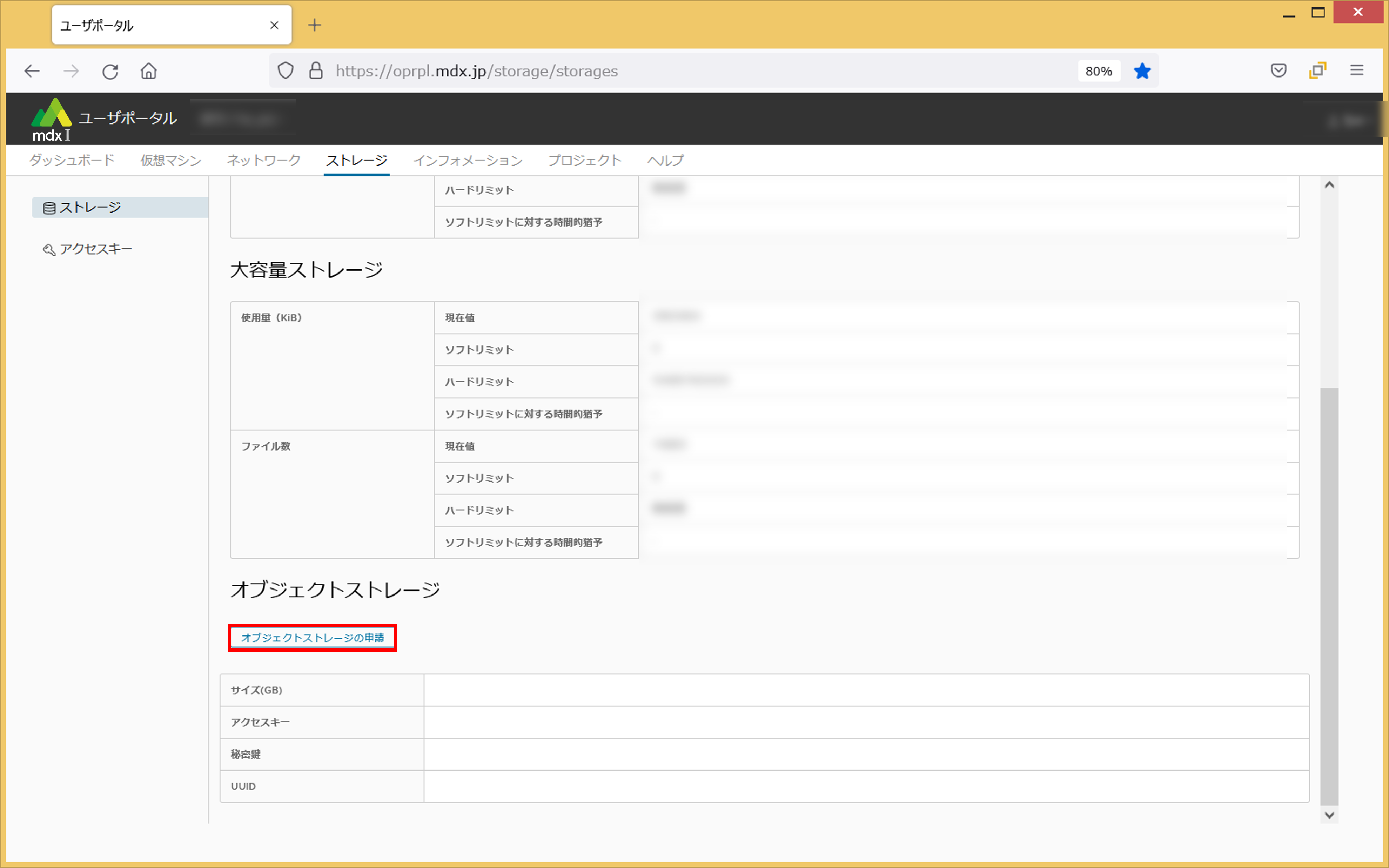

10.6. ストレージの利用状況の確認および追加ストレージの申請¶

本章では、ストレージ利用に関する設定を行う手順について説明します。 本設定は上部メニューから[ストレージ]をクリックした画面から確認できます。

10.6.1. ストレージの利用状況を確認する¶

ストレージの利用状況はサイドメニューの[ストレージ]から確認できます。

また、メイン画面下部の[オブジェクトストレージの申請]から、追加のストレージ利用を申請することができます。

申請するストレージのサイズをGB単位で指定します。

申請内容に問題がないことを確認して[申請]をクリックします。以上でオブジェクトストレージの申請は完了です。

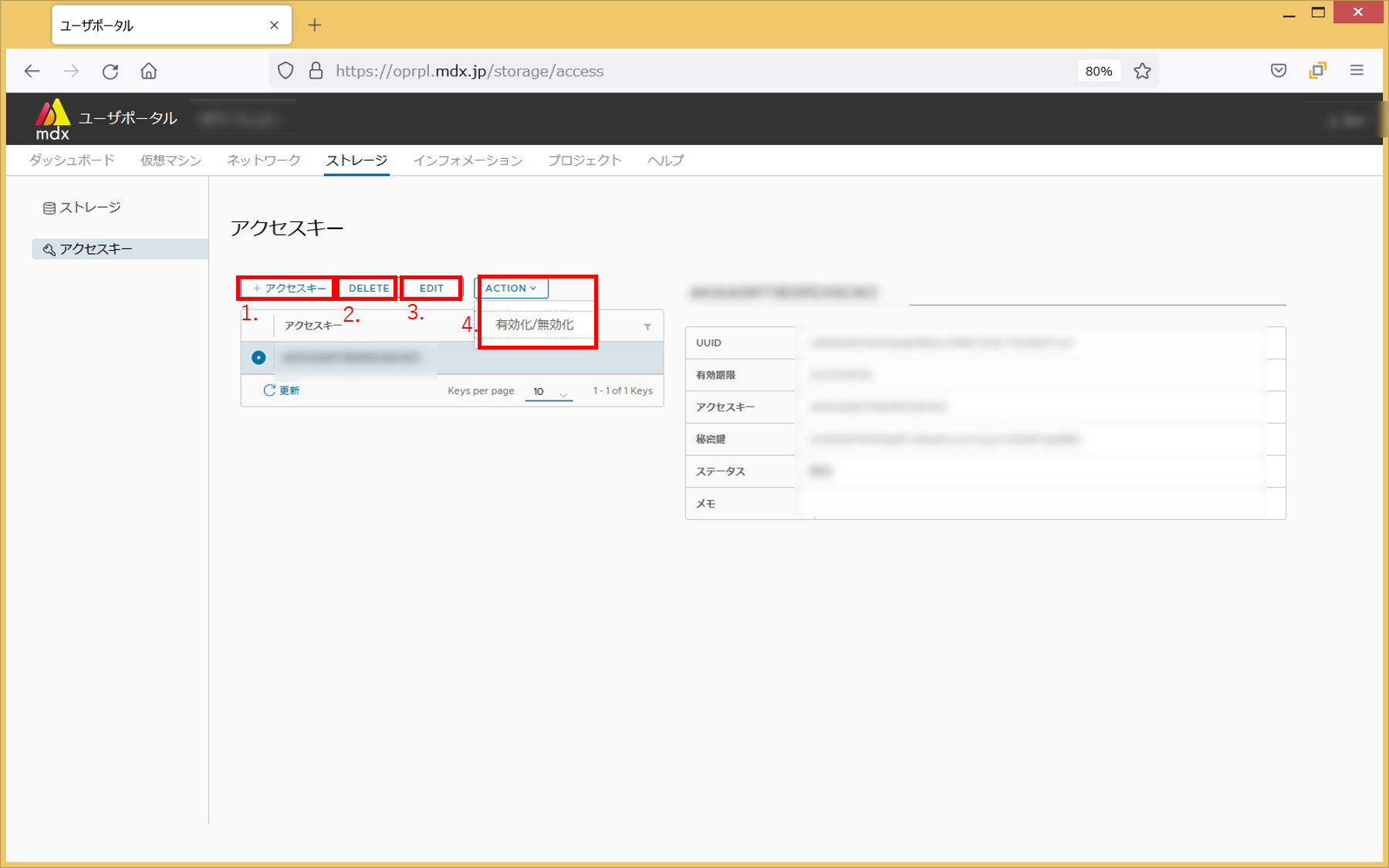

10.6.2. オブジェクトストレージにアクセスするためのキーの確認・追加を行う¶

アクセスキーを追加します

追加する際にはアクセスキーの有効期限を同時に設定します

アクセスキーを削除します

アクセスキーの有効期限を編集します

アクセスキーの有効・無効状態を切り替えます

10.7. プロジェクトの確認と変更に関する機能¶

注釈

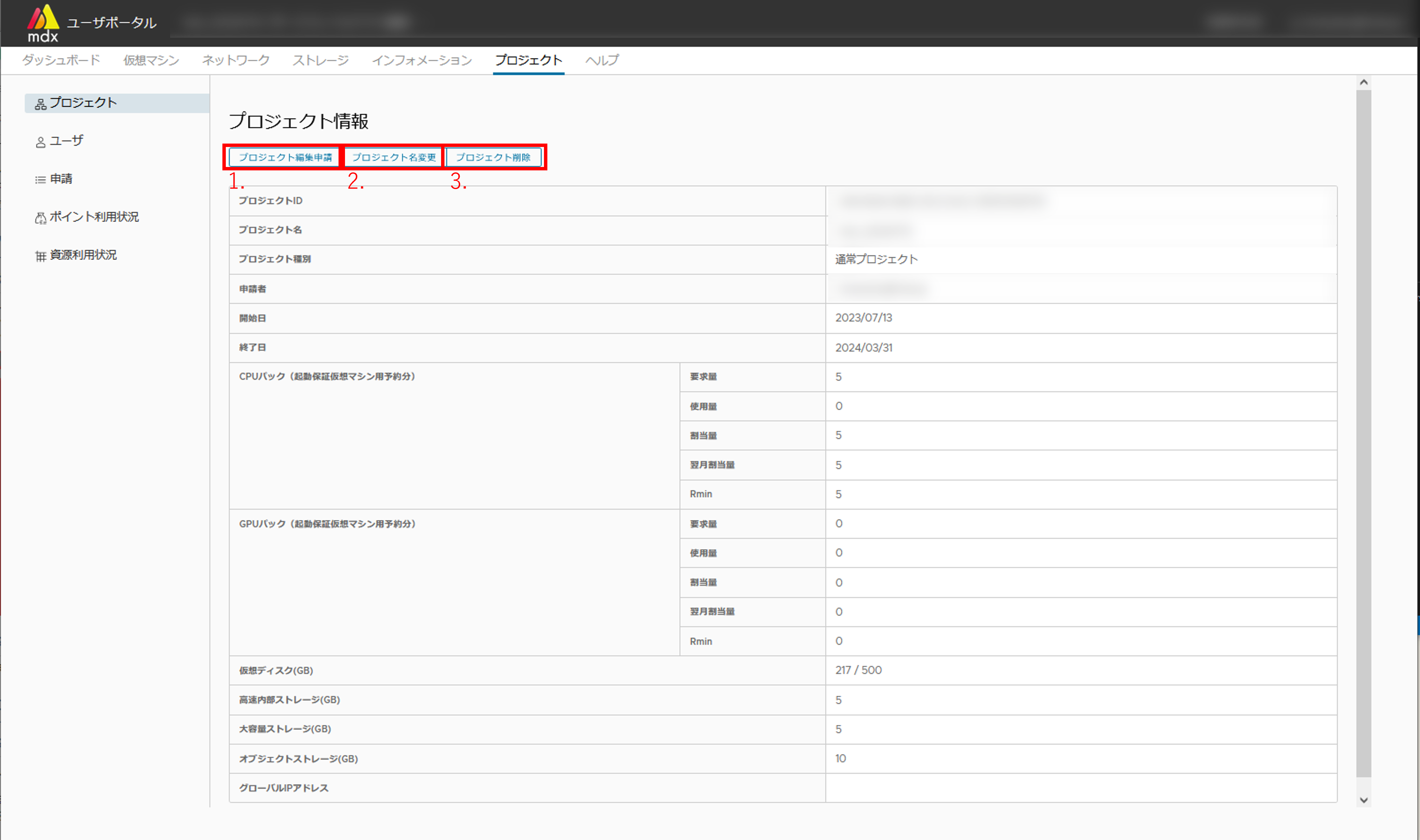

10.7.1. プロジェクト情報の確認と変更を行う¶

本機能はサイドメニューの[プロジェクト]から利用できます。

- プロジェクトの資源の申請・期間の変更を申請します。設定可能な項目は以下の通りです。本申請はプロジェクト種別が「お試し」以外の場合に実施できます。

(通常プロジェクトの場合) CPUパック(起動保証仮想マシン用予約分)

(通常プロジェクトの場合) GPUパック(起動保証仮想マシン用予約分)

(セキュアプロジェクトの場合) 専有汎用ノード数

(セキュアプロジェクトの場合) 専有演算加速ノード数

仮想ディスク(GB)

高速内部ストレージ(GB)

大容量ストレージ(GB)

グローバルIPアドレス数

終了期間

プロジェクト名を変更します

プロジェクトを削除します

注釈

プロジェクトを削除すると、仮想マシンもすべて削除されアクセスができなくなります。削除された仮想マシンを復旧させることはできませんので、ご注意ください。

10.7.1.1. 申請できる資源について¶

プロジェクト種別ごとに以下「〇」がついている資源を申請できます。

資源 |

通常 |

専有 |

|---|---|---|

CPUパック(起動保証仮想マシン用予約分) |

〇 |

- |

GPUパック(起動保証仮想マシン用予約分) |

〇 |

- |

専有汎用ノード数 |

- |

〇 |

専有演算加速ノード数 |

- |

〇 |

仮想ディスク |

〇 |

〇 |

高速内部ストレージ |

〇 |

〇 |

大容量ストレージ |

〇 |

〇 |

グローバルIPアドレス数 |

〇 |

〇 |

上記の資源解放のタイミングで起動保証仮想マシンをデプロイしていた場合、自動でスポット仮想マシンに変更されます。

資源解放後、起動保証仮想マシン用にCPUパック・GPUパックを利用したい場合は再度資源の申請を行います。

名称 |

仮想CPU数 |

仮想メモリ量 |

GPU数 |

|---|---|---|---|

専有汎用ノード |

152 |

約256GB |

0 |

専有演算加速ノード |

152 |

約512GB |

8 |

なお、1台の仮想マシンに指定できるCPU数の上限は152CPU、GPU数の上限は8GPUとなります。

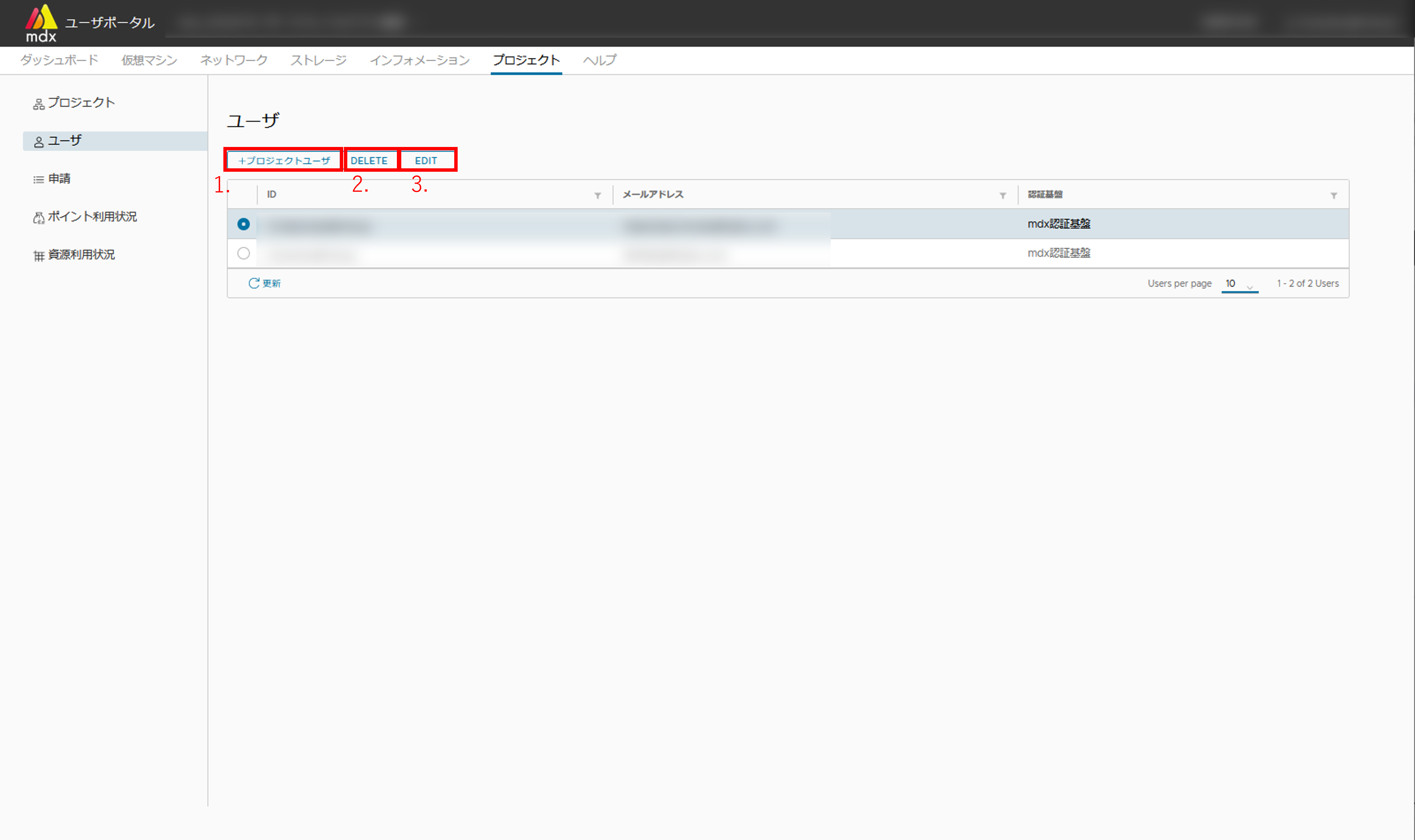

10.7.2. プロジェクトに所属するユーザの確認と変更を行う¶

- プロジェクトに新しいユーザを追加します設定可能な項目は以下の通りです

認証基盤:ユーザが利用しているアカウントを学認、もしくはmdxローカルアカウント(mdx認証基盤)のいずれかで指定する

mdx独自ID or 学認ID:ユーザを識別するための名称

メールアドレス:ユーザの連絡先メールアドレス

リストで選択されているユーザをプロジェクトから削除します

リストで選択されているユーザの情報を編集します

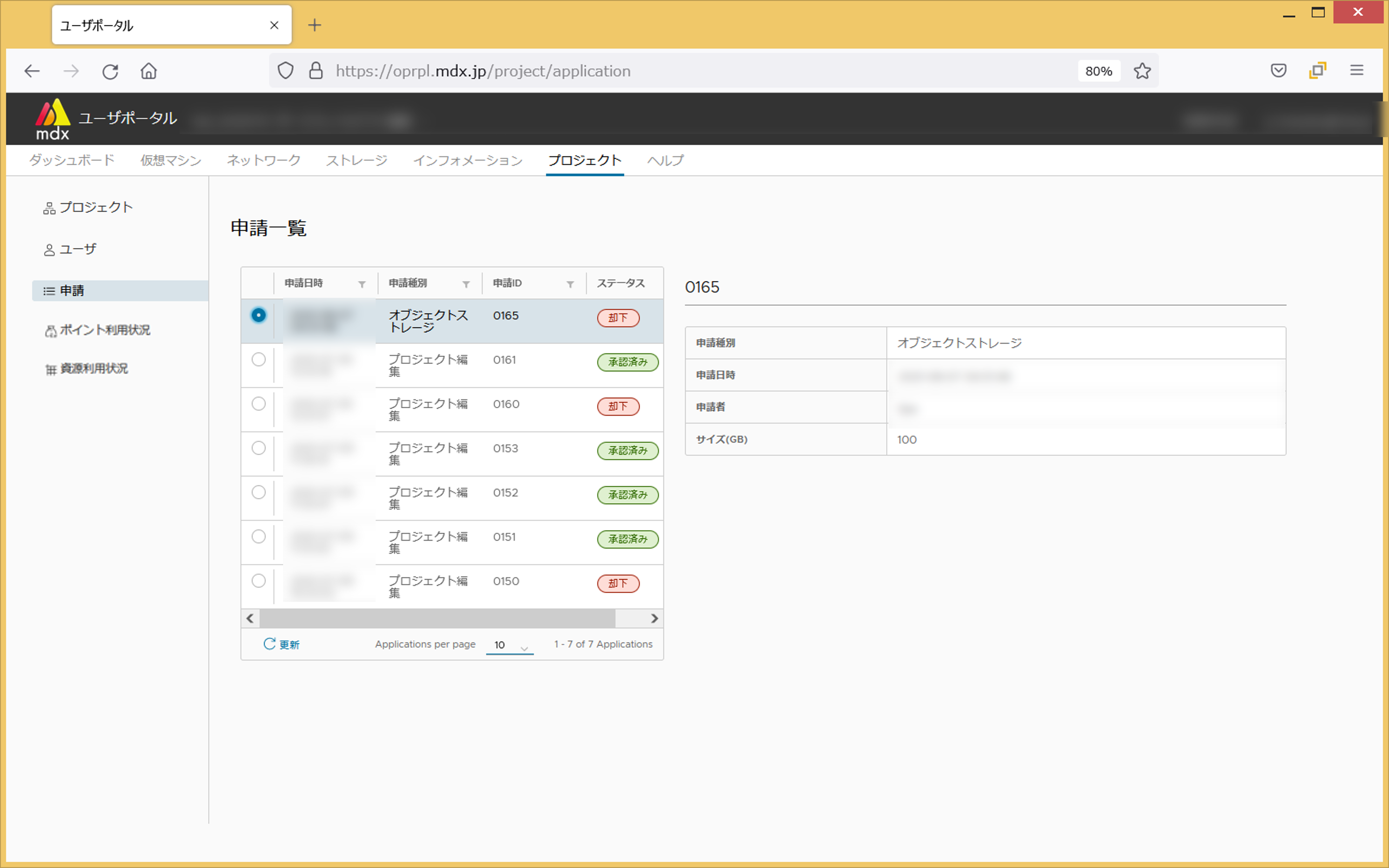

10.7.3. 申請の状況を確認する¶

各申請の現在の状態は[ステータス]欄に以下の状態で表示されます。

受付中

承認済み

却下

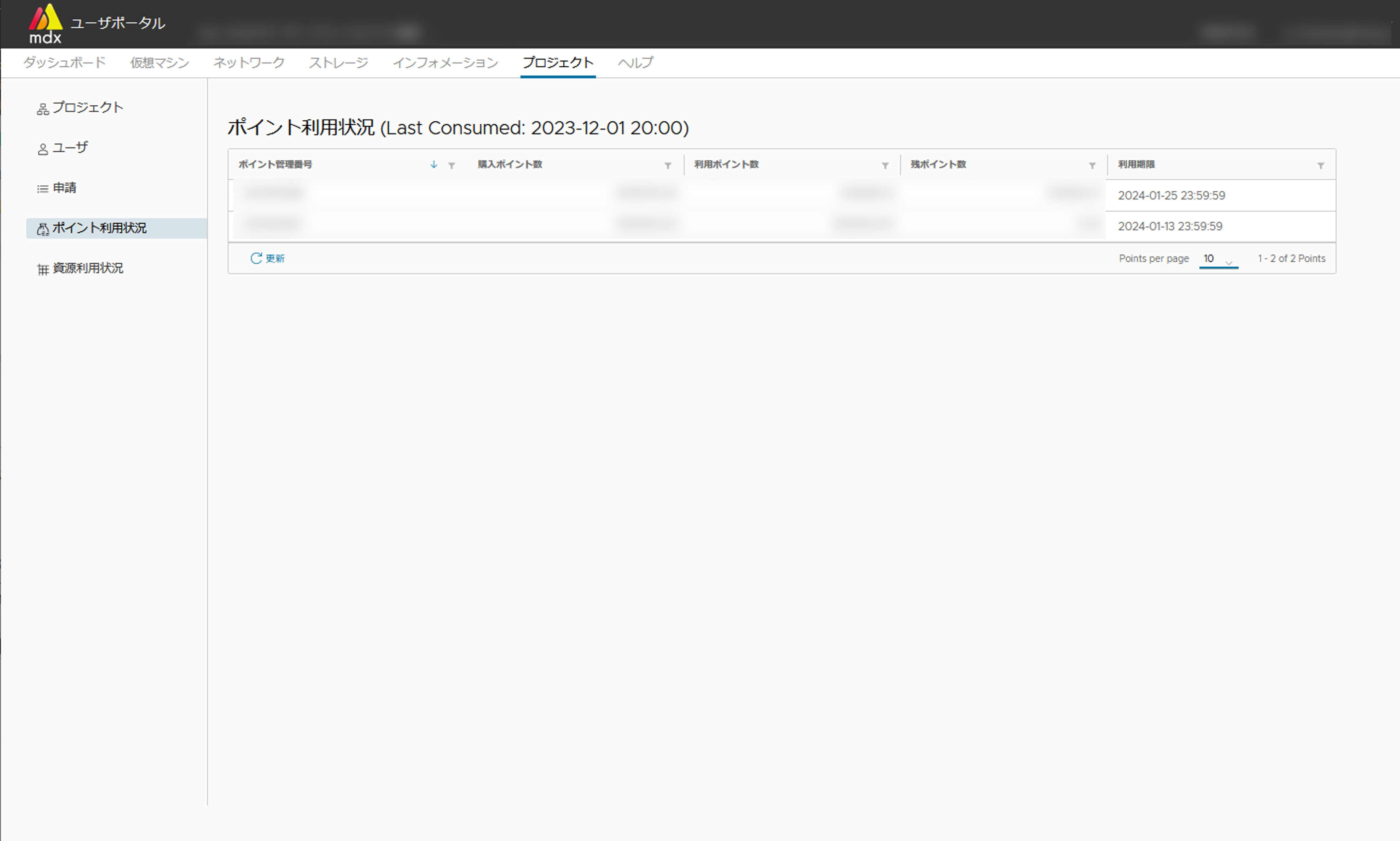

10.7.4. プロジェクトが保有するポイント状況を確認する¶

現在のプロジェクトが保有するポイントの状況を確認することができます。本機能はサイドメニューの[ポイント利用状況]から利用できます。

確認可能な項目は以下の通りです。

ポイント管理番号

購入ポイント数

利用ポイント数

残ポイント数

利用期限

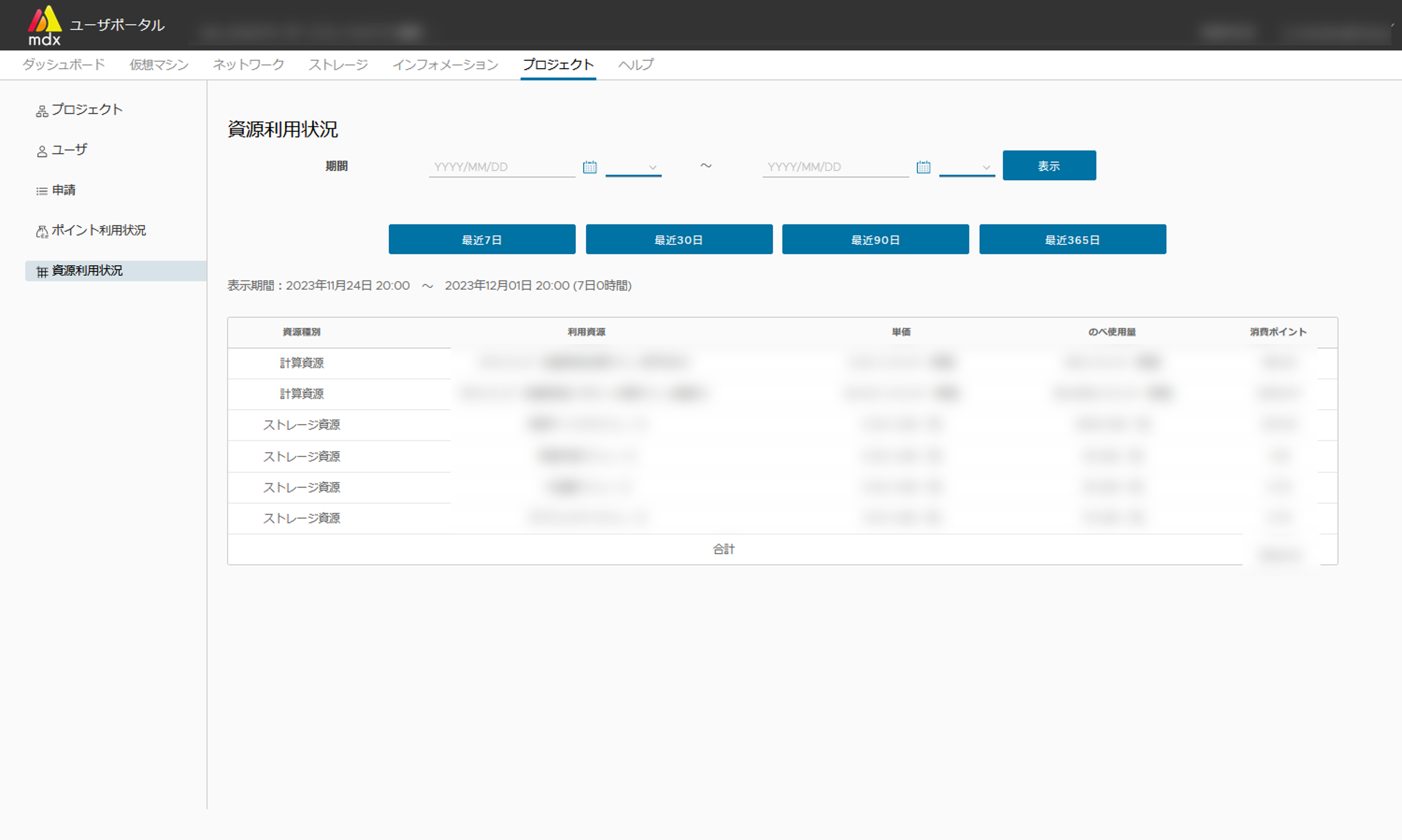

10.7.5. 資源の利用状況を確認する¶

指定した期間内で利用した資源量と消費したポイントを確認することができます。本機能はサイドメニューの[資源利用状況]から利用できます。

開始および終了日時を年月日と正時で指定した状態で[表示]をクリックすると結果が確認できます。

機能利用時点までの7日・30日・90日・365日の期間の結果を知りたい場合は[最近〇日]をクリックすることでも確認できます。

10.8. その他の機能について¶

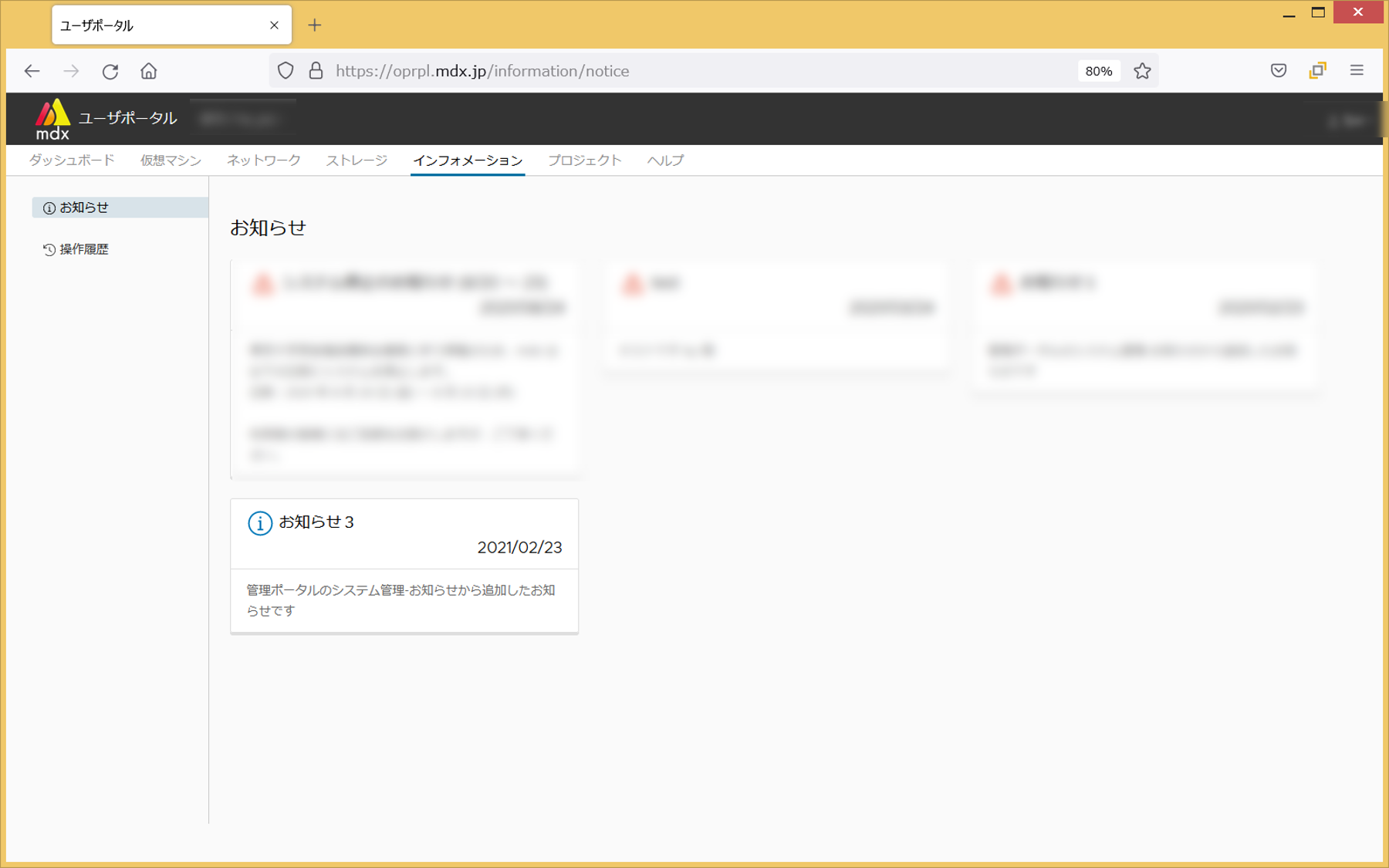

10.8.1. インフォメーション¶

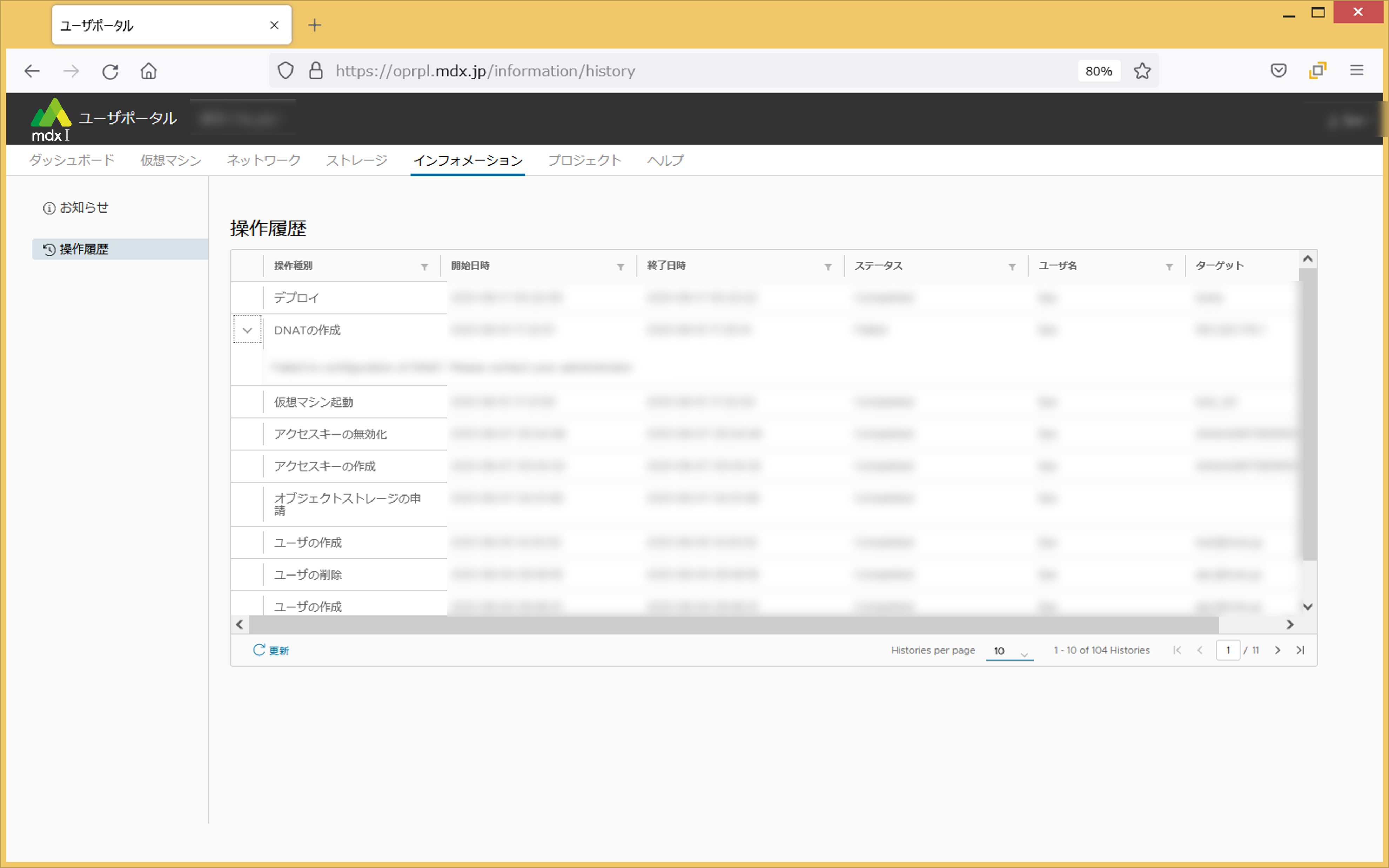

本内容は上部メニューから[インフォメーション]をクリックした画面から確認できます。

10.8.1.2. ユーザポータル上で行った操作の進捗状態と履歴を確認する¶

ユーザポータル上で今までに実施した各種操作について、現在の進捗状態および完了している場合にはその操作の実施結果を確認することができます。

操作種別 |

ユーザ名 |

操作内容 |

|---|---|---|

休止 |

System |

資源奪取による自動休止 |

休止 |

System |

資源再配分による自動休止 |

休止 |

System |

メンテナンスフラグ設定時の移動処理における休止 |

休止 (プロジェクト期間終了) |

System |

プロジェクトの期間終了による自動休止 |

休止 (プロジェクト停止) |

System |

プロジェクト停止による自動休止 |

自動休止 |

System |

パワーオフ状態のスポット仮想マシンの資源解放 |

デプロイ |

user name |

仮想マシンのデプロイ |

新規作成 |

user name |

テンプレート (ISOイメージ)によるデプロイ |

仮想マシン起動 |

user name |

仮想マシンの起動 |

仮想マシン名変更 |

user name |

仮想マシン名の変更 |

仮想マシン削除 |

user name |

仮想マシンの削除 |

仮想マシン強制停止 |

user name |

仮想マシンのパワーオフ |

仮想マシンリセット |

user name |

仮想マシンのパワーオフ処理後、パワーオン |

ゲストOSのシャットダウン |

user name |

仮想マシンのシャットダウン |

ゲストOSの再起動 |

user name |

仮想マシンのOSシャットダウン処理後、パワーオン |

設定の編集 |

user name |

仮想マシンの各リソースの設定変更 |

コンソール |

user name |

コンソール表示 |

クローン |

user name |

仮想マシンのクローン |

ISOイメージアップロード |

user name |

ISOイメージアップロード |

ISOイメージマウント |

user name |

仮想マシンへISOイメージのマウント |

ISOイメージアンマウント |

user name |

仮想マシンのISOイメージのアンマウント |

OVFエクスポート |

user name |

仮想マシンのOVFイメージエクスポート |

OVFインポート |

user name |

仮想マシンのOVFイメージインポート |

DNATの編集 |

user name |

ネットワークのDNAT設定 |

ACL (IPv4)の作成 |

user name |

ネットワークのACL (IPv4)の新規追加 |

ACL (IPv4)の編集 |

user name |

ネットワークのACL (IPv4)の設定済み内容の変更 |

ACL (IPv6)の作成 |

user name |

ネットワークのACL (IPv6)の新規追加 |

ACL (IPv6)の編集 |

user name |

ネットワークのACL (IPv6)の設定済み内容の変更 |

セグメントの作成 |

user name |

ネットワークセグメントの追加 |

プロジェクト編集 |

user name |

プロジェクト情報の編集申請 |

ユーザの作成 |

user name |

プロジェクトユーザの追加 |

ユーザの編集 |

user name |

プロジェクトユーザ情報の編集 |

パスワード変更 |

user name |

プロジェクトユーザのパスワード変更 |

オブジェクトストレージの申請 |

user name |

オブジェクトストレージの利用申請 |

アクセスキーの編集 |

user name |

オブジェクトストレージ用アクセスキーのメモや有効期限の編集 |

アクセスキーの有効化 |

user name |

オブジェクトストレージ用アクセスキーの有効化 |

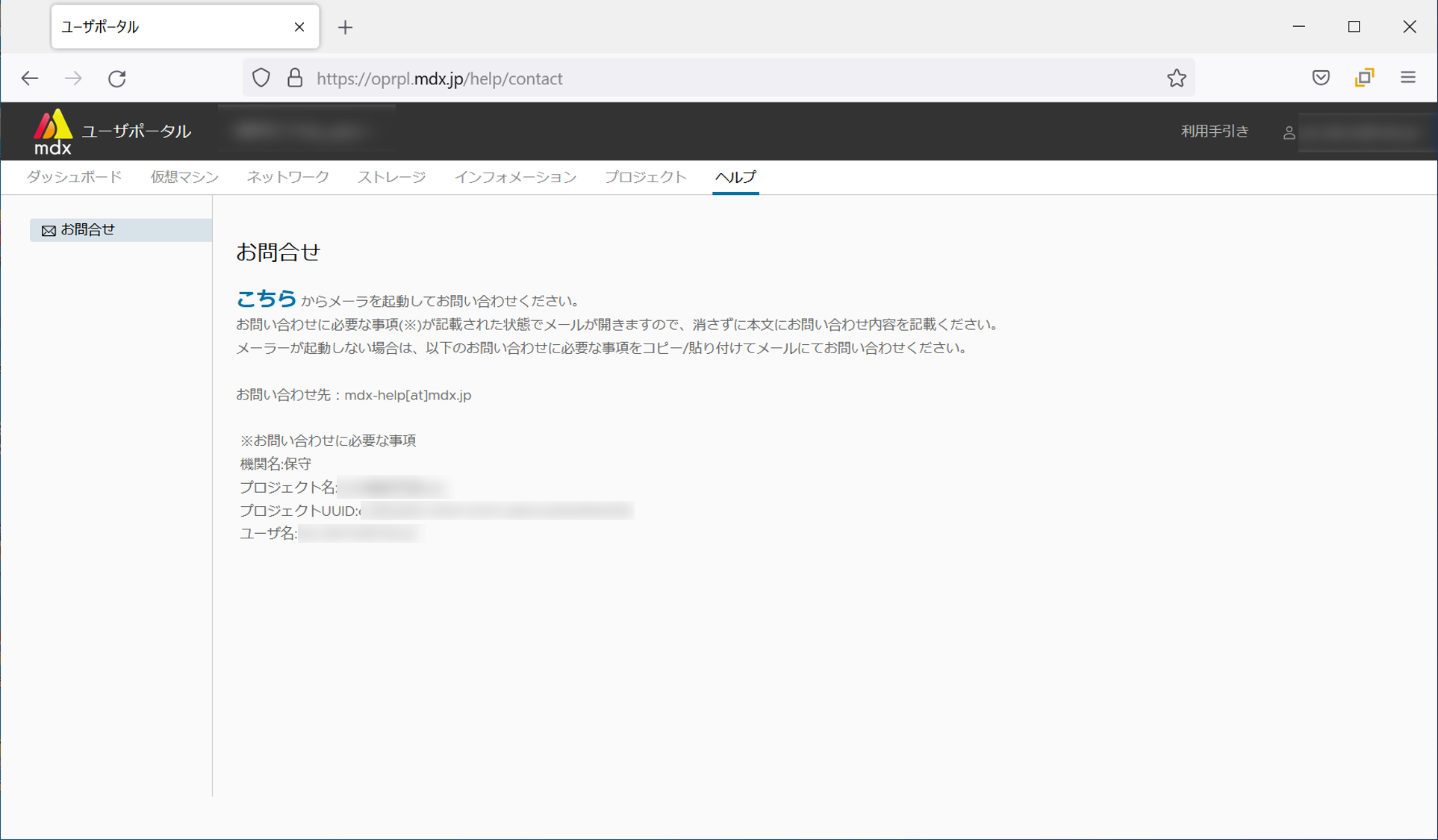

10.8.2. ヘルプ¶

メールで管理者に問合せを行います。お問合せ画面からメーラーを起動する場合にはお問合せに必要な情報が自動的に挿入されます。

上部メニューから[ヘルプ]をクリックします。

お問合せ画面の記載事項に従ってメーラーを利用し問合せを行います。

11. 複数仮想マシンによるクラスタの作成例¶

mdx上にデプロイした複数の仮想マシンを使って簡単なクラスタを構築する例について説明します。

11.1. Ansibleとその概要¶

ここでは、そうしたプロビジョニングツールのひとつである Ansible を使ってmdx上に複数のVMを展開して設定する例を紹介します。

Ansibleを実行するために最低限必要なファイルは、

- playbook

設定するマシンの中で実行する処理を記述したYAML形式のファイル

- inventory

設定を行う対象のマシンのIPアドレスや付加する情報などを記述したファイル

の2つです。

deploy-jupyter.yaml を用意し、その中にはJupyterlabをデプロイするために必要な処理を記述します。hosts というファイルを用意し、 ansible-playbook -i hosts deploy-jupyter.yaml と打てば、複数のVMにJupyterlabを立ち上げることができます。ansible-playbook コマンド (ないし ansible コマンド)を実行して他のホストを設定/制御するホストをControl node、逆にControl nodeから設定/制御されるホスト(この場合はVM)をManaged nodeと呼びます。 +---------+

playbook.yaml | |

hosts | Managed |

+---------+ +----->| node1 |

| | | | |

| Control | ssh | +---------+

| node +-----+

| | | +---------+

+---------+ | | |

| | Managed |

+----->| node2 |

| |

+---------+

ansible-playbook コマンドを実行すると、ssh越しに2台のManaged Nodeが設定されます。11.2. https://github.com/mdx-jp/machine-configs¶

注釈

現在全てのplaybookは ubuntu server 22.04 テンプレートから作成したVMに対して実行することを想定しています。

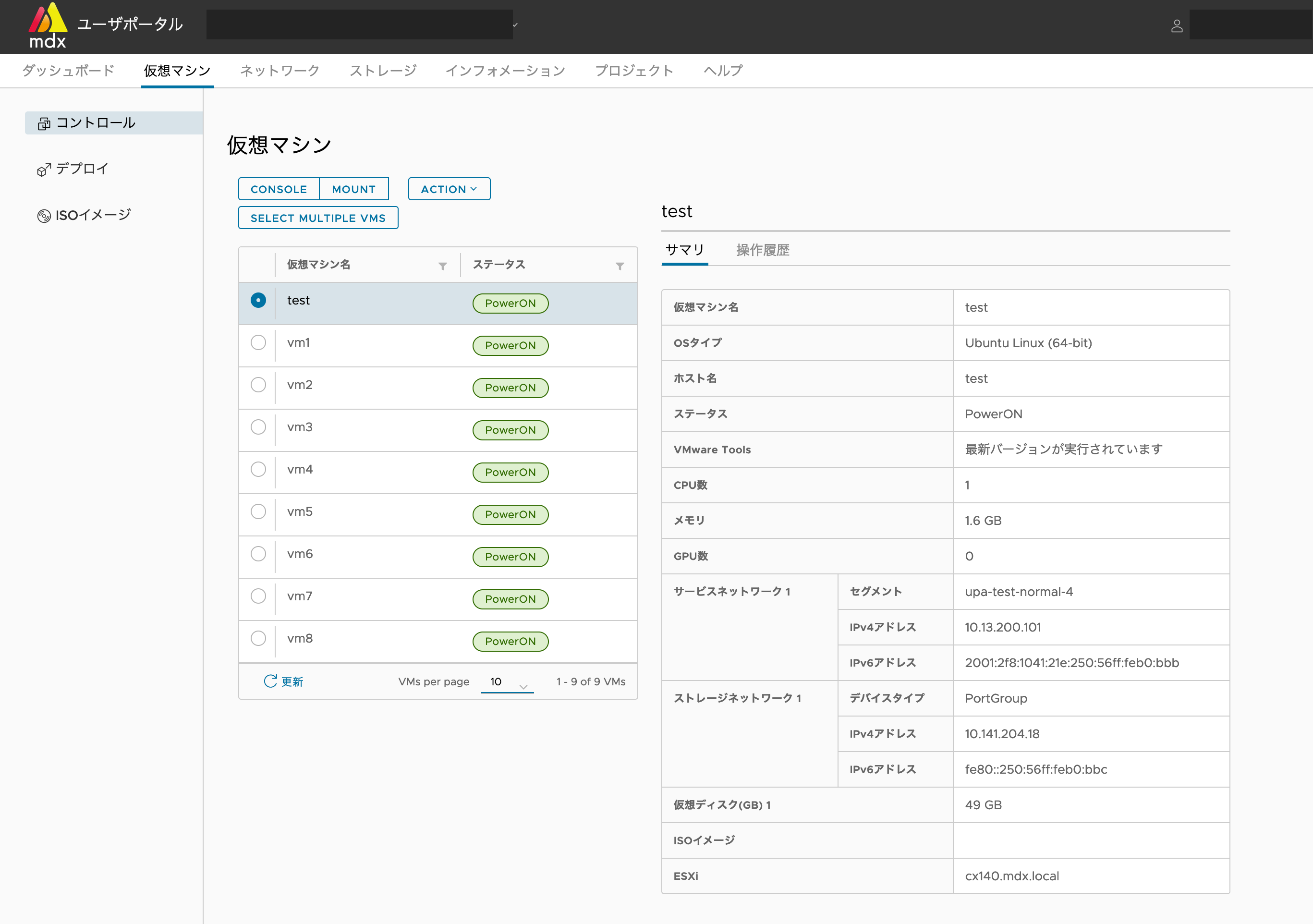

ansible-playbook を実行するVM (ControlNode)を1台と、クラスタになるVM (Managed Node)を必要な台数作成します。下の図では、 ansible-playbook を実行する test というノードをubuntu-2204-serverテンプレートからデプロイし、続いてクラスタになる vm1 から vm8 までの8台のVMを、同様にubuntu-2204-serverテンプレートから、VMデプロイ時の仮想マシン名に vm[1-8] と入力することで一度にデプロイしました。

ACLの設定やssh公開鍵の投入などは、 ネットワーク設定 や 仮想マシン利用の流れ を参照し、利用者自身の環境に合わせて実施してください。

OpenMPIやLustreストレージにRDMAで接続する場合は、ストレージネットワークを SR-IOV で作成してください。

11.3. クラスタの構築: 準備編¶

11.3.1. Ansibleのインストール¶

ansible-playbook を実行するVM(上記例では test という名前のVM)にログインし、Ansibleをインストールします (最初にわかりやすさのためにホスト名を変更しています)。ssh -A)などを用いて、このホストから各VMにmdxuserでsshできるようにしてください。mdxuser@ubuntu-2204:~$ sudo hostnamectl set-hostname ansible

mdxuser@ubuntu-2204:~$ bash

mdxuser@ansible:~$ sudo apt install ansible

Reading package lists... Done

Building dependency tree

Reading state information... Done

Suggested packages:

cowsay sshpass

The following NEW packages will be installed:

ansible

0 upgraded, 1 newly installed, 0 to remove and 17 not upgraded.

Need to get 5794 kB of archives.

After this operation, 58.0 MB of additional disk space will be used.

Get:1 http://jp.archive.ubuntu.com/ubuntu focal/universe amd64 ansible all 2.9.6+dfsg-1 [5794 kB]

Fetched 5794 kB in 1s (4666 kB/s)

Selecting previously unselected package ansible.

(Reading database ... 125879 files and directories currently installed.)

Preparing to unpack .../ansible_2.9.6+dfsg-1_all.deb ...

Unpacking ansible (2.9.6+dfsg-1) ...

Setting up ansible (2.9.6+dfsg-1) ...

Processing triggers for man-db (2.9.1-1) ...

11.3.2. machine-configsレポジトリの取得¶

次にplaybookが用意されている machine-configs のGitレポジトリをクローンしてそこに移動します。

mdxuser@ansible:~$ git clone https://github.com/mdx-jp/machine-configs

Cloning into 'machine-configs'...

remote: Enumerating objects: 785, done.

remote: Counting objects: 100% (785/785), done.

remote: Compressing objects: 100% (510/510), done.

remote: Total 785 (delta 376), reused 622 (delta 214), pack-reused 0

Receiving objects: 100% (785/785), 119.50 KiB | 9.96 MiB/s, done.

Resolving deltas: 100% (376/376), done.

mdxuser@ansible:~$ cd machine-configs/

mdxuser@ansible:~/machine-configs$ ls

ansible.cfg mdxcsv2inventory.py playbook.yml roles

files mdxpasswdinit.py README.md vars

11.3.3. inventoryファイルの作成¶

mdxcsv2inventory.py が用意されています。mdxcsv2inventory.py にダウンロードしてきたCSVファイルを与えると、CSVファイルに記載されているVMをManaged Nodeとするinventoryファイルを生成します。

mdxuser@ansible:~/machine-configs$ ./mdxcsv2inventory.py user-portal-vm-info.csv

[all:vars]

ansible_user=mdxuser

ansible_remote_tmp=/tmp/.ansible

ethipv4prefix=10.13.200.0/21

rdmaipv4prefix=10.141.200.0/21

ethipv6prefix=2001:2f8:1041:21e::/64

[default]

10.13.204.85 hostname=vm1 ethipv4=10.13.204.85 rdmaipv4=10.141.200.147

10.13.204.83 hostname=vm2 ethipv4=10.13.204.83 rdmaipv4=10.141.200.146

10.13.204.89 hostname=vm3 ethipv4=10.13.204.89 rdmaipv4=10.141.204.70

10.13.200.158 hostname=vm4 ethipv4=10.13.200.158 rdmaipv4=10.141.204.63

10.13.204.90 hostname=vm5 ethipv4=10.13.204.90 rdmaipv4=10.141.200.149

10.13.204.87 hostname=vm6 ethipv4=10.13.204.87 rdmaipv4=10.141.200.150

10.13.204.84 hostname=vm7 ethipv4=10.13.204.84 rdmaipv4=10.141.204.64

10.13.204.86 hostname=vm8 ethipv4=10.13.204.86 rdmaipv4=10.141.204.67

[default] という表記はグループを示しています。Ansibleでは、inventoryでホストをグループにまとめ、playbookの中ではグループに対してどのような処理を行うかを記述します。mdxcsv2inventory.py は全てのVMのアドレスを記載したグループとしてこの [default] を作成しています。hosts.ini というファイルに保存しておきます。mdxuser@ansible:~/machine-configs$ ./mdxcsv2inventory.py user-portal-vm-info.csv > hosts.ini

11.3.4. Ansibleを実行する前の事前準備¶

mdxpasswordinit.py を使って、inventoryファイルの [default] グループのホストに対して一気に初期パスワードを設定します。mdxuser@ansible:~/machine-configs$ ./mdxpasswdinit.py ./hosts.ini

Target hosts: 10.13.204.85, 10.13.204.83, 10.13.204.89, 10.13.200.158, 10.13.204.90, 10.13.204.87, 10.13.204.84, 10.13.204.86

New Password:

Retype New Password:

initializing the first password...

10.13.204.85: Success

10.13.204.83: Success

10.13.204.89: Success

10.13.200.158: Success

10.13.204.90: Success

10.13.204.87: Success

10.13.204.84: Success

10.13.204.86: Success

この操作はVMに対して一回だけ実行すれば大丈夫です。

11.4. Playbookの準備と実行¶

現在machine-configsが提供するVMへの操作は、下記の通りです。

Role |

Desciprition |

|---|---|

common |

ホスト名や/etc/hostsを設定し、指定したパッケージをインストールする |

desktop_common |

xrdpをインストールする |

nfs_server |

VMをNFSサーバにし、/homeをexportする |

nfs_client |

NFS越しに/homeをマウントする |

ldap_server |

VMをLDAPサーバにし、LDAPアカウントを作成する |

ldap_client |

VMをLDAPクライアントにし、LDAPサーバを参照するように設定する |

jupyter |

jupyter labをインストールし、デーモンとして起動する |

reverse_proxy |

VMをリバースプロキシにし、特定ポートへのアクセスを他のVMの特定ポートに転送する |

mpi |

OpenMPIを使えるように設定する |

playbook.yml でホストに対してRoleを適用するブロックは下記のようになっています。- name: setup NFS server

hosts: nfsserver

roles:

- nfs_server

nfsserver というホストのグループに対して、 nfs_server のRoleを適用する、という記述です。mdxcsv2inventory.py はデフォルトでは [default] というグループしか作成しません。nfsserver というグループを作成しなければなりません。[nfsserver] というセクションを追加しても大丈夫ですが、下記のように mdxcsv2inventory.py を使用してグループを作成することもできます。mdxuser@ansible:~/machine-configs$ ./mdxcsv2inventory.py user-portal-vm-info.csv -g nfsserver vm1

[all:vars]

ansible_user=mdxuser

ansible_remote_tmp=/tmp/.ansible

ethipv4prefix=10.13.200.0/21

rdmaipv4prefix=10.141.200.0/21

ethipv6prefix=2001:2f8:1041:21e::/64

[default]

10.13.204.85 hostname=vm1 ethipv4=10.13.204.85 rdmaipv4=10.141.200.147

10.13.204.83 hostname=vm2 ethipv4=10.13.204.83 rdmaipv4=10.141.200.146

10.13.204.89 hostname=vm3 ethipv4=10.13.204.89 rdmaipv4=10.141.204.70

10.13.200.158 hostname=vm4 ethipv4=10.13.200.158 rdmaipv4=10.141.204.63

10.13.204.90 hostname=vm5 ethipv4=10.13.204.90 rdmaipv4=10.141.200.149

10.13.204.87 hostname=vm6 ethipv4=10.13.204.87 rdmaipv4=10.141.200.150

10.13.204.84 hostname=vm7 ethipv4=10.13.204.84 rdmaipv4=10.141.204.64

10.13.204.86 hostname=vm8 ethipv4=10.13.204.86 rdmaipv4=10.141.204.67

[nfsserver]

# group with regexp 'vm1'

10.13.204.85 hostname=vm1 ethipv4=10.13.204.85 rdmaipv4=10.141.200.147

mdxuser@ansible:~/machine-configs$ ./mdxcsv2inventory.py user-portal-vm-info.csv -g nfsserver vm1 > hosts.ini

mdxcsv2inventory.py の -g [GROUPNAME] [VMNAME] オプションを使うことで、指定したVMの所属する任意の名前のホストグループを作成することができます。[VMNAME] の部分は正規表現になっているので、複数のVMが所属するグループを作成することもできます。[nfsserver] の他にも playbook.yml にあるように、LDAPサーバにするには [ldapserver] グループを、リバースプロキシにするには [reverproxy] グループを上記の手順で作成してください。

playbook.yml 自体を編集して、デプロイしたい環境に合わせて、不必要なRoleの適用箇所をコメントアウトしてください。desktop_common は必要無いかもしれません。inventoryの作成と playbook.yml の編集が終わったら、下記のコマンドをすると、Ansibleが全VMに設定を実施します。

mdxuser@ansible:~/machine-configs$ ansible-playbook -i hosts.ini playbook.yml

11.5. machine-configsが提供するRole¶

ここでは、machine-configsに用意されているRoleについて説明します。

11.5.1. common¶

hostname などの変数のものです。11.5.2. desktop_common¶

11.5.3. nfs_server¶

11.5.4. nfs_client¶

マウントするNFSサーバは、 [nfsserver] グループの先頭にあるVMになります。

11.5.5. ldap_server¶

machine-configs/files ディレクトリ配下に ldap_groups.csv と ldap_users.csv というファイルを作成してください。11.5.6. ldap_client¶

参照するLDAPサーバは、 [ldapserver] グループの先頭にあるVMになります。

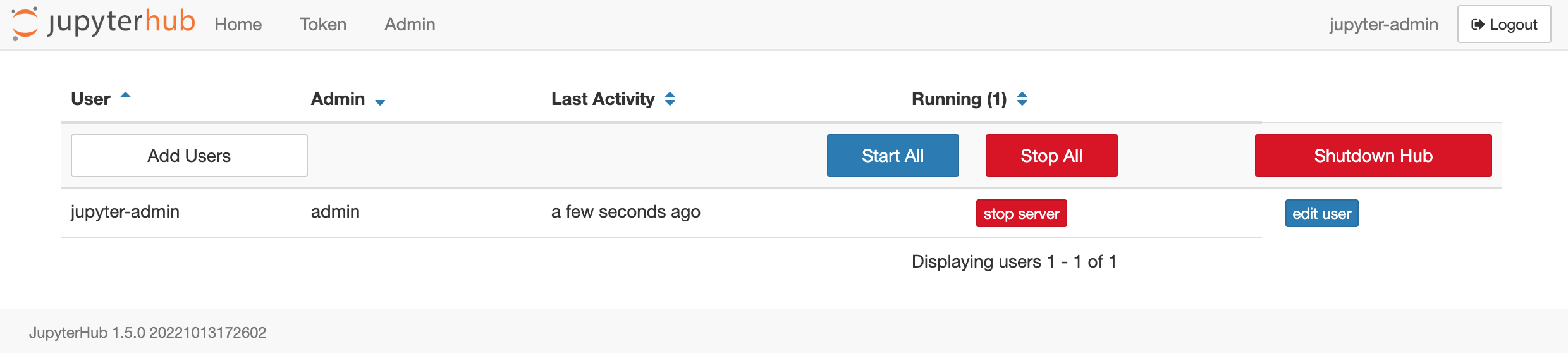

11.5.7. jupyter¶

journalctl --no-pager -u jupyterlab を実行すると、jupyterlab起動時のログからトークンつきのURLを取得できます。11.5.8. reverse_proxy¶

[default] グループのVMについて、自身の 8000 + n ポートへのアクセスを各VMの8888番ポートに転送します。 User

|

v

mdx Global IPv4

Address

|

|

+---------+ |

| Nginx | |

| (VM) | |

+----+----+ |

| ^ |

| +-----+

| Ethernet Network (Private Address)

+--------------------+------------------+------------------+

| | | |

v v v v

+--------------+ +--------------+ +--------------+ +--------------+

| Jupyterlab | | Jupyterlab | | Jupyterlab | | Jupyterlab | ...

| (VM1) | | (VM2) | | (VM3) | | (VM4) |

+--------------+ +--------------+ +--------------+ +--------------+

reverse_proxy Roleを適用したVMに DNAT を使ってグローバルIPv4アドレスをマッピングすることで、外部から各VMのjupyter labにアクセスすることができるようになります。DNATをマッピングしたら、ブラウザで http://[DNATのアドレス]:8001 にアクセスすると、上の図のVM1のJupyterlabに、 http://[DNATのアドレス]:8002 にアクセスすれば、VM2のJupyterlabにアクセスすることができます。

なお、各Jupyterlabは認証無しで起動するので、リバースプロキシになるNginxのVMには適切な ACL を設定してください。

vars/reverse_proxy.yml を編集することで、バックエンドになるVMのグループ(デフォルトは [default])やプロキシする先のポート番号(デフォルトは 8888)を変更することができます。

11.5.9. mpi¶

12. FAQ¶

12.1. ユーザポータル関連¶

12.1.1. 仮想マシンをcloneした際に、clone元とclone先に同じIPアドレスが割り当たってしまうのはなぜでしょうか?¶

一般的に、machine-idが変わらないと、同じIPアドレスが割り当たります。

cloneの手順

clone元の /etc/machine-id を空にする

clone元をシャットダウン

clone実行

なお、本操作を自動で行う機能については、実装方式を検討しています。機能が実装されるまでは、手動での対応をお願いいたします。

12.1.2. 仮想マシンに設定した公開鍵を修正したい場合はどうすればいいですか?¶

12.1.3. DNAT、ACLで何を設定したらよいのか分かりません。¶

12.1.4. 短期間に大量の資源量が必要な場合はどう対処すればよいでしょうか。¶

12.1.5. IPアドレスが長く待っても割り当たりません。割り当たっていたものが突然無くなってしまいました。¶

一般的に原因として大きく2つ考えられます。

システム障害で、何らかの理由でIPアドレスが払い出せなくなっている可能性

この場合は、特定の仮想マシンだけではなく全体で問題が発生している場合が多いです。ほかの仮想マシンでも同様のIPアドレスが払い出されない・表示されていない事象が発生しているかご確認ください。OSの問題で、IPアドレスが見えなくなっているの可能性

OSのネットワーク設定が不適切だったり、OSがハングアップしてしまっていたりすると、VMware Toolsが正しく情報を取得できない状態となり、ポータル上でIPアドレスが確認できなくなります。この場合、OSを再起動していただくか、ネットワークインタフェースの再起動をコンソールより行ってください。もし、OSの問題でなかった場合は、お手数ですがお問い合わせください。お問い合わせの際、OSの状態(アクセスできない、再起動直後か等)を付記いただくと、スムーズに調査が始められます。

12.1.6. ISOイメージからOSをインストールする際にストレージを見つけられないエラーが発生しました。¶

12.1.7. GPUパックを利用する仮想マシンの新規作成を行いましたが、エラーで仮想マシンの作成に失敗しました。¶

GPUパックを利用する仮想マシンの新規作成(デプロイ)時において、「No available ESXi found.」と出力され、 デプロイに失敗する。

仮想マシンは ESXi ホスト上で動作しますが、この ESXi ホストは (GPU の場合、物理ノードとしても) 8 GPU パックを使用する仮想マシンが最大となります。 また、運用仕様上、ESXi ホストは複数の利用者様の仮想マシンを同一 ESXi ホスト上で動作する場合があり、 GPUパック数を指定する数によっては、他の利用者様とリソースを分け合う運用となります。 そのため、GPUの空き資源の状況により、指定のGPUパック数を満たす環境が無く仮想マシンの作成失敗する 場合があります。

仮想マシンの作成に失敗した場合には、指定するGPU パック数について見直しを行い(元の指定数より減らす)、 改めて仮想マシンの新規作成(デプロイ)を実施にて確認をお願いします。

なお、一度に最大で利用可能な GPUパック数は、利用状況により変化するためご留意願います。

12.1.8. 仮想マシンのGPUパック数の変更(増加)を行いましたが、エラーで増やすことができません。¶

ユーザポータル - 仮想マシン - コントロール の画面で対象の仮想マシンを選択します。

(利用者様にて仮想マシンを起動していた場合) 操作アイコンの「ACTION」で表示される一覧より、電源 - シャットダウン を実行します。(OS コマンドによりシャットダウンしても問題ありません)

仮想マシン停止後、同じようにACTIONから、メンテナンス - 仮想マシンの休止を実行します。

仮想マシンの休止完了後、同じようにACTIONから、「ACTION」から、「構成変更」を選択しGPUパック数の変更を実施します。

仮想マシンを起動頂き利用可能となったことをご確認願います。

12.1.9. 仮想マシンの電源をオンにしても起動しません。操作履歴のステータスが10%から進まず、シャットダウン操作もできません。¶

12.1.10. スポット仮想マシンの強制停止通知メールを受け取りましたが停止時間になっても対象マシンが停止されません。なぜでしょうか。¶

スポット仮想マシンの強制停止処理は こちらの周期処理ルール にしたがって実施されます。

仮想マシンAの起動に必要な資源が仮想マシンBを停止せずとも確保可能となった場合

仮想マシンAが起動を中止した場合

のケースのいずれかに該当する場合は、仮想マシンBは強制停止の対象から除外されます。

12.2. 仮想マシンへの接続関連¶

12.2.1. どうすれば自分の環境から起動中の仮想マシンにsshで接続できますか?¶

なお、本設定はセキュリティに関わる重要な設定です。利用者の責任において各設定を行ってください。

12.2.2. デスクトップと仮想マシン間でファイルのやり取りを行うためにはどうすればいいですか?¶

12.2.3. 仮想マシンへsshログイン後、一定の時間が経過すると切断されてしまう。対応方法を教えてください。¶

mdxのファイヤーウォールでは、無通信のまま30分以上が経つと切断する設定となっています。

サーバあるいはクライアント側で無通信状態による接続断を防ぐための以下を参考に対応をお願いします。

Windows の場合、SSH クライアント (Putty、TeraTerm 等) で keep-alive 設定を行う。

サーバ側の sshd_config や ssh_config の設定 (ClientAliveInterval、ClientAliveCountMax)を行う。

12.3. 仮想マシン環境設定関連¶

12.3.1. 仮想マシンに静的アドレスを設定したい。¶

仮想マシンに静的アドレスを設定する場合、事前に以下の情報を確認する必要があります。

仮想マシンに設定するIPアドレス

仮想マシンに設定されているセグメントに対して提供されているIPアドレス範囲のうち、ホストアドレスが1~100の範囲のIPアドレスを指定してください。- 仮想マシンに設定されているセグメントは、上部メニュー[仮想マシン]をクリックしてメイン画面に表示される仮想マシンの一覧から任意の仮想マシンを選択し、右のサマリ情報内サービスネットワーク>セグメントより確認できます。

- セグメントに割り振られるIPアドレスの範囲は、上部メニュー[ネットワーク]をクリックしてメイン画面に表示されるセグメントの一覧から上記で確認したセグメントを選択し、右に表示されるIPアドレス範囲から確認します。

例) IPアドレス範囲に「10.12.120.0/21」と記載されていた場合、IPアドレスは「10.12.120.1」~「10.12.120.100」で指定します。その他ネットワークの各種設定で利用するIPアドレスは、以下の通りです。

- デフォルトゲートウェイアドレス:仮想マシンに設定されているセグメントに対して提供されているIPアドレス範囲のうち、最後から2番目のアドレスになります。例)IPアドレス範囲に「10.12.120.0/21」と記載されていた場合、10.12.127.254です。

- ブロードキャストアドレス:仮想マシンに設定されているセグメントに対して提供されているIPアドレス範囲のうち、最後のアドレスになります。例)IPアドレス範囲に「10.12.120.0/21」と記載されていた場合、10.12.127.255です。

NTPサーバ:172.16.2.[26,27]をご利用ください。

DNSサーバ:172.16.2.[26,27]をご利用ください。もしくはPubic DNS(例えば、Googleが提供するPublic DNSサーバ 8.8.8.8 など)をご利用ください。※

※DNATにてグローバルIPアドレスを設定している場合は、上記のPublic DNSサーバに対するアクセスができなくなるため、DNSによる名前解決ができなくなります。DNATとPublic DNSサーバを同時に利用する場合は、ネットワークのACLでPublic DNSサーバに対するアクセス許可ルールを追加してください。ACLフィルタルール例:srcアドレス: 8.8.8.8

SrcPrefix長/32

srcポート: 53

Dstアドレス: VMのアドレス

DstPrefix長: 32

Dstポート: any

「サービスネットワーク1」のインタフェースデバイス名

仮想マシンのターミナルを開き、「ip -br addr」コマンドを実行することで確認できます。「サービスネットワーク1」のIPアドレスが表示された行の1カラム目に出力している項目が、インタフェースデバイス名になります。以下の実行例で、「サービスネットワーク1」のIPアドレスが「10.18.50.248/21」である場合、インタフェースデバイス名は「ens192」となります。

$ ip -br addr lo UNKNOWN 127.0.0.1/8 ::1/128 ens192 UP 10.18.50.248/21 metric 100 2001:2f8:1041:2ab:250:56ff:feb0:62ba/64 fe80::250:56ff:feb0:62ba/64 ens224 UP 10.146.50.88/21 metric 100 fe80::250:56ff:feb0:62bb/64

ここからは仮想マシンテンプレート別に静的アドレスの設定方法の一例を紹介します。

12.3.1.1. 仮想マシンテンプレート「10_Rocky9 (Vendor)」の場合¶

ユーザポータルの上部メニューから[仮想マシン]をクリックします。

メイン画面で静的アドレスを設定する任意の仮想マシンを選択した状態で[CONSOLE]をクリックします。

仮想マシンのコンソール(もしくはターミナル)上で、nmtuiツールを起動します。

$ sudo nmtui

[Edit a connection]にカーソルを合わせてEnterキーを押します。

「サービスネットワーク1」のインタフェースデバイス名にカーソルを合わせてEnterキーを押します。

[IPv4 CONFIGURATION]右側の[<Automatic>]にカーソルを合わせてEnterキーを押します。

表示される項目のうち[<Manual>]にカーソルを合わせてEnterキーを押します。

[IPv4 CONFIGURATION]右側の[<Show>]にカーソルを合わせてEnterキーを押します。

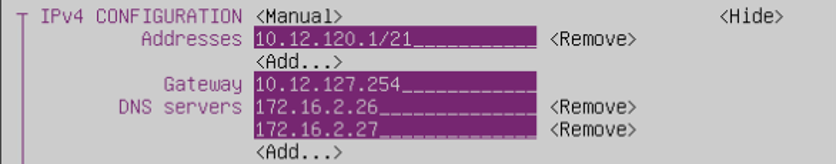

各項目を選択して上記で決定した設定内容を入力します。なお、[Addresses]にはネットマスクの値を合わせて記載ください(以下入力例)。

入力が完了したら画面下部の[<OK>]にカーソルを合わせてEnterキーを押します。

画面下部の[<Back>]にカーソルを合わせてEnterキーを押します。

[Activate a connection]にカーソルを合わせてEnterキーを押します。

「サービスネットワーク1」のインタフェースデバイス名にカーソルを合わせてEnterキーを押し,右側に[<Activate>]と表示されることを確認します。

「サービスネットワーク1」のインタフェースデバイス名にカーソルを合わせて再度Enterキーを押し,右側に[<Deactivate>]と表示されることを確認します。

以上で設定は完了です。

12.3.1.2. 仮想マシンテンプレート「10_Ubuntu 22.04 LTS (Vendor)」、「10_Ubuntu 24.04 LTS (Vendor)」の場合¶

以下「/etc/netplan/99-mdx-setup.yaml」を直接編集する場合の設定方法の一例です。

「/etc/netplan/99-mdx-setup.yaml」ファイルを開き、静的IPアドレスを定義

$ sudo vi /etc/netplan/99-mdx-setup.yaml

【編集前】

network: ethernets: ens224: dhcp4: true ens192: dhcp4: true version: 2

【編集後】

network: ethernets: ens224: dhcp4: true ens192: dhcp4: false addresses: - 10.18.48.51/21 routes: - to: default via: 10.18.55.254 nameservers: addresses: - 172.16.2.26 - 172.16.2.27 version: 2

設定の反映

$ sudo netplan apply

12.3.2. ストレージネットワーク(PVRDMA)を利用した環境もストレージネットワーク(SR-IOV)の環境と同様なRDMA によるノード間通信環境が構築可能ですか?¶

PVRDMA (準仮想化RDMA):

ノード間の RDMA 通信は可能。ただし、ストレージ (Lustre) は TCP 接続となります。

SR-IOV:

ノード間、ストレージ (Lustre) も含め RDMA による通信となります。

12.3.3. GPU仮想マシン上でnvidia-smiを使うとGPU-UtilがN/Aと表示されて利用できないGPUがある。¶

GPUの状態を確認 (以下の場合、GPU ID 1でMIGが有効化されているため、通常のGPUとして使用できません(MIGとしては利用可能です)。

mdxuser@ubuntu-2204:~$ nvidia-smi Mon Jul 10 22:11:43 2023 +---------------------------------------------------------------------------------------+ | NVIDIA-SMI 535.54.03 Driver Version: 535.54.03 CUDA Version: 12.2 | |-----------------------------------------+----------------------+----------------------+ | GPU Name Persistence-M | Bus-Id Disp.A | Volatile Uncorr. ECC | | Fan Temp Perf Pwr:Usage/Cap | Memory-Usage | GPU-Util Compute M. | | | | MIG M. | |=========================================+======================+======================| | 0 NVIDIA A100-SXM4-40GB Off | 00000000:03:00.0 Off | 0 | | N/A 24C P0 42W / 400W | 4MiB / 40960MiB | 0% Default | | | | Disabled | +-----------------------------------------+----------------------+----------------------+ | 1 NVIDIA A100-SXM4-40GB Off | 00000000:05:00.0 Off | On | | N/A 24C P0 43W / 400W | 0MiB / 40960MiB | N/A Default | | | | Enabled | +-----------------------------------------+----------------------+----------------------+ | 2 NVIDIA A100-SXM4-40GB Off | 00000000:0D:00.0 Off | 0 | | N/A 25C P0 49W / 400W | 4MiB / 40960MiB | 0% Default | | | | Disabled | +-----------------------------------------+----------------------+----------------------+ | 3 NVIDIA A100-SXM4-40GB Off | 00000000:0F:00.0 Off | 0 | | N/A 25C P0 48W / 400W | 4MiB / 40960MiB | 0% Default | | | | Disabled | +-----------------------------------------+----------------------+----------------------+ +---------------------------------------------------------------------------------------+ | MIG devices: | +------------------+--------------------------------+-----------+-----------------------+ | GPU GI CI MIG | Memory-Usage | Vol| Shared | | ID ID Dev | BAR1-Usage | SM Unc| CE ENC DEC OFA JPG | | | | ECC| | |==================+================================+===========+=======================| | No MIG devices found | +---------------------------------------------------------------------------------------+ +---------------------------------------------------------------------------------------+ | Processes: | | GPU GI CI PID Type Process name GPU Memory | | ID ID Usage | |=======================================================================================| | No running processes found | +---------------------------------------------------------------------------------------+

MIGは sudo nvidia-smi -i <GPU ID> -mig 0 で無効化できます。無効化すると以下の通り、MIG devices: の表示が消え、GPU-UtilがN/Aから0%になります。